Mens du ser WWDC21 keynote for et par uger siden begyndte jeg at bemærke et tilbagevendende tema. Og det tema er, at flere af de kommende iOS 15-funktioner ser ud til at udnytte iPhones neurale motor.

Neural Engine har været i iPhone siden udgivelsen af iPhone X i 2017. Jeg tror dog ikke, at de fleste af os overhovedet har følt virkningerne af denne processor i løbet af de fire år siden dens første udgivelse.

WWDC21 blev ved med at give mig denne følelse af, at iOS 15 er den første futuristiske iOS-opdatering i lang tid. Og selvom der ikke er en officiel bekræftelse fra Apple på dette, tror jeg, det skyldes, at Apple endelig udnytter Neural Engine fuldt ud.

I dette indlæg vil jeg kort dække, hvad Neural Engine er, så vil jeg dykke ned i alle de nye iOS 15-funktioner, der ser ud til at bruge denne processor til sit fulde potentiale. Nær slutningen vil jeg dække de vigtigste måder, som iOS i øjeblikket bruger Neural Engine, så du kan sammenligne den med den kommende iOS 15-udgivelse.

Okay, lad os komme ind i det!

Indhold

- Hvad er den neurale motor på iPhone?

-

Hvordan iOS 15-funktioner begynder at drage fordel af den neurale motor

- Din iPhone kan læse tekst i dine billeder

- iOS 15-funktioner giver din iPhone mulighed for at genkende og identificere indhold på dine billeder

- Erindringer i Fotos vil være mere sofistikerede og "rigtige" følelse

- Notifikationer, Widgets og Forstyr ikke bliver smartere

- Nye iOS 15-funktioner vil gøre det nemmere at få rutevejledning med dit kamera

- Siri vil udføre mere behandling på din enhed

-

Hvad kan Neural Engine uden de kommende iOS 15-funktioner?

- Neural Engine hjælper dig med at tage bedre billeder

- Maskinlæring gør FaceID hurtigt, sikkert og adaptivt

- Neural Engine spiller en nøglerolle i AR-oplevelser på iPhone

-

De kommende iOS 15-funktioner peger mod en smartere fremtid for iPhone

- Relaterede indlæg:

Hvad er den neurale motor på iPhone?

Neural Engine er en processor på iPhone X og nyere, der håndterer maskinlæringsoperationer. Det er denne processors evne til at drive maskinlæring, der gør det så vigtigt, så det er vigtigt at forstå maskinlæring for at forstå denne processor.

Maskinlæring refererer til software, der træffer beslutninger om, hvilken kode der skal udføres uafhængigt af en programmør.

Typisk skal software arbejde med meget specifikke og kontrollerede data. Det er derfor, Siri vil forstå din hensigt med én sætning, men undlade at forstå den med en anden - selvom hensigten i hver sætning er identisk. Siri har brug for, at dataene kommer i en bestemt struktur, ellers fejler det.

Machine learning er en måde at ændre det på. Det giver software mulighed for at tage mindre strukturerede data ind og stadig behandle dem. Hvis du nogensinde bliver overrasket over, at Siri forstod en underligt formuleret anmodning, er det sandsynligvis, fordi Siris maskinlæringsfunktioner er blevet forbedret.

Neural Engine er, som navnet antyder, motoren på din telefon, der gør dette muligt.

Jeg er klar over, at disse begreber kan være lidt svære at forstå, og jeg ved, at jeg måske ikke gør det bedste stykke arbejde med at forklare dem. Jeg prøver at holde tingene korte og enkle for dette indlæg, men hvis du vil have et dybere dyk, bør du tjekke ud dette indlæg!

Hvordan iOS 15-funktioner begynder at drage fordel af den neurale motor

Problemet med iPhones neurale motor er ikke, at den ikke er stærk, men at dens kraft ikke udnyttes fuldt ud på iPhone. I de sidste fire år er det blevet sat til at fungere i begrænsede tilfælde, som f.eks. augmented reality. Det er nyttigt, men det har ikke revolutioneret iPhone endnu.

Jeg tror, at flere iOS 15-funktioner peger på en mere revolutionerende fremtid for Neural Engine. Jeg tror ikke, at nogen af de nye funktioner, jeg er ved at nedbryde nedenfor, ville være mulige uden denne processor. Så lad os se, hvordan disse funktioner bruger Neural Engine fuldt ud.

Din iPhone kan læse tekst i dine billeder

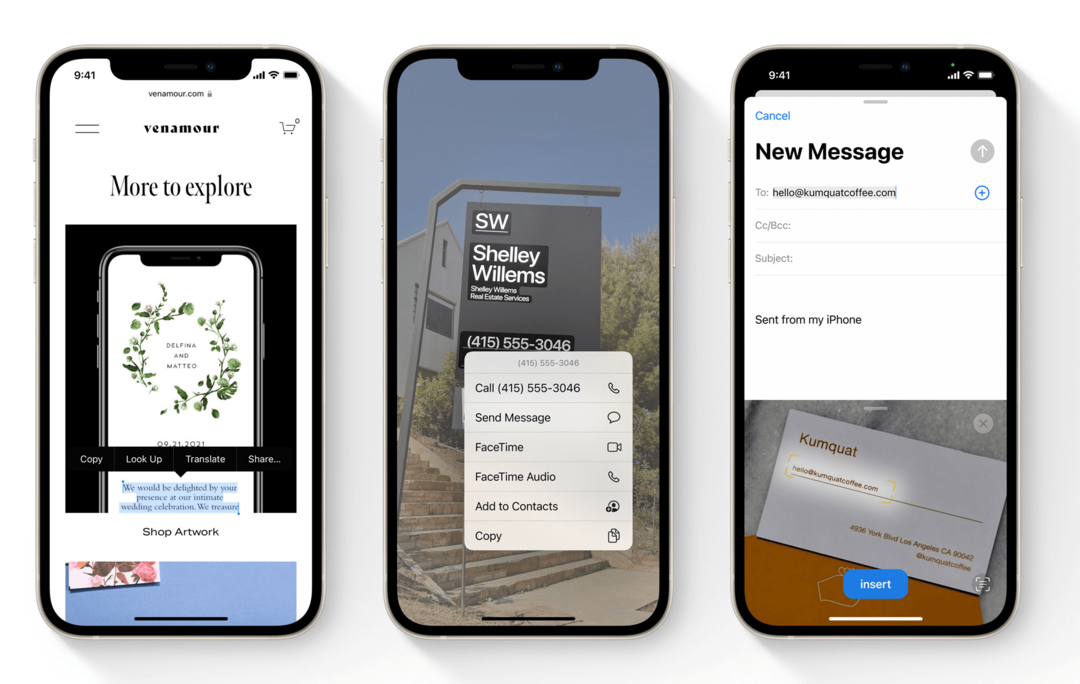

Den første af iOS 15-funktionerne, der skreg "Machine Learning!" for mig var Live Text. Live Text er en funktion i iOS 15, der gør det muligt for din iPhone at læse tekst i din Fotos-app.

Det betyder, at du kan tage et billede af hvad som helst med trykt tekst på, åbne det billede i Fotos-appen, og du vil være i stand til at interagere med den tekst. Du kan trykke på telefonnumre på billeder, kopiere og indsætte tekst fra billeder af dokumenter og bruge søgelinjen i Fotos til at søge efter tekst i billeder.

Denne funktion giver også din iPhone mulighed for at læse håndskrift i dine billeder. Det fungerer også med Camera-appen, så du kan interagere med tekst i dit iPhone-kameras søger i realtid.

Uden maskinlæring ville en funktion som denne være næsten umulig. Det er derfor, disse online sikkerhedstests bruger forvrænget tekst til at bevise, at du ikke er en robot. For det er udfordrende for et program at kunne læse tekst.

Ikke alene er en smartphone-funktion, der kan læse tekst uanset skrifttype, stil, farve eller vinkel, i realtid ekstremt nyttig, den er også en fremragende brug af mobil maskinlæring.

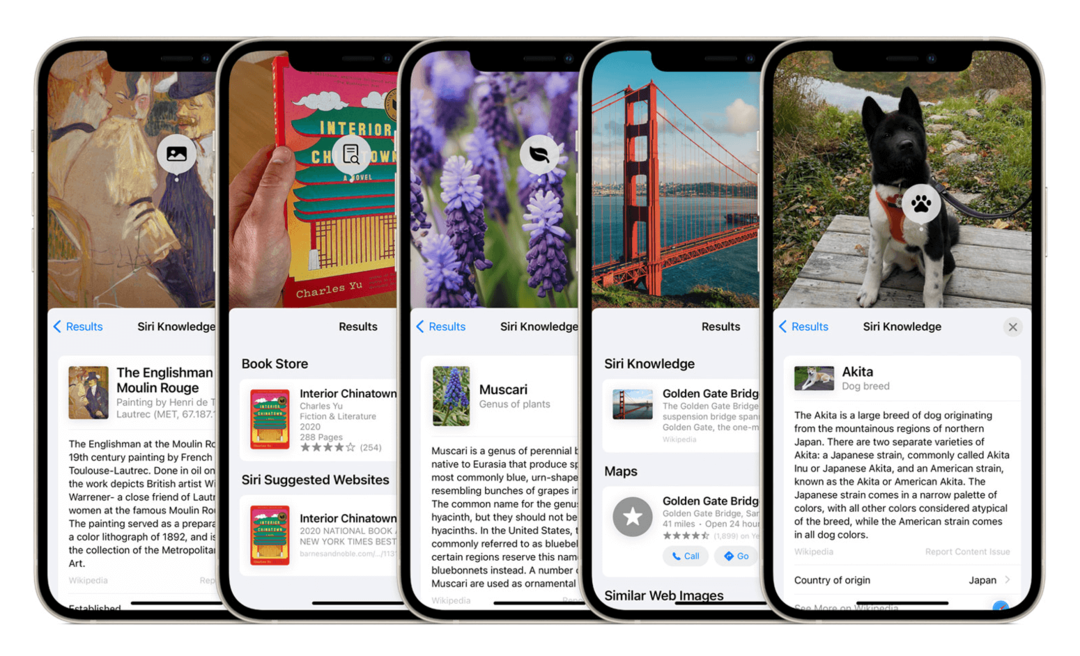

iOS 15-funktioner giver din iPhone mulighed for at genkende og identificere indhold på dine billeder

En anden af de nye iOS 15-funktioner, der bruger Neural Engine, er objektgenkendelse i Fotos. Denne funktion fungerer på samme måde som Live Text, bortset fra at den genkender objekter i stedet for tekst. Eksemplet Apple brugte er, at du kan pege dit iPhone-kamera mod en hund, og din iPhone vil ikke kun genkende, at det er en hund, men også hvilken hunderace det er.

iPhone har været i stand til at trække ansigter ud fra dine billeder i et stykke tid, hvilket er en form for genkendelse af objekter, omend begrænset. Denne udvidelse af denne kapacitet vil give din iPhone mulighed for hurtigt at se på de ustrukturerede data for et foto og identitetsobjekter i det.

Dette er mere imponerende (og vanskeligt) end Live Text, da de mønstre, Neural Engine skal lede efter, vil være langt mindre konsistente. Din iPhone skal tage tusindvis (hvis ikke hundredtusindvis) af beslutninger for at kunne træffe sådanne beslutninger.

For at identificere en hunderace skal den først se, at en hund er et særskilt objekt fra baggrunden, derefter skal den tegne grænser omkring den hund, derefter udvælg forskellige karakteristika for den hund, indtil den kan fastslå, at det er en hund, og træk derefter endnu flere karakteristika ud for at bestemme, hvilken slags hund det er er.

Den slags databehandling er kun mulig med en maskinlæringsprocessor.

Erindringer i Fotos vil være mere sofistikerede og "rigtige" følelse

En anden funktion i Photos-appen, der vil få en Neural Engine-touchup, er Memories.

Denne funktion tager billeder fra et bestemt tidspunkt (normalt en bestemt dag) og kombinerer dem i en kort video, som du kan se. Ideen er, at Memories automatisk vil skabe videocollager af dine ferier, fester, jubilæer og mere.

Erindringer er en anden af iOS 15-funktionerne, der får et markant bump i kvalitet. Det vil automatisk inkorporere musik fra dit Apple Music-bibliotek i dine minder.

Musikken, som Fotos vælger, vil ikke kun være i passende tempo med videoen, men den bør også matche videoens indhold. For eksempel bør billeder fra en fest parres med energisk musik, mens mere gennemtænkte billeder bør have langsommere musik knyttet.

Selvom jeg ikke bruger denne funktion ofte, er computervidenskaben bag den ekstremt fascinerende. Den kombinerer genkendelse af objekter og landskaber, grupperer fotos baseret på indhold, placering og tidsperiode, adskiller gennemsnitlige dag-for-dag-billeder fra fotos, der er knyttet til et særligt liv begivenheder, tegner en forbindelse mellem stemningen i disse fotos til stemningen i en sang, du kan lide, parrer dem i en diasshowpræsentation og tidspunkter for præsentationen i takt med musik.

Memories har altid brugt Neural Engine. Og den næste version af iOS er indstillet til at øge intelligensen af denne funktion væsentligt.

Notifikationer, Widgets og Forstyr ikke bliver smartere

En gruppe af iOS 15-funktioner, der drager større fordel af Neural Engine, er meddelelser, widgets og Forstyr ikke.

Widgets begyndte at bruge maskinlæring i iOS 14, men jeg tænkte, at det ville være nyttigt at tilføje dem her. Smart Stacks giver dig mulighed for at lægge widgets oven på hinanden. Din iPhone vil derefter bladre gennem dem i løbet af dagen og vise dig, hvad den mener er den mest relevante widget på et givet tidspunkt.

Denne slags beslutninger træffes ved at analysere din adfærd på forskellige tidspunkter af dagen og efter brug af bestemte apps. Neural Engine tager disse data, fortolker dem og viser derefter dine widgets i henhold til disse data.

Nye iOS 15-funktioner er indstillet til at fungere meget ens.

Notifikationer vil nu blive grupperet i en notifikationsoversigt, så du ikke ser mindre vigtige notifikationer, der trænger op på din låseskærm hele dagen. Du kan tilpasse funktionen Notifikationsoversigt eller lade Neural Engine håndtere det for dig.

Forstyr ikke får en ny komponent, Focus, som skjuler visse meddelelser baseret på, hvordan de er kategoriseret. Du kan styre Focus manuelt, eller lade det styre sig selv intelligent.

Alle tre af disse funktioner kommer til at bruge ekstremt lignende maskinlæringsmålinger til at forudsige og tilpasse sig din adfærd.

Nye iOS 15-funktioner vil gøre det nemmere at få rutevejledning med dit kamera

Dette er en af iOS 15-funktionerne, som jeg ikke har hørt så meget begejstring om, som jeg havde forventet. Jeg synes stadig, det er meget interessant, især i en maskinlæringssammenhæng.

I Maps i iOS 15 vil du være i stand til at pege dit kamera rundt, mens du går. Det giver dig mulighed for at se AR-retninger projiceret på dit miljø. Lad os sige, at du prøver at komme i biografen og ikke er sikker på, hvilken vej du skal tage. Du vil være i stand til at pege rundt på din iPhone og se anvisninger fremhævet på gaderne og bygningerne omkring dig.

Augmented Reality på iPhone blev muliggjort af inkluderingen af Neural Engine, så denne funktion skylder sin oprindelse til maskinlæring. Men denne funktion kombinerer også AR med billedgenkendelse og lokationsregistrering for at give en utrolig oplevelse i realtid.

Selvom den kun vil være tilgængelig i nogle få byer ved lanceringen, peger denne funktion på en fremtid, hvor maskinlæring på iPhone ikke kun hjælper dig i baggrunden. Det vil være i stand til at hjælpe dig med at opnå ting med det samme, som er uden for din komfortzone eller evne.

Siri vil udføre mere behandling på din enhed

Den sidste af iOS 15-funktionerne, der drager større fordel af Neural Engine, er Siri. Siri har altid brugt maskinlæring. Men den læring har endnu ikke udnyttet potentialet i Neural Engine.

Det skyldes, at Siri har brugt behandling uden for enheden. Det betyder, at din iPhone lytter til din anmodning, sender den til en Apple-server, der behandler anmodningen, og derefter sender den tilbage til Siri på din iPhone for at reagere på denne anmodning.

Grunden til, at dette blev gjort, var at øge Siri-kraften ud over, hvad iPhone kunne understøtte. I iOS 15 er dette dog indstillet til at ændre sig. Siri vil nu udføre størstedelen af sin behandling på din iPhone. Det skulle gøre Siri hurtigere, smartere og mere pålidelig.

Jeg tror, at denne opdatering sandsynligvis vil kræve den mindste hjælp fra Neural Engine. Derfor dens placering i slutningen af listen. Det er dog værd at bemærke, da det peger på, at Siri bliver klogere. En mere dygtig assistent, der bruger hardwaren på iPhone, ikke en fjern server.

Hvad kan Neural Engine uden de kommende iOS 15-funktioner?

Og det er det! Så vidt jeg kan se, er det alle de nye måder, som iOS 15-funktioner vil begynde at bruge Neural Engines råkraft på.

Jeg ønskede at inkludere et kort afsnit i slutningen af dette indlæg, der fremhæver nogle af de ting, som Neural Engine allerede gør på din iPhone. På den måde kan du sammenligne, hvor det er i dag, med hvor det vil være om et par måneder.

Forhåbentlig vil dette hjælpe dig med at værdsætte de kommende ændringer til iOS i et nyt lys og bedre forstå, hvordan funktioner som denne kommer til din iPhone.

Neural Engine hjælper dig med at tage bedre billeder

Jeg vil sige, at den største brug af Neural Engine på iPhone siden 2017 har været inden for fotografering. Hvert år viser Apple, hvordan den nyeste iPhone vil være i stand til at udføre flere fotografiske beregninger end den forrige generation. Apple siger ting som: "Billedprocessoren foretager X millioner beregninger/beslutninger pr. billede".

Dette refererer til antallet af beregninger, som Neural Engine foretager, hver gang du tager et billede. Den ser på farverne, belysningen, kontrastelementerne, motivet, baggrunden og en lang række andre faktorer. Og det bestemmer, hvordan man bedst vurderer, justerer, absorberer og afbalancerer alle disse elementer på et øjeblik.

Det er denne maskinlæringsproces, der har gjort ting som Portrait Mode og Deep Fusion mulige. Portrættilstand kan isolere dig fra din baggrund, og Deep Fusion har gjort natfotografering på iPhone væsentligt bedre end før.

Neural Engine er afgørende for din iPhones kamera på grund af hardwarebegrænsninger. På grund af iPhones størrelse er kameraet og dets linser begrænset i kapacitet. Det er computer- og maskinlæring, der sker, når du tager et billede, der gør din iPhone-fotografering på niveau med billeder fra et professionelt DSLR.

Maskinlæring gør FaceID hurtigt, sikkert og adaptivt

Selvfølgelig kan vi ikke tale om Neural Engine uden at nævne, hvorfor den blev skabt.

Det er rigtigt - Neural Engine blev tilføjet til iPhone X for at gøre FaceID muligt. Hvis du ikke vidste det, er FaceID en af de mest sofistikerede og komplekse funktioner på din iPhone.

FaceID sammenligner ikke kun 2D-billedet af dit ansigt i selfie-kameraet med et andet 2D-billede af dit ansigt. Den ser på et 3D-kort over dit ansigt, sporer dine øjenbevægelser og sammenligner det med en tidligere 3D-scanning af dit ansigt.

FaceID gør ikke bare dette på mindre end to sekunder, mens dit ansigt er i bevægelse, delvist skjult og i forskellige vinkler. Den tilpasser sig også den måde, dit ansigt subtilt ændrer sig fra dag til dag. Derfor kan du dyrke skæg, blive ældre og ændre dig på andre subtile måder uden at skulle scanne dit ansigt igen.

FaceID og Neural Engine studerer og lærer af dit ansigt, hver gang du låser din iPhone op. Uden Neural Engine ville FaceID ikke være halvt så hurtigt, sikkert eller pålideligt, som det er i dag.

Neural Engine spiller en nøglerolle i AR-oplevelser på iPhone

Endelig spiller Neural Engine en nøglerolle i AR på iPhone. For dem, der ikke ved det, er Augmented Reality (AR) en funktion, der projicerer 3D-modeller på dit miljø gennem dit iPhone-kameras søger. Du kan selv teste dette ved at bruge Mål-appen på din iPhone.

Denne form for funktion kombinerer ting som billedgenkendelse, rumlig bevidsthed og hukommelse. Alt dette kræver den kraft, som Neural Engine bringer til bordet.

Heldigvis er mange af de nye iOS 15-funktioner indstillet til at gøre AR på iPhone endnu mere kraftfuld. Det er en tendens, jeg håber fortsætter, da jeg tror, at AR har potentialet til at være en af de mest integrerede funktioner i mobile enheder.

De kommende iOS 15-funktioner peger mod en smartere fremtid for iPhone

I det hele taget er jeg meget spændt på fremtiden, som disse iOS 15-funktioner giver os et glimt af. Der er flere facetter af iPhone, der føles en smule underudnyttet, men få så meget som Neural Engine har været. Jeg ser frem til, at dette ændrer sig, og jeg håber, at du også gør det!

For flere nyheder, indsigt og tips om alt, hvad Apple har, kan du se resten af AppleToolBox-bloggen!