I sin stræben efter at holde tingene enkle, men alligevel banebrydende, har Apple udforsket måder at gøre nogle få kamera- og billedfunktioner mere innovative og nemme at bruge.

I et patent udstedt i dag, 9,423,873, har Apple undersøgt muligheden for at gengive dynamiske tredimensionelle billeder på en todimensionel brugergrænseflade.

Bærbare elektroniske enheder, der generelt er designet til brug af en enkelt person, bruger typisk todimensionelle billeder på brugergrænsefladeskærmen.

Dette patent giver metoder til at gengive tredimensionelle billeder på brugergrænsefladeskærmene. For at gøre disse tredimensionelle billeder mere engagerende, udforsker patentet teknikker, der ville tillade en bruger at "se sig omkring" på billedet og derved gøre disse billeder mere interessante.

Så hvis du så på et 3D-gengivet billede af en skulptur på din iPhone, og du ville se på detaljerne på højre side af den viste skulptur; når du vippede dit hoved for at se på højre side, ville billedet justeres baseret på bevægelsen og vise, at detaljerne fra højre side ville blive vist.

Den nuværende offentliggørelse i patentet udnytter denne naturlige adfærd og styrer præsentationen af billeder baseret på den relative position og orientering af brugerens hoved og/eller øjne i forhold til brugergrænsefladeskærmen, når der vises tredimensionale billeder.

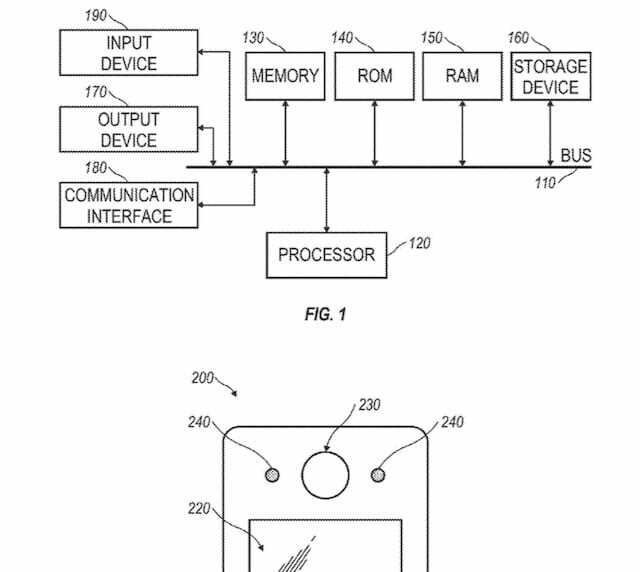

Ifølge patentet kan accelerometer(e) eller lignende bevægelsessensorer indbygges i håndholdte enhedsversioner af systemet til at hjælpe med at spore den relative hovedposition, når enheden bevæges i forhold til brugerens hoved og øjne.

Teknikkerne beskrevet i dette patent peger på et tidligt forsøg på at fremvise mixed reality-applikationer.

Det, der skiller sig ud i denne afsløring, er, at den ikke peger på et andet eksempel på fremvisning af 3D-billeder på dine iPhones via nogle 3D-briller. Det er snarere at udforske måder at gengive et 3D-billede til en 2D-overflade og give brugeren mulighed for at interagere med billedet ved brug af simple bevægelser.

Vi har allerede set nye applikationer på iPhone/iOS, der bliver brugt at spore brugerens øjenbevægelser uden behov for noget særligt udstyr.

Denne nye funktion giver dybdeopfattelsen og andre karakteristika for et 3D-objekt i 2D-gengivelse og får brugeren til at interagere med billedet kan have større konsekvenser, især hvis det kan anvendes til online e-detailhandel og andre brugssager.

Sudz (SK) er besat af teknologi siden den tidlige ankomst af A/UX til Apple, og er ansvarlig for den redaktionelle ledelse af AppleToolBox. Han er baseret i Los Angeles, CA.

Sudz har specialiseret sig i at dække alt hvad angår macOS, efter at have gennemgået snesevis af OS X- og macOS-udviklinger gennem årene.

I et tidligere liv arbejdede Sudz med at hjælpe Fortune 100-virksomheder med deres ønsker om teknologi og forretningstransformation.