Während der Google I/O 2019 kündigte Google drei neue APIs im ML Kit und die Erweiterung von Firebase Performance Monitoring für Webentwickler an.

Die mobile Entwicklungsplattform von Google, Firebase, erhält dieses Jahr ihr größtes Update auf der jährlichen Entwicklerkonferenz von Google, Google I/O. Heute hat Google neue Möglichkeiten angekündigt, mit denen es die Zugänglichkeit von maschinellem Lernen für Entwickler verbessert. Google erweitert außerdem seine Tools zur Leistungsüberwachung, um Webentwicklern dabei zu helfen, ihre Web-Apps zu beschleunigen.

Google hat ML Kit angekündigt bei der letztjährigen I/O um Entwicklern das Geheimnis des maschinellen Lernens zu entlocken. Sie begannen mit einigen APIs für die gängigsten Anwendungsfälle und erweitern dieses Jahr das SDK um 3 neue APIs: eine geräteinterne API für die Übersetzung, eine API für die Objekterkennung und -verfolgung und eine API zum einfachen Erstellen benutzerdefinierter ML Modelle. Native App-Entwickler können das Performance Monitoring SDK in ihre App integrieren, um Leistungsdaten zu sammeln, die sie dann in Firebase Performance Monitoring analysieren können. Bald können Webentwickler auch die Leistung ihrer Web-Apps in Firebase verfolgen. Ich habe mit Francis Ma, Head of Product bei Firebase, gesprochen, um mehr über diese Änderungen zu erfahren.

Neue ML-Kit-APIs

Das ML SDK von Google unterstützt derzeit 7 APIs: Texterkennung, Gesichtserkennung, Barcode-Scannen, Bildbeschriftung, Orientierungspunkterkennung, intelligente Antwort und Spracherkennung. Die letzten 2 waren nur kürzlich im April hinzugefügt, aber jetzt werden sie durch die drei oben genannten APIs ergänzt. Hier ist eine allgemeine Zusammenfassung der drei neuen ML-APIs für Entwickler:

- On-Device-API für die Übersetzung: Mithilfe des gleichen Modells, das auch für die Offline-Übersetzung der Google Translate-App verwendet wird, ermöglicht diese neue API Entwicklern die Bereitstellung schneller, dynamischer Übersetzungen zwischen 58 Sprachen.

- API zur Objekterkennung und -verfolgung: Mit dieser API kann eine App das auffälligste Objekt, das durch ein Kästchen um es herum markiert ist, in einem Live-Kamera-Feed lokalisieren und verfolgen. Entwickler können dann das auffälligste Objekt identifizieren, indem sie eine Cloud Vision-Such-API abfragen. Beispielsweise soll IKEA mit dieser API für den visuellen Möbeleinkauf experimentieren.

- AutoML Vision Edge: Für Entwickler, die ein benutzerdefiniertes ML-Modell mit minimalem Fachwissen wünschen, können Sie mit AutoML Vision Edge Ihr eigenes benutzerdefiniertes Modell erstellen und trainieren, um es lokal auf dem Gerät eines Benutzers auszuführen. Um ein Modell zu trainieren, reicht es einfach aus lädt seine Datenbank hoch (z.B. eine Reihe von Bildern) an die Firebase-Konsole und klicken Sie auf „Modell trainieren“, um ein TensorFlow Lite-Modell anhand der Datenbank zu trainieren. Google gab bekannt, dass ein Unternehmen namens Fishbrain diese API verwendet hat, um ein Modell zur Identifizierung der Fischrasse zu trainieren, während ein anderes Unternehmen namens Lose It! trainierte ein Modell, um die Lebensmittelkategorien in einem Bild zu identifizieren.

Maschinelles Lernen ist ein schnell wachsendes Feld in der Informatik, daher ist es für Entwickler selbstverständlich, Interesse daran zu zeigen. Allerdings kann es durchaus möglich sein, ML-Modelle effektiv zu erstellen und zu trainieren, ohne dass ein Datenwissenschaftler im Team ist schwierig, weshalb Google den Prozess vereinfacht, indem es das Training von Modellen automatisiert ML-Kit. Entwickler können sich auf die Entwicklung neuer Apps mit leistungsstarken Funktionen konzentrieren und dabei die Leistungsfähigkeit von ML nutzen, ohne viel Zeit und Mühe in das Erlernen der Datenwissenschaft investieren zu müssen. Mit der Hinzufügung dieser drei neuen APIs im ML Kit werden wir hoffentlich viele neue nützliche Apps in Google Play sehen.

Firebase-Leistungsüberwachung für Webentwickler

Verbraucher verlangen von den Apps und Websites, die sie nutzen, eine gute Leistung, aber Firebase hat bisher nur nativen App-Entwicklern die Möglichkeit dazu gegeben die Leistung ihrer Produkte effektiv überwachen. Auf der Google I/O 2019 kündigte Google an, dass Firebase Performance Monitoring für Webentwickler verfügbar gemacht wird Firebase-Hosting. Webentwickler können die Nutzer auf ihren Plattformen binden, indem sie die Geschwindigkeit ihrer Web-Apps verbessern. Um Webentwicklern dabei zu helfen, die wichtigsten Schwachstellen in der Leistung ihrer Websites zu erkennen, stellt Firebase webzentrierte Tools und Telemetriemessungen bereit, um zu zeigen, wie reale Benutzer eine Website erleben. Webentwickler werden beispielsweise in der Lage sein, Aspekte wie die Zeit bis zum ersten Malen und die Eingabeverzögerung, wie schnell Menschen Inhalte auf einer Webseite zum ersten Mal sehen und mit ihnen interagieren, sowie die durchschnittliche Latenz zu überwachen. Das Übersichts-Dashboard zeigt diese und andere Kennzahlen an, um Webentwicklern dabei zu helfen, das Erlebnis für ihre Benutzer zu optimieren, sei es nach Land oder global.

Andere Ankündigungen

Aktualisierter Audience Builder in Google Analytics für Firebase

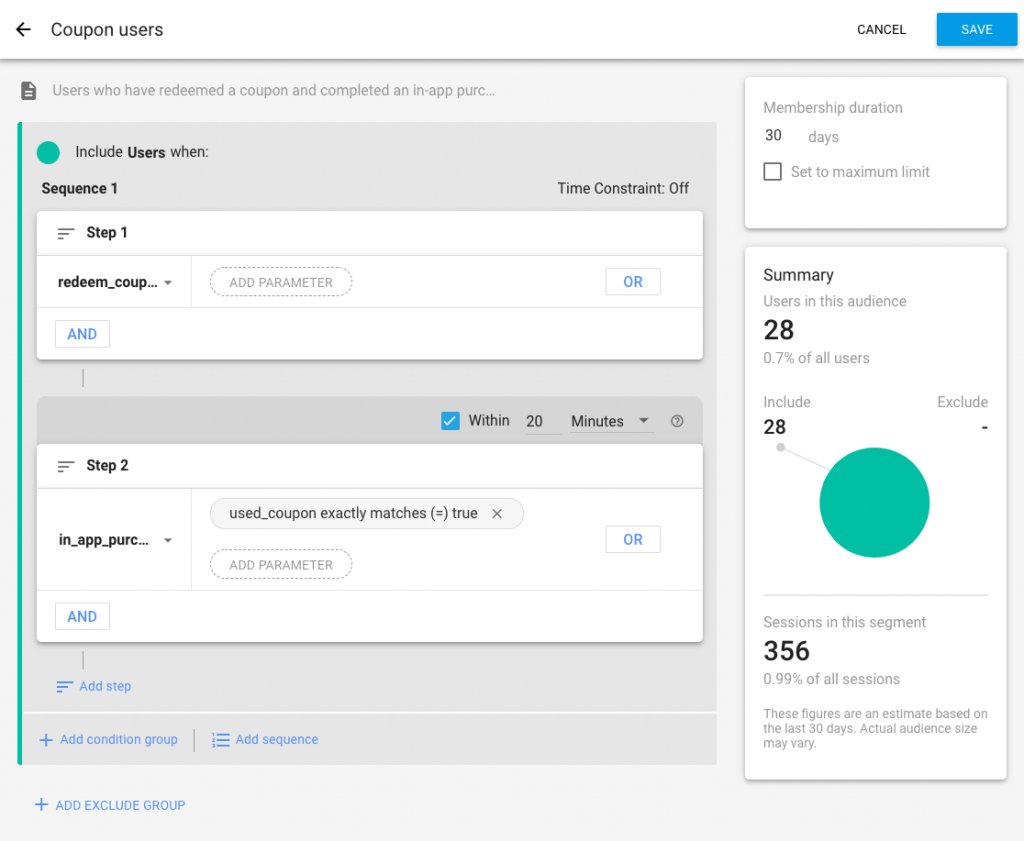

Der Aufbau gezielter Zielgruppen ist für die Maximierung des Benutzerengagements von entscheidender Bedeutung. Sie möchten sicherstellen, dass Sie Ihre Benutzer in die richtigen Kategorien einteilen, damit Sie wissen, wie Sie sie am besten ansprechen Bieten Sie ihnen personalisierte Anreize und Ermutigungen, damit die Wahrscheinlichkeit steigt, dass sie Ihre App weiterhin nutzen Service. Google Analytics für Firebase hilft Entwicklern, ihre Benutzer und ihre Benutzer besser zu verstehen Aktualisierter Audience Builder wird es einfacher machen, neue Zielgruppen für die gezielte Ansprache zu erstellen Remote-Konfiguration oder Wiedereingliederung durch In-App-Nachrichten. Zu den aktualisierten Audience Builder-Funktionen gehören Funktionen wie „Sequenzen, Umfang, Zeitfenster, [und] Mitgliedschaftsdauer“. Als Beispiel, Laut Google ist es jetzt möglich, eine Zielgruppe für Nutzer zu erstellen, die einen Gutscheincode einlösen und innerhalb von 20 Minuten nach dem Gutschein ein Produkt kaufen Rückzahlung.

- Cloud Firestore, eine vollständig verwaltete NoSQL-Datenbank, erhält Unterstützung für Sammlungsgruppenabfragen Dadurch kann Ihre App „nach Feldern in allen Sammlungen mit demselben Namen suchen, unabhängig davon, wo sie sich in der Datenbank befinden“. Sammlungsgruppenabfragen werden, Ermöglichen Sie beispielsweise einer Musik-App mit einer Datenstruktur, die aus Künstlern und ihren Songs besteht, unabhängig von den Künstlern nach Feldern in den Songs abzufragen Künstler.

- Das neue Cloud Functions-Emulator wird es Entwicklern ermöglichen, die lokale App-Entwicklung und das Testen zu beschleunigen; Es kommuniziert mit dem Cloud Firestore-Emulator.

- Wenn Sie Abstürze in Ihrer App beheben müssen, kann Firebase Crashlytics Ihnen bei der Diagnose von Stabilitätsproblemen helfen. Der Geschwindigkeitsalarm informiert Sie, wenn ein bestimmtes Problem plötzlich an Schwere zugenommen hat und es sich lohnt, es genauer zu untersuchen. Der Alarmschwellenwert konnte bisher jedoch nie angepasst werden.

Weitere Neuigkeiten zu Firebase finden Sie im Offizieller Blog oder treten Sie dem bei Alpha Programm, um eine Vorschau auf kommende Funktionen zu erhalten.