Wir haben uns an Sony gewandt, um etwas mehr über den IMX378-Sensor zu erfahren, der in den kommenden Google Pixel- und Pixel XL-Telefonen verwendet wird. Erfahren Sie alles darüber!

IMX378-Übersicht

Wir haben uns an Sony gewandt, um etwas mehr über den IMX378-Sensor zu erfahren, der vom kommenden Google verwendet wird Pixel Und Pixel XL Telefone, sowie durch die Xiaomi Mi 5S. Leider war Sony noch nicht in der Lage, das Datenblatt für den Exmor RS IMX378-Sensor zu verteilen, aber sie waren äußerst hilfreich und konnten uns einige bisher unveröffentlichte Informationen über die liefern IMX378.

Erstens war der Name selbst falsch. Trotz Gerüchten, dass es Teil davon sein würde Exmor R Reihe von Backside Illuminated (BSI) CMOS-Sensoren wie der IMX377 davor, der in der verwendet wurde Nexus 5X Und Nexus 6PUnser Ansprechpartner bei Sony hat uns mitgeteilt, dass der IMX378 stattdessen als Teil von Sony betrachtet wird Exmor RS Reihe von gestapelten BSI-CMOS-Sensoren.

Während viele Dinge vom IMX377 zum IMX378 gleich geblieben sind, einschließlich der Pixelgröße (1,55 μm) und der Sensorgröße (7,81 mm), wurden einige wichtige Funktionen hinzugefügt. Es handelt sich nämlich jetzt um ein gestapeltes BSI-CMOS-Design, es verfügt über PDAF, es fügt die SME-HDR-Technologie von Sony hinzu und es bietet eine bessere Unterstützung für Videos mit hoher Bildrate (Zeitlupe).

Gestapelter BSI-CMOS

Die Beleuchtung der Rückseite selbst ist eine äußerst nützliche Funktion, die in den letzten Jahren bei Flaggschiff-Smartphones fast zum Standard geworden ist, angefangen beim HTC Evo 4G in 2010. Dadurch kann die Kamera wesentlich mehr Licht einfangen (auf Kosten von mehr Rauschen), indem sie einen Teil davon bewegt Die Struktur, die traditionell vor der Fotodiode bei vorne beleuchteten Sensoren saß, dahinter Es.

Überraschenderweise tauchte die Rückseitenbeleuchtung im Gegensatz zu den meisten Kameratechnologien erstmals in Telefonen vor DSLRs auf, was zum großen Teil auf die Schwierigkeiten bei der Entwicklung größerer BSI-Sensoren zurückzuführen ist. Der erste APS-C-Sensor von BSI war der Samsung S5KVB2, der in der NX1-Kamera von 2014 zu finden war Der erste Vollformatsensor war der Sony Exmor R IMX251, der zuletzt in der Sony α7R II zu finden war Jahr.

Die gestapelte BSI-CMOS-Technologie geht noch einen Schritt weiter, indem sie einen größeren Teil der Schaltkreise von der vorderen Schicht auf das Trägersubstrat hinter den Fotodioden verlagert. Dadurch kann Sony nicht nur die Größe des Bildsensors erheblich reduzieren (was größere Sensoren bei gleicher Stellfläche ermöglicht), sondern Sony kann auch die Pixel und Schaltkreise drucken getrennt (auch bei unterschiedlichen Herstellungsprozessen), wodurch das Fehlerrisiko verringert, die Ausbeute verbessert und eine stärkere Spezialisierung zwischen den Fotodioden und dem Träger ermöglicht wird Schaltung.

PDAF

Der IMX378 verfügt über einen Phasenerkennungs-Autofokus, den die Nexus-Telefone des letzten Jahres und der IMX377 nicht unterstützten. Dadurch kann die Kamera die Unterschiede in der Lichtintensität zwischen verschiedenen Punkten auf dem Sensor effektiv nutzen, um sie zu identifizieren Wenn sich das Objekt, auf das die Kamera fokussieren möchte, vor oder hinter dem Fokuspunkt befindet, passen Sie den Sensor an entsprechend. Dies ist sowohl hinsichtlich der Geschwindigkeit als auch der Genauigkeit eine enorme Verbesserung gegenüber dem herkömmlichen kontrastbasierten Autofokus, den wir in der Vergangenheit bei vielen Kameras gesehen haben. Infolgedessen haben wir eine regelrechte Explosion bei Mobiltelefonen erlebt, die PDAF verwenden, und es ist zu einem riesigen Marketing-Schlagwort geworden, das in der gesamten Branche als Kernstück des Kameramarketings gilt.

Der IMX378 verfügt über einen Phasenerkennungs-Autofokus, den die Nexus-Telefone des letzten Jahres und der IMX377 nicht unterstützten. Dadurch kann die Kamera die Unterschiede in der Lichtintensität zwischen verschiedenen Punkten auf dem Sensor effektiv nutzen, um sie zu identifizieren Wenn sich das Objekt, auf das die Kamera fokussieren möchte, vor oder hinter dem Fokuspunkt befindet, passen Sie den Sensor an entsprechend. Dies ist sowohl hinsichtlich der Geschwindigkeit als auch der Genauigkeit eine enorme Verbesserung gegenüber dem herkömmlichen kontrastbasierten Autofokus, den wir in der Vergangenheit bei vielen Kameras gesehen haben. Infolgedessen haben wir eine regelrechte Explosion bei Mobiltelefonen erlebt, die PDAF verwenden, und es ist zu einem riesigen Marketing-Schlagwort geworden, das in der gesamten Branche als Kernstück des Kameramarketings gilt.

Obwohl es nicht ganz so schnell zu fokussieren ist wie der Dual Photodiode PDAF Samsung Galaxy S7 hat (auch bekannt als „Dual Pixel PDAF“ Und „Duo-Pixel-Autofokus“), die es ermöglicht, jedes einzelne Pixel für die Phasendetektion zu nutzen, indem zwei Fotodioden pro Pixel integriert werden, sollte die Kombination von PDAF und Laser-Autofokus immer noch eine wirksame Kombination sein.

Hohe Bildrate

In letzter Zeit wurde viel über Kameras mit hoher Bildrate gesprochen (sowohl für Verbraucheranwendungen als auch im professionellen Filmbereich). Die Möglichkeit, mit höheren Bildraten aufzunehmen, kann dazu genutzt werden, unglaublich flüssige Videos zu erstellen Normale Geschwindigkeit (die für Sport- und andere Hochgeschwindigkeitsszenarien fantastisch sein kann) und einige zu schaffen Wirklich interessante Videos wenn du alles verlangsamst.

Leider ist es äußerst schwierig, Videos mit höheren Bildraten aufzunehmen, selbst wenn Ihre Kamera vorhanden ist Obwohl der Sensor mit höheren Bildraten aufnehmen kann, kann es für den Bildsignalprozessor des Telefons schwierig sein, diese einzuhalten hoch. Deshalb konnten wir mit dem im Nexus 5X und 6P verwendeten IMX377 zwar 720p-Videos mit 300 Hz und 1080p-Videos mit 120 Hz aufnehmen, während wir beim Nexus 5X nur 120 Hz 720p und beim 6P nur 240 Hz 720p sahen. Der IMX377 war auch in der Lage, 4K-Videos mit 60 Hz zu übertragen, obwohl die Nexus-Geräte auf 30 Hz begrenzt waren.

Die Pixel-Telefone sind beide in der Lage, 1080p-Videos mit bis zu 120 Hz und 720p-Videos mit 240 Hz zu übertragen Teilweise auf Verbesserungen im Zusammenhang mit dem IMX378, der eine Leistungssteigerung auf bis zu 240 Hz vorsieht 1080p.

Der Sensor ist auch in der Lage, Serienbilder in voller Auflösung schneller aufzunehmen, und zwar mit einer Geschwindigkeit von bis zu 60 Hz bei 10-Bit-Ausgabe und 40 Hz bei 12-Bit-Ausgabe Ausgabe (von 40 Hz bzw. 35 Hz), was dazu beitragen sollte, Bewegungsunschärfe und Kameraverwacklungen bei der Verwendung zu reduzieren HDR+.

KMU-HDR

Traditionell war HDR für Videos ein Kompromiss. Entweder musste man die Bildrate halbieren, oder man musste die Auflösung halbieren. Daher haben sich viele OEMs noch nicht einmal damit beschäftigt, wobei Samsung und Sony zu den wenigen gehören, die es implementieren. Sogar die Samsung Galaxy Note 7 ist auf 1080p-30-Hz-Aufnahmen beschränkt, was zum Teil auf den hohen Rechenaufwand von HDR-Videos zurückzuführen ist.

Die erste der beiden wichtigsten traditionellen Methoden für HDR-Videos, die Red Digital Cinema Camera Company nennt HDRx und was Sony Digital Overlap HDR nennt (DOL-HDR)Dabei werden zwei aufeinanderfolgende Bilder aufgenommen, eines dunkler und eines heller belichtet, und zu einem einzigen Videobild zusammengefügt. Dadurch können Sie jedoch die volle Auflösung der Kamera beibehalten (und für beide unterschiedliche Verschlusszeiten einstellen). Frames), kann es aufgrund der Zeitlücke zwischen den beiden Frames häufig zu Problemen kommen (insbesondere bei schnellen Bewegungen). Objekte). Darüber hinaus kann es für den Prozessor sehr schwierig sein, mitzuhalten, da bei DOL-HDR der ISP des Telefons die Zusammenführung der einzelnen Frames übernimmt.

Die andere traditionelle Methode, die Sony Binning Multiplexed Exposure HDR (BME-HDR) nennt, legt eine andere Belichtungseinstellung fest jedes Paar aus zwei Pixelzeilen im Sensor, um gleichzeitig zwei Bilder mit halber Auflösung zu erstellen, die dann zu einem HDR-Frame für das Video zusammengefügt werden. Diese Methode vermeidet zwar die mit HDRx verbundenen Probleme, nämlich eine Reduzierung der Bildrate, hat aber auch andere Probleme: insbesondere die Reduzierung der Auflösung und die Grenzen, wie die Belichtung zwischen den beiden Sätzen geändert werden kann Linien.

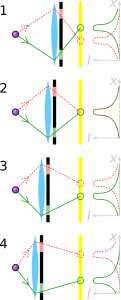

Spatially Multiplexed Exposure (SME-HDR) ist eine neue Methode, die Sony verwendet, um HDR-Aufnahmen mit der vollen Auflösung und der vollen Bildrate zu ermöglichen, die der Sensor leisten kann. Es ist eine Variante von Räumlich variierende Belichtung das proprietäre Algorithmen verwendet, die es Sony ermöglichen, die Informationen aus den dunklen und hellen Pixeln zu erfassen in einem Schachbrettmuster angeordnet und das Bild mit voller Auflösung sowohl für die dunkle als auch für die helle Belichtung abgeleitet Bilder.

Leider war Sony nicht in der Lage, uns detailliertere Erklärungen zum genauen Muster zu geben, und sie werden es möglicherweise nie offenlegen können – Unternehmen neigen dazu, ihre Karten auszuspielen Sie liegen ihnen sehr nahe, wenn es um modernste Technologie geht, wie wir sie in HDR sehen, und sogar Google verfügt über einen eigenen proprietären Algorithmus für HDR-Fotos namens HDR+. Es gibt jedoch immer noch einige öffentlich zugängliche Informationen, anhand derer wir herausfinden können, wie dies erreicht werden kann. Einige Artikel wurden von Shree K. veröffentlicht. Nayar von der Columbia University (einer davon entstand in Zusammenarbeit mit Tomoo Mitsunaga von Sony), die verschiedene Möglichkeiten zur Verwendung räumlich variierender Belichtung und verschiedene Layouts enthalten, mit denen dies erreicht werden kann. Unten sehen Sie ein Beispiel für ein Layout mit vier Belichtungsstufen auf einem RGBG-Bildsensor. Dieses Layout soll in der Lage sein, HDR-Bilder in voller Auflösung mit nur einer Aufnahme von nur etwa 20 % zu erzielen. Verlust der räumlichen Auflösung, je nach Szenario (die gleiche Leistung, die Sony behauptet). KMU-HDR).

Sony hat SME-HDR bereits in einigen Bildsensoren verwendet, darunter im IMX214, der sich in letzter Zeit großer Beliebtheit erfreut (verwendet im Asus Zenfone 3 Laser, der Moto Z, und das Xperia X-Leistung), ist aber eine neue Ergänzung des IMX378 im Vergleich zum IMX377, der letztes Jahr verwendet wurde. Dadurch kann der Kamerasensor sowohl 10-Bit-Vollauflösung als auch 4K-Video mit 60 Hz bei aktivem SME-HDR ausgeben. Während ein Engpass an anderer Stelle im Prozess zu einem niedrigeren Grenzwert führen wird, ist dies eine fantastische Verbesserung gegenüber dem, wozu der IMX377 in der Lage war, und ein Zeichen dafür, dass in der Zukunft gute Dinge auf uns zukommen werden.

Eine der großen Verbesserungen des IMX378 gegenüber dem IMX377 besteht darin, dass er in der Lage ist, einen größeren Teil der Bildverarbeitung auf dem Chip zu verarbeiten, was zu einer Reduzierung der Bildverarbeitung führt die Arbeitsbelastung des ISP (obwohl der ISP immer noch in der Lage ist, die RAW-Bilddaten anzufordern, je nachdem, wie der OEM sich für die Verwendung entscheidet). Sensor). Es kann viele kleine Dinge wie Fehlerkorrektur und lokale Spiegelung erledigen, aber was noch wichtiger ist, es kann auch BME-HDR oder SME-HDR verarbeiten, ohne dass der ISP eingebunden werden muss. Dies könnte in Zukunft möglicherweise einen großen Unterschied bedeuten, da der ISP bei künftigen Telefonen einen Teil des Overheads einsparen könnte.

Wir möchten Sony noch einmal für die Hilfe bei der Erstellung dieses Artikels danken. Wir schätzen die Anstrengungen, die Sony unternommen hat, um die Genauigkeit und Tiefe dieses Dokuments zu gewährleisten, sehr zu schätzen Funktion, insbesondere um es uns zu ermöglichen, einige bisher unveröffentlichte Informationen über das aufzudecken IMX378.

Dennoch ist es wirklich schade, dass es so schwierig ist, auf einige dieser Informationen zuzugreifen, selbst auf grundlegende Produktinformationen. Wenn Unternehmen versuchen, Informationen auf ihren Websites bereitzustellen, sind diese im Großen und Ganzen oft eher unzugänglich und unvollständig Dies liegt zum Teil daran, dass es von den Mitarbeitern des Unternehmens oft als zweitrangiges Anliegen behandelt wird, da sie sich mehr auf ihr Hauptanliegen konzentrieren arbeiten. Eine engagierte Person, die sich um die Öffentlichkeitsarbeit kümmert, kann bei der Bereitstellung dieser Art von Informationen einen großen Unterschied machen verfügbar und für die breite Öffentlichkeit zugänglich, und wir sehen, dass einige Leute versuchen, genau das kostenlos zu tun Zeit. Sogar auf der Sony Exmor Wikipedia-Artikel selbst, in dem eine einzelne Person in ihrer Freizeit im Laufe einiger Monate den größten Teil des Grundsteins legte, um ihn aus einem nahezu nutzlosen Zustand zu entfernen 1.715 Byte großer Artikel Das war jahrelang weitgehend das Gleiche, bis hin zu dem ca. 50.000 Byte großen Artikel, den wir heute dort mit 185 verschiedenen Herausgebern sehen. Ein Artikel, der wohl die beste Informationsquelle über die Sony Exmor-Sensorreihe ist, die online verfügbar ist, und wir können ein sehr ähnliches Muster in anderen Artikeln erkennen. Ein einziger engagierter Autor kann einen erheblichen Unterschied darin machen, wie einfach Kunden verschiedene vergleichen können Produkte und darüber, wie gut interessierte Verbraucher über das Thema informiert sind, was weitreichende Auswirkungen haben kann Auswirkungen. Aber das ist ein Thema für ein anderes Mal.

Wie immer fragen wir uns, wie sich diese Hardwareänderungen auf die Geräte selbst auswirken werden. Wir werden ganz klar kein 4K-60-Hz-HDR-Video bekommen (und möglicherweise überhaupt kein HDR-Video, da Google es noch nicht erwähnt hat), sondern die schnellere volle Auflösung Das Fotografieren wird mit HDR+ wahrscheinlich erheblich helfen, und wir werden sehen, wie die Verbesserungen des neueren Sensors auf andere, ähnlich kleine, aber wesentliche Weise in das Telefon einfließen sowie.

Während DXOMark listet das Pixel auf Obwohl die Leistung der Pixel-Telefone etwas besser war als das Samsung Galaxy S7 und das HTC 10, waren viele der Dinge, die den Pixel-Telefonen diesen kleinen Vorsprung verschafften, große Software Verbesserungen wie HDR+ (das absolut fantastische Ergebnisse liefert und dem DXOMark einen ganzen Abschnitt seines Tests gewidmet hat) und Googles spezielles EIS System (das mit OIS zusammenarbeiten kann), das das Gyroskop 200 Mal pro Sekunde abtastet, um eine der besten elektronischen Bildstabilisierungen zu bieten, die wir je hatten gesehen. Ja, die Pixel-Telefone haben eine tolle Kamera, aber hätten sie mit OIS und Dual Pixel PDAF noch besser sein können? Absolut.

Verstehen Sie mich nicht falsch, wie gesagt, die Pixel-Telefone haben eine absolut atemberaubende Kamera, aber Sie können es mir nicht wirklich verübeln, dass ich vor allem mehr wollte wenn der Weg zu diesen Verbesserungen so klar ist (und wenn die Telefone zum vollen Preis des Flaggschiffs angeboten werden, bei dem man das Beste davon erwartet am besten). Es wird immer einen Teil von mir geben, der mehr will, der sich eine bessere Akkulaufzeit, schnellere Prozessoren, eine bessere Akkulaufzeit und mehr Helligkeit wünscht und lebendigere Bildschirme, lautere Lautsprecher, bessere Kameras, mehr Speicher, eine bessere Akkulaufzeit und vor allem eine bessere Akkulaufzeit (wieder). Abgesehen davon verfügen die Pixel-Telefone über viele kleine fantastische Funktionen, die zusammen ein wirklich vielversprechendes Gerät ergeben könnten, worüber ich gespannt bin.