Gestern hat Google auf der Google I/O Conference einige sehr interessante neue Features vorgestellt. Das Unternehmen hat jetzt seine Sprachassistentenfunktion auf dem iPhone eingeführt und ist dabei, eigenständige Virtual-Reality-Headsets auf den Markt zu bringen. Die für uns auffällige Ankündigung war die Einführung der neuartigen Google Lens-Funktion.

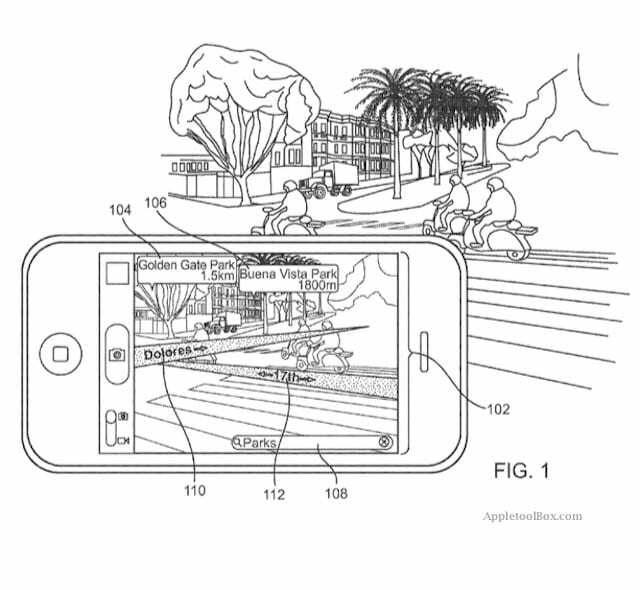

Diese neue Funktion demonstriert die Integration der Kameraleistung des Smartphones mit Bilderkennung und Anzeige kontextbezogener Informationen.

Die Google Objektiv-App verwendet die Bilderkennung, um Objekte, die in Ihrem Kameraobjektiv erscheinen, in Echtzeit zu identifizieren. Die App analysiert Ihre Umgebung und zeigt relevante Informationen auf Ihrem Bildschirm an.

Sie sehen die Bewertung, Speisekarten oder Sofortbewertungen eines Restaurants, wenn Sie Ihr Telefon auf die Schaufensterfront richten. Sie können es auf ein. richten Blume und es wird die Art identifizieren, und Sie können sogar die Musik oder Videos einer Band abrufen, indem Sie Lens auf ein Konzert richten Poster.

Angesichts der neuen Rechenleistung der Smartphones der nächsten Generation zusammen mit einem leistungsstarken Kameraobjektiv könnte dies eine ganz neue Welt der Mensch-Computer-Interaktion und machen Sie Augmented Reality zum Mittelpunkt unseres Smartphones Erfahrung.

Während Apple die Einführung von iPhone 8 und iOS 11 vorbereitet, fragen wir uns, ob es genügend Zeit hatte, eine seiner wichtigsten Akquisitionen aus vergangenen Jahren zu integrieren, um ähnliche Erfahrungen auf dem iPhone zu bieten.

Apple hat Metaio im Mai 2015 übernommen. Ähnlich wie bei den anderen kleinen Übernahmen von Apple gab es keine Fanfare, da metaio in den Betrieb von Apple aufgenommen wurde. metaio war ein Startup mit Geschichte. Es wurde 2003 als Ableger eines Volksvagen-Projekts ins Leben gerufen. Zum Zeitpunkt der Übernahme hatte metaio knapp 1000 Kunden und 150.000 Nutzer. Die meisten Angebote konzentrierten sich auf B2B-Anwendungsfälle.

Das Unternehmen war einer der ersten kleinen, aber erfolgreichen Player in der Welt der Augmented Reality.

Die Funktionsweise der Plattform war der von Google Lens sehr ähnlich. Richten Sie Ihre iOS-Kamera auf eine physische Einheit und das System würde zusätzliche kontextsensitive Informationen zu dem in Echtzeit im Objektiv erfassten Objekt schichten.

Ein klassischer Anwendungsfall seiner Plattform ist in diesem Video zu sehen, bei dem Benutzer ihr iPad beim Besuch der Gedenkstätte Berliner Mauer zeigen und die App historisches Filmmaterial auf den Bildschirm bereichern würde.

Das Unternehmen stellte auch eine Demo zur Verfügung, die einige der Anwendungsfälle in Anlehnung an das, was Sie in der Google-Linse sehen, vorstellte. Richten Sie Ihre Kamera beispielsweise auf ein Einzelhandelsgeschäft und es zeigt Ihnen die verschiedenen laufenden Werbeaktionen und Rabatte, die das Geschäft anbietet.

metaio stellte eine einfache und nahtlose Plattform bereit, mit der Benutzer innerhalb von Minuten Augmented-Reality-Anwendungen erstellen konnten. Mit dem metaio Creator können Sie Apps sowohl auf macOS als auch auf iOS entwickeln und bereitstellen. Das Unternehmen bot auch ein Cloud-basiertes System namens Metaio CVS an, das einen Cloud-basierten Bildabgleich ermöglichte.

Die Übernahme von metaio durch Apple im Jahr 2015 war definitiv ein sehr strategischer Schachzug. Wenn man das, was dieses kleine Unternehmen geleistet hat, mit der umfangreichen Forschung und Entwicklung kombiniert, die Apple intern betreibt, ist es schwer, nicht aufgeregt über die potenziellen Angebote nachzudenken.

Apple beschäftigt sich schon seit geraumer Zeit mit Computer Vision, Pattern Matching und Machine Learning. Peter Meier, Mitbegründer von metaio, arbeitet noch immer für Apple in der Engineering-Abteilung zusammen mit Thomas Alt, dem anderen Mitbegründer, der derzeit Mitglied des strategischen Deals-Teams bei Apple ist.

Letztes Jahr, als iOS 10 auf der WWDC vorgestellt wurde, hofften wir, einige der Mixed-Reality-Funktionen zu sehen. Nun, es ist nicht ganz passiert. Ein Großteil der WWDC des letzten Jahres konzentrierte sich auf die überarbeiteten iMessage-Funktionen zusammen mit der neu gestalteten Benutzeroberfläche von iOS

Wir hoffen, dass die diesjährige WWDC insbesondere in diesem aufstrebenden Bereich der Bilderkennung mehr zu bieten hat. Es kann kein Wunschdenken sein, da Apple bereits über Akquisitionen und interne Forschung an dieser Technologie gearbeitet hat.

Jetzt, da das Google Lens vorgestellt wurde, ist es höchste Zeit für Apple, seine beste Show beim WWDC-Fun-Fest im Juni zu präsentieren.

Wir werden warten!

Sudz (SK) ist seit der frühen Einführung von A/UX bei Apple von Technik besessen und für die redaktionelle Leitung von AppleToolBox verantwortlich. Er hat seinen Sitz in Los Angeles, Kalifornien.

Sudz ist darauf spezialisiert, alles rund um macOS abzudecken und hat im Laufe der Jahre Dutzende von OS X- und macOS-Entwicklungen überprüft.

In einem früheren Leben half Sudz Fortune-100-Unternehmen bei ihren Bestrebungen zur Technologie- und Geschäftstransformation.