Nos comunicamos con Sony para intentar aprender un poco más sobre el sensor IMX378 que utilizan los próximos teléfonos Google Pixel y Pixel XL. ¡Aprende todo al respecto!

Descripción general de IMX378

Nos comunicamos con Sony para intentar aprender un poco más sobre el sensor IMX378 que utiliza el próximo Google. Píxel y Píxel XL teléfonos, así como por el Xiaomi Mi 5S. Desafortunadamente, Sony aún no ha podido distribuir la hoja de datos del sensor Exmor RS IMX378, pero fueron extremadamente útiles y pudieron brindarnos información inédita sobre el IMX378.

En primer lugar, el propio nombre estaba equivocado. A pesar de los rumores que afirmaban que sería parte del exmor r línea de sensores CMOS con iluminación trasera (BSI) como el IMX377 anterior que se usó en el Nexo 5X y Nexo 6P, nuestro contacto en Sony nos ha informado que el IMX378 se considerará parte del catálogo de Sony. Exmor RS Línea de sensores BSI CMOS apilados.

Si bien muchas cosas han permanecido iguales desde el IMX377 al IMX378, incluido el tamaño del píxel (1,55 μm) y el tamaño del sensor (7,81 mm), se han agregado un par de características clave. Es decir, ahora es un diseño BSI CMOS apilado, tiene PDAF, agrega la tecnología SME-HDR de Sony y tiene mejor soporte para video de alta velocidad de fotogramas (cámara lenta).

CMOS BSI apilados

La iluminación trasera por sí sola es una característica extremadamente útil que se ha convertido casi en un estándar en los teléfonos inteligentes emblemáticos de los últimos años, comenzando con el HTC Evo 4G en 2010. Permite a la cámara capturar sustancialmente más luz (a costa de más ruido) moviendo algunos de la estructura que tradicionalmente se encontraba frente al fotodiodo en los sensores iluminados frontales, detrás él.

Sorprendentemente, a diferencia de la mayoría de la tecnología de cámaras, la iluminación trasera comenzó a aparecer originalmente en los teléfonos antes que las DSLR, en gran parte debido a las dificultades para crear sensores BSI más grandes. El primer sensor BSI APS-C fue el Samsung S5KVB2 que se encontró en su cámara NX1 de 2014, y El primer sensor de fotograma completo fue el Sony Exmor R IMX251 que se encontró en la Sony α7R II del año pasado. año.

La tecnología BSI CMOS apilada lleva esto un paso más allá al mover más circuitos desde la capa frontal al sustrato de soporte detrás de los fotodiodos. Esto no sólo permite a Sony reducir sustancialmente el tamaño del sensor de imagen (lo que permite sensores más grandes en el mismo espacio), sino que también le permite a Sony imprimir los píxeles y los circuitos. por separado (incluso en diferentes procesos de fabricación), reduciendo el riesgo de defectos, mejorando los rendimientos y permitiendo una mayor especialización entre los fotodiodos y el soporte. circuitos.

PDAF

El IMX378 agrega enfoque automático por detección de fase, que los teléfonos Nexus del año pasado y el IMX377 no admitían.. Permite que la cámara utilice eficazmente las diferencias en la intensidad de la luz entre diferentes puntos del sensor para identificar si el objeto que la cámara intenta enfocar está delante o detrás del punto de enfoque, y ajuste el sensor respectivamente. Esta es una gran mejora tanto en términos de velocidad como de precisión con respecto al enfoque automático tradicional basado en contraste que hemos visto en muchas cámaras en el pasado. Como resultado, hemos visto una explosión absoluta de teléfonos que utilizan PDAF, y se ha convertido en una enorme palabra de moda en marketing que se considera una pieza central del marketing de cámaras en toda la industria.

El IMX378 agrega enfoque automático por detección de fase, que los teléfonos Nexus del año pasado y el IMX377 no admitían.. Permite que la cámara utilice eficazmente las diferencias en la intensidad de la luz entre diferentes puntos del sensor para identificar si el objeto que la cámara intenta enfocar está delante o detrás del punto de enfoque, y ajuste el sensor respectivamente. Esta es una gran mejora tanto en términos de velocidad como de precisión con respecto al enfoque automático tradicional basado en contraste que hemos visto en muchas cámaras en el pasado. Como resultado, hemos visto una explosión absoluta de teléfonos que utilizan PDAF, y se ha convertido en una enorme palabra de moda en marketing que se considera una pieza central del marketing de cámaras en toda la industria.

Si bien no es tan rápido de enfocar como el PDAF de fotodiodo dual que el samsung galaxy s7 tiene (también conocido como “PDAF de doble píxel” y “Enfoque automático de doble píxel”), que permite utilizar cada píxel para la detección de fase al incluir dos fotodiodos por píxel, la fusión de PDAF y el enfoque automático láser debería seguir siendo una combinación potente.

Cuadros por segundo elevado

Últimamente se ha hablado mucho sobre las cámaras de alta velocidad de fotogramas (tanto para aplicaciones de consumo como para cine profesional). La capacidad de grabar a velocidades de fotogramas más altas se puede utilizar tanto para crear vídeos increíblemente fluidos a velocidad regular (que puede ser fantástica para deportes y otros escenarios de alta velocidad) y para crear algunos en realidad vídeos interesantes cuando ralentizas todo.

Desafortunadamente, es extremadamente difícil grabar videos a velocidades de fotogramas más altas, e incluso cuando la cámara El sensor puede disparar a velocidades de cuadros más altas, puede resultar difícil para el procesador de señal de imagen del teléfono mantener arriba. Es por eso que, mientras que el IMX377 usado en el Nexus 5X y 6P podía grabar videos de 720p a 300 Hz y videos de 1080p a 120 Hz, solo vimos 120 Hz 720p del Nexus 5X y 240 Hz 720p del 6P. El IMX377 también era capaz de reproducir vídeo 4k a 60 Hz, a pesar de que los dispositivos Nexus estaban limitados a 30 Hz.

Los teléfonos Pixel pueden ofrecer esto hasta video de 120 Hz 1080p y video de 240 Hz 720p gracias a parte de las mejoras relacionadas con el IMX378, que ve un aumento en las capacidades de hasta 240 Hz en 1080p.

El sensor también es capaz de realizar tomas en ráfaga de resolución completa más rápido, aumentando hasta 60 Hz con salida de 10 bits y 40 Hz con 12 bits. salida (en comparación con 40 Hz y 35 Hz respectivamente), lo que debería ayudar a reducir la cantidad de desenfoque de movimiento y vibración de la cámara cuando se usa HDR+.

PYME-HDR

Tradicionalmente, el HDR para vídeo ha sido una compensación. O tenías que reducir la velocidad de fotogramas a la mitad o tenías que reducir la resolución a la mitad. Como resultado, muchos fabricantes de equipos originales ni siquiera se han molestado en implementarlo, y Samsung y Sony se encuentran entre los pocos que lo implementan. Incluso el Samsung Galaxy Nota 7 está limitado a grabación de 1080p 30 Hz debido en parte al alto costo computacional del video HDR.

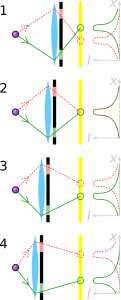

El primero de los dos principales métodos tradicionales para vídeo HDR, que Red Digital Cinema Camera Company llama HDRx y que Sony llama Digital Overlap HDR (DOL-HDR), funciona tomando dos imágenes consecutivas, una expuesta más oscura y otra expuesta más clara, y fusionándolas para crear un solo cuadro de video. Si bien esto le permite mantener la resolución completa de la cámara (y establecer diferentes velocidades de obturación para las dos cámaras separadas), fotogramas), a menudo puede dar lugar a problemas debido al intervalo de tiempo entre los dos fotogramas (especialmente con movimientos rápidos). objetos). Además, puede resultar muy difícil para el procesador mantener el ritmo, ya que con DOL-HDR, el ISP del teléfono se encarga de fusionar los marcos separados.

El otro método tradicional, que Sony llama Binning Multiplexed Exposure HDR (BME-HDR), establece una configuración de exposición diferente para cada par de dos líneas de píxeles en el sensor para crear dos imágenes de media resolución al mismo tiempo, que luego se fusionan en un cuadro HDR para el vídeo. Si bien este método evita los problemas asociados con HDRx, es decir, una reducción en la velocidad de fotogramas, tiene otros problemas, específicamente la reducción de la resolución y los límites sobre cómo se puede cambiar la exposición entre los dos conjuntos de líneas.

La exposición espacialmente multiplexada (SME-HDR) es un nuevo método que Sony está utilizando para permitirles grabar HDR con la resolución completa y la velocidad de fotogramas completa que el sensor es capaz de ofrecer. Es una variante de Exposición espacialmente variable que utiliza algoritmos patentados para permitir a Sony capturar la información de los píxeles oscuros y claros, que son dispuestos en un patrón de estilo tablero de ajedrez e inferir la imagen de resolución completa tanto para la exposición oscura como para la clara. imágenes.

Desafortunadamente, Sony no pudo darnos explicaciones más detalladas sobre el patrón exacto y es posible que nunca puedan revelarlo: las empresas tienden a jugar sus cartas. muy cerca de su pecho cuando se trata de tecnología de punta, como la que vemos en HDR, e incluso Google tiene su propio algoritmo patentado para fotos HDR conocido como HDR+. Sin embargo, todavía hay información disponible públicamente que podemos utilizar para reconstruir cómo se puede lograr. Shree K. ha publicado un par de artículos. Nayar de la Universidad de Columbia (uno de los cuales fue en colaboración con Tomoo Mitsunaga de Sony) que contiene diferentes formas de utilizar la exposición espacialmente variable y diferentes diseños que pueden lograrlo. A continuación se muestra un ejemplo de un diseño con cuatro niveles de exposición en un sensor de imagen RGBG. Este diseño afirma ser capaz de lograr imágenes HDR de resolución completa en una sola captura con solo alrededor del 20%. pérdida de resolución espacial, dependiendo del escenario (el mismo logro que Sony afirma para PYME-HDR).

Sony ya ha utilizado SME-HDR en un par de sensores de imagen, incluido el IMX214, que ha ganado mucha popularidad últimamente (se utiliza en el Asus Zenfone 3 Láser, el Moto Z, y el Rendimiento del Xperia X), pero es una nueva incorporación al IMX378 en comparación con el IMX377 que se usó el año pasado. Permite que el sensor de la cámara genere vídeo de resolución completa de 10 bits y vídeo 4k a 60 Hz con SME-HDR activo. Si bien un cuello de botella en otra parte del proceso dará como resultado un límite más bajo, esta es una mejora fantástica con respecto a lo que el IMX377 era capaz de hacer y es una señal de que vendrán cosas buenas en el futuro.

Una de las grandes mejoras del IMX378 sobre el IMX377 es que es capaz de manejar más procesamiento de imágenes en el chip, reduciendo la carga de trabajo del ISP (aunque el ISP aún puede solicitar los datos de la imagen RAW, dependiendo de cómo el OEM decida utilizar el sensor). Puede manejar muchas cosas pequeñas como la corrección de defectos y la duplicación local, pero lo más importante es que también puede manejar BME-HDR o SME-HDR sin tener que involucrar al ISP. Esto podría suponer una diferencia importante en el futuro al liberar algunos gastos generales para el ISP en teléfonos futuros.

Nos gustaría agradecer a Sony una vez más por toda la ayuda para crear este artículo. Realmente apreciamos todo lo que hizo Sony para ayudar a garantizar la precisión y profundidad de este característica, especialmente al permitirnos descubrir información inédita sobre el IMX378.

Dicho esto, es realmente una pena que sea tan difícil acceder a parte de esta información, incluso a la información básica del producto. Cuando las empresas intentan incluir información en sus sitios web, a menudo ésta puede resultar bastante inaccesible e incompleta, en gran medida en parte porque a menudo se trata como una preocupación secundaria de los empleados de la empresa, que están más centrados en sus asuntos principales. trabajar. Una persona dedicada a manejar las relaciones públicas puede marcar una gran diferencia en términos de hacer que este tipo de información disponible y accesible para el público en general, y estamos viendo que algunas personas intentan hacer precisamente eso en su forma gratuita. tiempo. Incluso en el Sony Exmor Artículo de Wikipedia en sí, donde en el transcurso de un par de meses una sola persona en su tiempo libre sentó la mayor parte de las bases para sacarlo de una situación casi inútil. Artículo de 1.715 bytes eso había sido prácticamente igual durante años, en el artículo de ~ 50.000 bytes que vemos hoy allí con 185 editores distintos. Un artículo que es posiblemente el mejor depósito de información sobre la línea de sensores Sony Exmor disponible en línea, y podemos ver un patrón muy similar en otros artículos. Un único escritor dedicado puede marcar una diferencia sustancial en la facilidad con la que los clientes pueden comparar diferentes productos y en qué tan educados están los consumidores interesados sobre el tema, lo que puede tener efectos de gran alcance. efectos. Pero ese es un tema para otro momento.

Como siempre, nos preguntamos cómo afectarán estos cambios de hardware a los propios dispositivos. Claramente no obtendremos video HDR de 4k a 60 Hz (y es posible que no obtengamos video HDR en absoluto, ya que Google no lo ha mencionado aún), pero sí la resolución completa más rápida. Es probable que disparar ayude sustancialmente con HDR+, y veremos las mejoras del sensor más nuevo llegar al teléfono de otras formas similares, pequeñas pero sustanciales. también.

Mientras que DXOMark enumera el píxel Aunque los teléfonos móviles tuvieron un rendimiento ligeramente mejor que el Samsung Galaxy S7 y el HTC 10, muchas de las cosas que dieron a los teléfonos Pixel esa pequeña ventaja fueron software importante. mejoras como HDR+ (que produce resultados absolutamente fantásticos y al que DXOMark dedicó una sección completa de su revisión) y el EIS especial de Google sistema (que puede funcionar en conjunto con OIS) que muestrea el giroscopio 200 veces por segundo para proporcionar la mejor estabilización de imagen electrónica que jamás hayamos tenido. visto. Sí, los teléfonos Pixel tienen una gran cámara, pero ¿podrían haber sido aún mejores con OIS y Dual Pixel PDAF agregados? Absolutamente.

No me malinterpretes, como dije, los teléfonos Pixel tienen una cámara absolutamente impresionante, pero no puedes culparme por querer más, especialmente cuando el camino hacia esas mejoras es tan claro (y cuando los teléfonos tienen el precio completo de un buque insignia, donde se espera lo mejor de mejor). Siempre habrá una parte de mí que quiere más, que quiere una mejor duración de la batería, procesadores más rápidos, una mejor duración de la batería y más brillo. y pantallas más vívidas, parlantes más potentes, mejores cámaras, más almacenamiento, mejor duración de la batería y, lo más importante, mejor duración de la batería. (de nuevo). Dicho esto, los teléfonos Pixel tienen muchas pequeñas características fantásticas que podrían unirse para crear un dispositivo verdaderamente prometedor, algo que estoy emocionado de ver.