Abbiamo contattato Sony per provare a saperne di più sul sensore IMX378 utilizzato dai prossimi telefoni Google Pixel e Pixel XL. Scopri tutto!

Panoramica dell'IMX378

Abbiamo contattato Sony per provare a saperne di più sul sensore IMX378 utilizzato dal prossimo Google Pixel E PixelXL telefoni, così come dal Xiaomi Mi 5S. Sfortunatamente, Sony non è ancora riuscita a distribuire la scheda tecnica del sensore Exmor RS IMX378, ma lo ha fatto sono stati estremamente utili e sono stati in grado di fornirci alcune informazioni inedite sul IMX378.

Innanzitutto, il nome stesso era sbagliato. Nonostante le voci affermassero che avrebbe fatto parte del Exmor R linea di sensori CMOS Backside Illuminated (BSI) come l'IMX377 prima che fosse utilizzato in Nesso 5X E Nesso 6P, il nostro contatto in Sony ci ha informato che l'IMX378 sarà invece considerato parte di Sony Exmor RS linea di sensori CMOS Stacked BSI.

Sebbene molte cose siano rimaste le stesse dall'IMX377 all'IMX378, inclusa la dimensione dei pixel (1,55 μm) e la dimensione del sensore (7,81 mm), sono state aggiunte un paio di funzionalità chiave. Vale a dire che ora è un design CMOS BSI in pila, ha PDAF, aggiunge la tecnologia SME-HDR di Sony e ha un supporto migliore per i video ad alto frame rate (al rallentatore).

CMOS BSI impilati

L'illuminazione posteriore di per sé è una funzionalità estremamente utile che è diventata quasi standard negli smartphone di punta negli ultimi anni, a partire dal HTC Evo 4G nel 2010. Consente alla fotocamera di catturare sostanzialmente più luce (al costo di più rumore) spostandone una parte la struttura che tradizionalmente si trovava davanti al fotodiodo sui sensori illuminati anteriori, dietro Esso.

Sorprendentemente, a differenza della maggior parte della tecnologia fotografica, l’illuminazione posteriore ha iniziato ad apparire nei telefoni prima delle DSLR, in gran parte grazie alle difficoltà nella creazione di sensori BSI più grandi. Il primo sensore APS-C di BSI è stato il Samsung S5KVB2 che è stato trovato nella loro fotocamera NX1 del 2014, e il primo sensore full-frame è stato il Sony Exmor R IMX251 presente nella Sony α7R II dello scorso anno anno.

La tecnologia Stacked BSI CMOS fa un ulteriore passo avanti spostando una parte maggiore dei circuiti dallo strato anteriore al substrato di supporto dietro i fotodiodi. Ciò non solo consente a Sony di ridurre sostanzialmente le dimensioni del sensore di immagine (consentendo sensori più grandi con lo stesso ingombro), ma consente anche a Sony di stampare pixel e circuiti separatamente (anche su processi produttivi diversi), riducendo il rischio di difetti, migliorando i rendimenti e consentendo una maggiore specializzazione tra i fotodiodi e il supporto circuiti.

L'IMX378 aggiunge la messa a fuoco automatica a rilevamento di fase, che i telefoni Nexus dell'anno scorso e l'IMX377 non supportavano. Consente alla fotocamera di utilizzare in modo efficace le differenze di intensità della luce tra diversi punti sul sensore per l'identificazione se l'oggetto che la fotocamera sta tentando di mettere a fuoco si trova davanti o dietro il punto AF e regolare il sensore di conseguenza. Si tratta di un enorme miglioramento sia in termini di velocità che di precisione rispetto al tradizionale autofocus basato sul contrasto che abbiamo visto su molte fotocamere in passato. Di conseguenza, abbiamo assistito a un'esplosione assoluta di telefoni che utilizzano PDAF, ed è diventata un'enorme parola d'ordine nel marketing, considerata il fulcro del marketing delle fotocamere in tutto il settore.

L'IMX378 aggiunge la messa a fuoco automatica a rilevamento di fase, che i telefoni Nexus dell'anno scorso e l'IMX377 non supportavano. Consente alla fotocamera di utilizzare in modo efficace le differenze di intensità della luce tra diversi punti sul sensore per l'identificazione se l'oggetto che la fotocamera sta tentando di mettere a fuoco si trova davanti o dietro il punto AF e regolare il sensore di conseguenza. Si tratta di un enorme miglioramento sia in termini di velocità che di precisione rispetto al tradizionale autofocus basato sul contrasto che abbiamo visto su molte fotocamere in passato. Di conseguenza, abbiamo assistito a un'esplosione assoluta di telefoni che utilizzano PDAF, ed è diventata un'enorme parola d'ordine nel marketing, considerata il fulcro del marketing delle fotocamere in tutto il settore.

Sebbene non sia così veloce nella messa a fuoco come il doppio fotodiodo PDAF del Samsung Galaxy S7 ha (noto anche come “PDAF a doppio pixel” E “Messa a fuoco automatica Duo Pixel”), che consente di utilizzare ogni singolo pixel per il rilevamento di fase includendo due fotodiodi per pixel, la fusione di PDAF e autofocus laser dovrebbe comunque essere una combinazione potente.

Frequenza fotogrammi elevata

Ultimamente si parla molto di fotocamere con frame rate elevato (sia per applicazioni consumer, sia nel cinema professionale). La possibilità di scattare a frame rate più elevati può essere utilizzata sia per creare video incredibilmente fluidi che per velocità regolare (che può essere fantastico per lo sport e altri scenari ad alta velocità) e per crearne alcuni Veramente video interessanti quando rallenti tutto.

Sfortunatamente, è estremamente difficile girare video con frame rate più elevati e anche con la fotocamera il sensore può scattare a frame rate più elevati, può essere difficile per il processore del segnale immagine del telefono mantenere su. Ecco perché mentre l'IMX377 utilizzato nei Nexus 5X e 6P poteva girare video 720p a 300 Hz e video 1080p a 120 Hz, abbiamo visto solo 120 Hz 720p dal Nexus 5X e 240 Hz 720p dal 6P. L'IMX377 era anche in grado di riprodurre video 4K a 60 Hz, nonostante i dispositivi Nexus fossero limitati a 30 Hz.

I telefoni Pixel sono entrambi in grado di portare video fino a 120 Hz 1080p e video a 240 Hz 720p grazie a parte dei miglioramenti legati all'IMX378, che vede un aumento delle capacità fino a 240 Hz a 1080p.

Il sensore è anche in grado di scattare foto a raffica a piena risoluzione più velocemente, aumentando fino a 60 Hz con uscita a 10 bit e 40 Hz a 12 bit uscita (rispettivamente da 40 Hz e 35 Hz), che dovrebbe aiutare a ridurre la quantità di motion blur e vibrazioni della fotocamera durante l'utilizzo HDR+.

PMI-HDR

Tradizionalmente, l’HDR per i video è stato un compromesso. O dovevi dimezzare il frame rate o la risoluzione. Di conseguenza, molti OEM non se ne sono nemmeno preoccupati, Samsung e Sony sono tra i pochi a implementarlo. Persino il SamsungGalaxy Nota7 è limitato alla registrazione 1080p 30 Hz a causa in parte dell'elevato costo computazionale del video HDR.

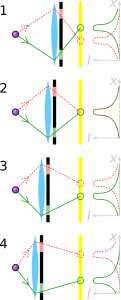

Il primo dei due principali metodi tradizionali per i video HDR, chiamato Red Digital Cinema Camera Company HDRx e che Sony chiama Digital Overlap HDR (DOL-HDR), funziona prendendo due immagini consecutive, una esposta più scura e una esposta più chiara, e unendole insieme per creare un singolo fotogramma video. Mentre ciò ti consente di mantenere la piena risoluzione della fotocamera (e impostare velocità dell'otturatore diverse per i due separati fotogrammi), spesso possono verificarsi problemi dovuti all'intervallo di tempo tra i due fotogrammi (soprattutto in caso di movimento rapido oggetti). Inoltre, può essere molto difficile per il processore tenere il passo, poiché con DOL-HDR, l'ISP del telefono gestisce l'unione dei fotogrammi separati insieme.

L'altro metodo tradizionale, che Sony chiama Binning Multiplexed Exposure HDR (BME-HDR), imposta un'impostazione di esposizione diversa per ogni coppia di due linee di pixel nel sensore per creare contemporaneamente due immagini a mezza risoluzione, che vengono poi unite in un unico fotogramma HDR per il video. Sebbene questo metodo eviti i problemi associati all'HDRx, ovvero la riduzione del frame rate, presenta altri problemi, in particolare la riduzione della risoluzione e i limiti su come è possibile modificare l'esposizione tra i due set di linee.

L'esposizione spazialmente multiplex (SME-HDR) è un nuovo metodo utilizzato da Sony per consentire riprese HDR alla massima risoluzione e al massimo frame rate di cui è capace il sensore. È una variante di Esposizione spazialmente variabile che utilizza algoritmi proprietari per consentire a Sony di catturare le informazioni dai pixel scuri e chiari, che sono disposti in uno schema a scacchiera e dedurre l'immagine a piena risoluzione sia per l'esposizione al buio che alla luce immagini.

Sfortunatamente, Sony non è stata in grado di fornirci spiegazioni più dettagliate sullo schema esatto e potrebbe non essere mai in grado di rivelarlo: le aziende tendono a giocare le loro carte molto vicino a loro quando si tratta di tecnologia all'avanguardia, come quella che vediamo in HDR, con persino Google che ha il proprio algoritmo proprietario per le foto HDR noto come HDR+. Tuttavia, ci sono ancora alcune informazioni pubblicamente disponibili che possiamo utilizzare per capire come realizzarlo. Un paio di articoli sono stati pubblicati da Shree K. Nayar della Columbia University (uno dei quali era in collaborazione con Tomoo Mitsunaga di Sony) che contengono diversi modi per utilizzare l'esposizione spazialmente variabile e diversi layout che possono ottenerla. Di seguito è riportato un esempio di layout con quattro livelli di esposizione su un sensore di immagine RGBG. Questo layout afferma di essere in grado di ottenere immagini HDR a piena risoluzione con acquisizione singola con solo un 20% circa perdita di risoluzione spaziale, a seconda dello scenario (lo stesso risultato rivendicato da Sony PMI-HDR).

Sony ha già utilizzato SME-HDR in un paio di sensori di immagine, incluso l'IMX214 che ha visto molta popolarità ultimamente (utilizzato nei Asus Zenfone 3 Laser, il MotoZ, e il Prestazioni dell'Xperia X), ma è una nuova aggiunta all'IMX378 rispetto all'IMX377 utilizzato l'anno scorso. Consente al sensore della fotocamera di riprodurre sia video a piena risoluzione a 10 bit che video 4K a 60 Hz con SME-HDR attivo. Anche se un collo di bottiglia in un altro punto del processo comporterà un limite inferiore, si tratta di un fantastico miglioramento rispetto a ciò di cui era capace l'IMX377, ed è un segno di cose buone in arrivo in futuro.

Uno dei grandi miglioramenti dell'IMX378 rispetto all'IMX377 è che è in grado di gestire una maggiore quantità di elaborazione delle immagini su chip, riducendo il carico di lavoro dell'ISP (sebbene l'ISP sia comunque in grado di richiedere i dati dell'immagine RAW, a seconda di come l'OEM decide di utilizzare il sensore). Può gestire molte piccole cose come la correzione dei difetti e il mirroring localmente, ma, cosa ancora più importante, può anche gestire BME-HDR o SME-HDR senza dover coinvolgere l'ISP. Ciò potrebbe potenzialmente rappresentare una grande differenza in futuro, liberando alcune spese generali per l’ISP sui futuri telefoni.

Vorremmo ringraziare ancora una volta Sony per tutto l'aiuto nella creazione di questo articolo. Apprezziamo davvero l'impegno profuso da Sony per garantire l'accuratezza e la profondità di tutto questo caratteristica, soprattutto nel permetterci di scoprire alcune informazioni inedite sul IMX378.

Detto questo, è davvero un peccato che sia così difficile accedere ad alcune di queste informazioni, anche alle informazioni di base sul prodotto. Quando le aziende cercano di inserire informazioni nei propri siti web, spesso queste risultano piuttosto inaccessibili e incomplete in parte perché viene spesso trattata come una preoccupazione secondaria dei dipendenti dell’azienda, che sono più concentrati su quella principale lavoro. Una persona dedicata alla gestione delle pubbliche relazioni può fare un'enorme differenza in termini di produzione di questo tipo di informazioni disponibili e accessibili al grande pubblico, e stiamo vedendo alcune persone che cercano di fare proprio questo gratuitamente tempo. Anche sul Sony Exmor Lo stesso articolo di Wikipedia, in cui nel corso di un paio di mesi una sola persona nel tempo libero ha gettato la maggior parte delle basi per riprenderlo da un quasi inutile Articolo da 1.715 byte che era stato più o meno lo stesso per anni, nell'articolo da circa 50.000 byte che vediamo oggi con 185 redattori distinti. Un articolo che è senza dubbio il miglior archivio di informazioni sulla linea di sensori Sony Exmor disponibile online e possiamo vedere uno schema molto simile su altri articoli. Un singolo scrittore dedicato può fare una differenza sostanziale nella facilità con cui i clienti possono confrontare prodotti diversi prodotti e dal modo in cui i consumatori interessati sono istruiti sull’argomento, che può avere una vasta portata effetti. Ma questo è un argomento per un’altra volta.

Come sempre, ci chiediamo come queste modifiche hardware influenzeranno i dispositivi stessi. Chiaramente non otterremo video HDR 4K a 60 Hz (e potremmo non ricevere affatto video HDR, poiché Google non ne ha ancora parlato), ma la risoluzione completa più veloce probabilmente le riprese aiuteranno sostanzialmente con HDR+ e vedremo i miglioramenti del nuovo sensore diffondersi nel telefono in altri modi simili, piccoli ma sostanziali anche.

Mentre DXOMark elenca i Pixel telefoni con prestazioni leggermente migliori rispetto al Samsung Galaxy S7 e all'HTC 10, molte delle cose che hanno dato ai telefoni Pixel quel piccolo vantaggio erano software importanti miglioramenti come HDR+ (che produce risultati assolutamente fantastici e a cui DXOMark ha dedicato un'intera sezione della loro recensione) e lo speciale EIS di Google (che può funzionare in tandem con OIS) che campiona il giroscopio 200 volte al secondo per fornire la migliore stabilizzazione elettronica dell'immagine mai vista prima visto. Sì, i telefoni Pixel hanno un'ottima fotocamera, ma avrebbero potuto essere ancora migliori con l'aggiunta di OIS e Dual Pixel PDAF? Assolutamente.

Non fraintendetemi, come ho detto, i telefoni Pixel hanno una fotocamera assolutamente straordinaria, ma non potete davvero biasimarmi se voglio di più, soprattutto quando il percorso verso questi miglioramenti è così chiaro (e quando i telefoni hanno un prezzo di punta pieno, dove ti aspetti il meglio del migliore). Ci sarà sempre una parte di me che vorrà di più, che vorrà una durata della batteria migliore, processori più veloci, una durata della batteria migliore, e schermi più vividi, altoparlanti più potenti, fotocamere migliori, più spazio di archiviazione, migliore durata della batteria e, soprattutto, migliore durata della batteria (Ancora). Detto questo, i telefoni Pixel hanno molte piccole fantastiche funzionalità che potrebbero unirsi per creare un dispositivo davvero promettente, cosa che sono entusiasta di vedere.