見ている間 WWDC21基調講演 数週間前、私は繰り返しのテーマに気づき始めました。 そして、そのテーマは、今後のiOS15機能のいくつかがiPhoneのニューラルエンジンを利用しているように見えるということです。

ニューラルエンジンは、2017年にiPhoneXがリリースされてからiPhoneに搭載されています。 しかし、私たちのほとんどは、最初のリリースから4年間、このプロセッサの効果をまったく感じていないと思います。

WWDC21は、iOS15が久しぶりの未来的なiOSアップデートであるというこの感覚を私に与え続けました。 そして、これについてAppleからの公式の確認はありませんが、それはAppleがついにNeuralEngineを最大限に活用しているためだと思います。

この投稿では、Neural Engineとは何かについて簡単に説明した後、このプロセッサを最大限に活用していると思われるすべての新しいiOS15機能について詳しく説明します。 最後に、iOSが現在Neural Engineを使用している主な方法について説明します。これにより、iOS15の今後のリリースと比較できるようになります。

さて、それに入りましょう!

コンテンツ

- iPhoneのニューラルエンジンとは何ですか?

-

iOS15の機能がニューラルエンジンをどのように活用し始めているか

- あなたのiPhoneはあなたの写真のテキストを読むことができます

- iOS 15の機能により、iPhoneは写真のコンテンツを認識して識別できるようになります

- 写真の思い出は、より洗練された「本物の」感覚になります

- 通知、ウィジェット、およびサイレントがよりスマートになっています

- iOS 15の新機能により、カメラで道順を簡単に取得できるようになります

- Siriはあなたのデバイスでより多くの処理を行います

-

今後のiOS15機能なしでNeuralEngineは何ができるでしょうか?

- ニューラルエンジンは、より良い写真を撮るのに役立ちます

- 機械学習により、FaceIDは高速、安全、かつ適応性のあるものになります

- ニューラルエンジンは、iPhoneでのAR体験で重要な役割を果たします

-

今後のiOS15の機能は、iPhoneのよりスマートな未来を示しています

- 関連記事:

iPhoneのニューラルエンジンとは何ですか?

Neural Engineは、iPhone X以降のプロセッサであり、機械学習操作を処理します。 このプロセッサが機械学習を強化する能力が非常に重要であるため、このプロセッサを理解するには機械学習を理解することが重要です。

機械学習とは、プログラマーとは無関係に実行するコードを決定するソフトウェアを指します。

通常、ソフトウェアは非常に具体的で制御されたデータを処理する必要があります。 そのため、Siriはあるフレーズであなたの意図を理解しますが、別のフレーズでは理解できません。たとえ各フレーズの意図が同じであっても。 Siriは、データを特定の構造にする必要があります。そうしないと、失敗します。

機械学習はそれを変える方法です。 これにより、ソフトウェアは構造化されていないデータを取り込み、それを処理することができます。 Siriが奇妙な言い回しのリクエストを理解したことに驚いた場合、それはおそらくSiriの機械学習機能が向上したためです。

ニューラルエンジンは、その名前が示すように、これを可能にする携帯電話のエンジンです。

これらの概念を理解するのは少し難しいかもしれませんし、私はそれらを説明するのに最善の仕事をしていないかもしれないことを知っています。 この投稿では、物事を短くシンプルにしようとしていますが、さらに深く掘り下げたい場合は、チェックアウトする必要があります この郵便受け!

iOS15の機能がニューラルエンジンをどのように活用し始めているか

iPhoneのニューラルエンジンの問題は、それが強力ではないということではなく、その能力がiPhoneで十分に活用されていないということです。 過去4年間、拡張現実などの限られたインスタンスで機能するようになりました。 役に立ちますが、iPhoneに革命を起こしたわけではありません。

iOS 15のいくつかの機能は、NeuralEngineのより革新的な未来を示していると思います。 このプロセッサがなければ、以下で分解しようとしている新機能はどれも可能ではないと思います。 では、これらの機能がNeuralEngineを最大限に活用する方法を見てみましょう。

あなたのiPhoneはあなたの写真のテキストを読むことができます

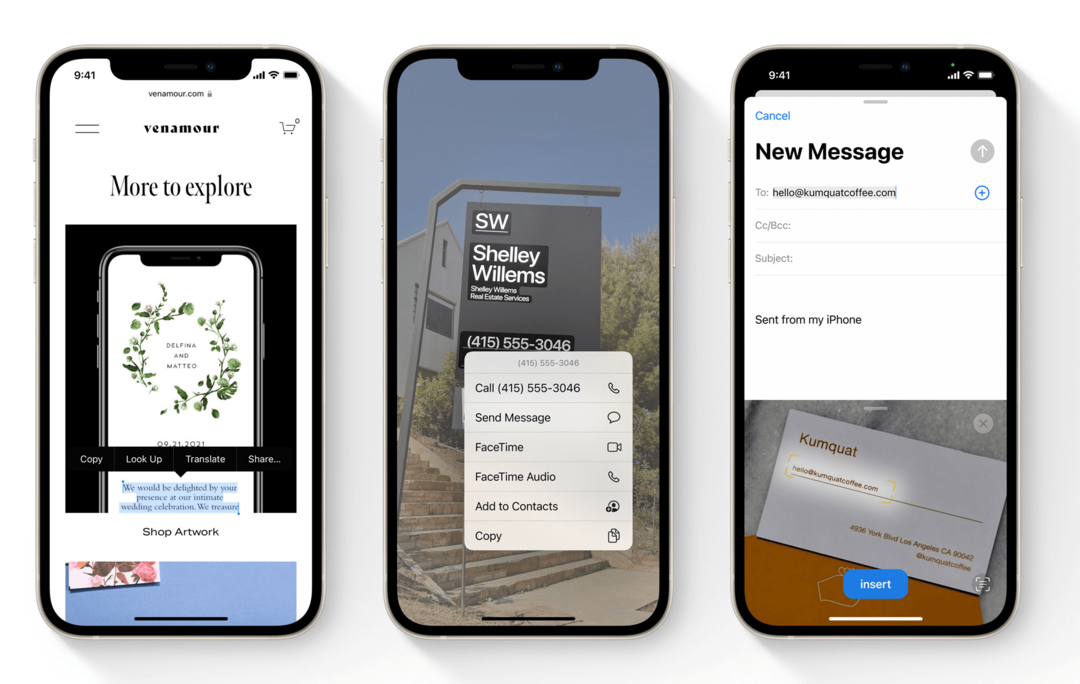

「機械学習」を叫んだiOS15の最初の機能。 私にとってはライブテキストでした。 ライブテキストは、iPhoneがフォトアプリでテキストを読み取れるようにするiOS15の機能です。

つまり、テキストが印刷されたものなら何でも写真を撮り、その写真をフォトアプリで開くと、そのテキストを操作できるようになります。 写真の電話番号をタップしたり、ドキュメントの写真からテキストをコピーして貼り付けたり、写真の検索バーを使用して写真のテキストを検索したりできます。

この機能により、iPhoneは写真の手書き文字を読み取ることもできます。 カメラアプリでも動作するため、iPhoneカメラのファインダー内のテキストをリアルタイムで操作できます。

機械学習がなければ、このような機能はほぼ不可能です。 そのため、これらのオンラインセキュリティテストでは、ワープされたテキストを使用して、ロボットではないことを証明しています。 プログラムがテキストを読めるようにするのは難しいからです。

フォント、スタイル、色、角度に関係なく、リアルタイムでテキストを読み取ることができるスマートフォンの機能は非常に便利であるだけでなく、モバイル機械学習の優れた使用法でもあります。

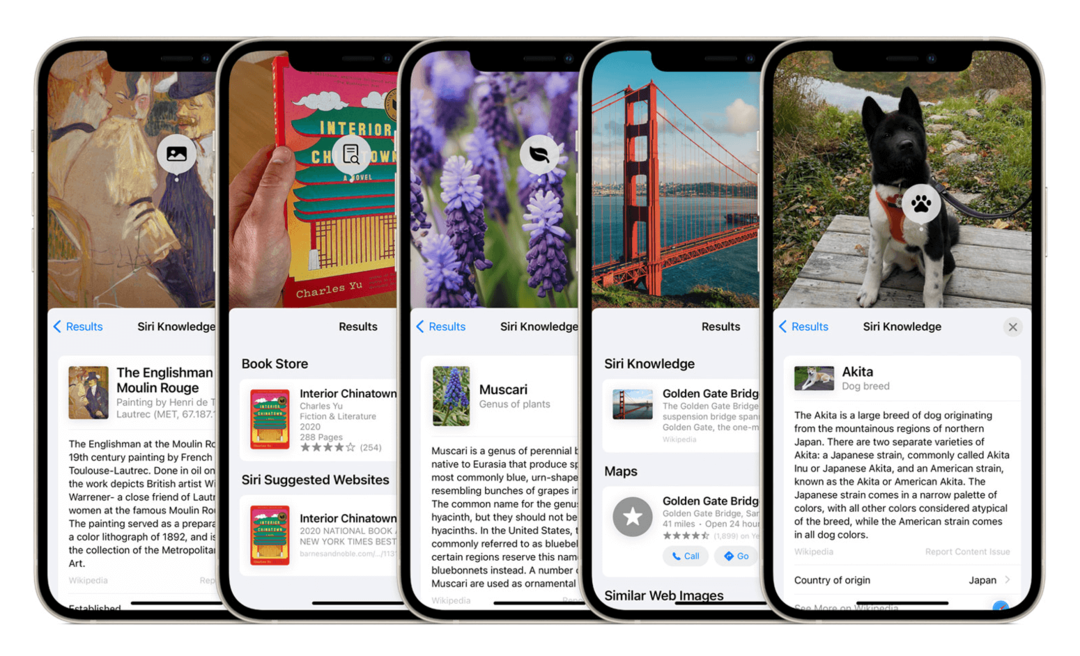

iOS 15の機能により、iPhoneは写真のコンテンツを認識して識別できるようになります

NeuralEngineを使用するiOS15の新機能のもう1つは、写真でのオブジェクト認識です。 この機能は、テキストではなくオブジェクトを認識することを除いて、ライブテキストと同様に機能します。 Appleが使用した例は、iPhoneカメラを犬に向けることができ、iPhoneはそれが犬であるだけでなく、犬の品種でもあることを認識します。

iPhoneはしばらくの間、写真から顔を引き出すことができました。これは、制限はありますが、オブジェクト認識の一種です。 この機能の拡張により、iPhoneは写真の非構造化データとその中のIDオブジェクトをすばやく確認できるようになります。

ニューラルエンジンが検索しなければならないパターンの一貫性がはるかに低くなるため、これはライブテキストよりも印象的(かつ困難)です。 あなたのiPhoneは、そのような決定を下せるようにするために、何千もの(数十万ではないにしても)決定を下す必要があります。

犬の品種を特定するには、まず犬が背景とは別のオブジェクトであることを確認する必要があります。次に、その犬の周囲に境界線を描画する必要があります。 それが犬であると判断できるまでその犬の明確な特徴を選び出し、次にそれがどの種類の犬であるかを判断するためにさらに多くの特徴を引き出します は。

この種のコンピューティングは、機械学習プロセッサでのみ可能です。

写真の思い出は、より洗練された「本物の」感覚になります

ニューラルエンジンのタッチアップを取得する予定のフォトアプリのもう1つの機能は、メモリです。

この機能は、特定の時間(通常は特定の日)から写真を撮り、それらを短いビデオにまとめて表示します。 Memoriesは、休暇、パーティー、記念日などのビデオコラージュを自動的に作成するという考えです。

メモリは、品質が大幅に向上するiOS15の機能の1つです。 AppleMusicライブラリの音楽がメモリに自動的に組み込まれます。

Photosが選択する音楽は、ビデオに合わせて適切なペースで配置されるだけでなく、ビデオのコンテンツとも一致する必要があります。 たとえば、パーティーの画像はエネルギッシュな音楽と組み合わせる必要がありますが、より思慮深い写真には遅い音楽を添付する必要があります。

私はこの機能を頻繁に使用しませんが、その背後にあるコンピュータサイエンスは非常に魅力的です。 オブジェクトと風景の認識を組み合わせ、コンテンツ、場所、期間に基づいて写真をグループ化し、日常の平均的な写真を特別な生活に関連付けられた写真から分離します イベントは、それらの写真のムードと好きな曲のムードを結び付け、スライドショープレゼンテーションでそれらをペアリングし、そのプレゼンテーションをビートに合わせて調整します。 音楽。

Memoriesは常にNeuralEngineを使用してきました。 そして、iOSの次のバージョンは、この機能のインテリジェンスを大幅に向上させるように設定されています。

通知、ウィジェット、およびサイレントがよりスマートになっています

NeuralEngineをさらに活用しているiOS15の機能のグループは、通知、ウィジェット、およびサイレントです。

ウィジェットはiOS14で機械学習の使用を開始しましたが、ここにウィジェットを追加すると便利だと思いました。 スマートスタックを使用すると、ウィジェットを互いに重ねることができます。 その後、iPhoneは一日中それらをめくり、いつでも最も関連性の高いウィジェットであると考えているものを表示します。

これらの種類の決定は、1日のさまざまな時間帯で、特定のアプリを使用した後の行動を分析することによって行われます。 Neural Engineはこのデータを取得して解釈し、このデータに従ってウィジェットを表示します。

iOS15の新機能は非常によく似た動作をするように設定されています。

通知は通知の概要にグループ化されるようになったため、重要度の低い通知が1日中ロック画面に表示されることはありません。 通知の概要機能をカスタマイズすることも、NeuralEngineに処理させることもできます。

Do Not Disturbは、分類方法に基づいて特定の通知を非表示にする新しいコンポーネント、Focusを取得しています。 フォーカスを手動で管理することも、インテリジェントに管理させることもできます。

これら3つの機能はすべて、非常によく似た機械学習指標を使用して、行動を予測し、適応させます。

iOS 15の新機能により、カメラで道順を簡単に取得できるようになります

これは、私が思っていたほど興奮したことのないiOS15の機能の1つです。 特に機械学習のコンテキストでは、それでも非常に興味深いと思います。

iOS 15のマップでは、歩きながらカメラを向けることができます。 これにより、環境に投影されたAR方向を確認できます。 映画にアクセスしようとしていて、どちらの道を進むべきかわからないとします。 iPhoneを向けると、周囲の通りや建物で強調表示されている道順を確認できます。

iPhoneでの拡張現実は、ニューラルエンジンを含めることで可能になったため、この機能の起源は機械学習にあります。 しかし、この機能は、ARと画像認識および位置検出を組み合わせて、信じられないほどのリアルタイム体験を提供します。

発売時にはいくつかの都市でのみ利用可能になる予定ですが、この機能は、iPhoneでの機械学習がバックグラウンドで役立つだけではない未来を示しています。 それはあなたがあなたの快適ゾーンや能力の外にあることを即座に達成するのを助けることができるでしょう。

Siriはあなたのデバイスでより多くの処理を行います

NeuralEngineをさらに活用するiOS15の最後の機能はSiriです。 Siriは常に機械学習を使用してきました。 しかし、その学習はまだニューラルエンジンの可能性を最大限に引き出していません。

これは、Siriがオフデバイス処理を使用しているためです。 つまり、iPhoneはリクエストをリッスンし、リクエストを処理するAppleサーバーに送信してから、iPhoneのSiriに返送してそのリクエストに対応します。

これが行われた理由は、iPhoneがサポートできる以上にSiriのパワーを高めるためでした。 ただし、iOS 15では、これは変更されるように設定されています。 これで、SiriはiPhoneで処理の大部分を実行します。 これにより、Siriはより速く、よりスマートに、そしてより信頼できるものになるはずです。

このアップデートでは、おそらくNeuralEngineからの支援は最小限で済むと思います。 したがって、リストの最後に配置されます。 ただし、Siriがよりスマートになっていることを示しているので、注目に値します。 遠く離れたサーバーではなく、iPhoneのハードウェアを使用するより有能なアシスタント。

今後のiOS15機能なしでNeuralEngineは何ができるでしょうか?

以上です! 私の知る限り、これがiOS15の機能がNeuralEngineの生のパワーを使い始める新しい方法のすべてです。

この投稿の最後に、NeuralEngineがiPhoneですでに行っていることのいくつかに焦点を当てた簡単なセクションを含めたいと思いました。 そうすれば、現在の場所と数か月後の場所を比較できます。

うまくいけば、これはあなたがiOSへの今後の変更を新しい観点から理解し、このような機能があなたのiPhoneにどのようにもたらされるかをよりよく理解するのに役立つでしょう。

ニューラルエンジンは、より良い写真を撮るのに役立ちます

2017年以来iPhoneでNeuralEngineが最も多く使用されているのは、写真撮影です。 毎年、Appleは、最新のiPhoneが前世代よりも多くの写真計算を実行できるようになることを示しています。 Appleは、「画像プロセッサは写真ごとにX百万の計算/決定を行っている」と言っています。

これは、写真を撮るたびにNeuralEngineが実行する計算の数を指します。 色、照明、コントラスト要素、被写体、背景、およびその他の多数の要素を調べます。 そして、これらすべての要素を瞬時に最適に評価、調整、吸収、およびバランス調整する方法を決定します。

ポートレートモードやディープフュージョンなどを可能にしたのは、この機械学習プロセスです。 ポートレートモードはあなたを背景から隔離することができ、DeepFusionはiPhoneでの夜の写真撮影を以前よりも大幅に改善しました。

ニューラルエンジンは、ハードウェアの制約があるため、iPhoneのカメラにとって重要です。 iPhoneのサイズが原因で、カメラとそのレンズの機能には制限があります。 iPhoneの写真をプロのデジタル一眼レフの写真と同等にするのは、写真を撮るときに発生するコンピューティングと機械学習です。

機械学習により、FaceIDは高速、安全、かつ適応性のあるものになります

もちろん、ニューラルエンジンについては、なぜ作成されたのかを説明せずに話すことはできません。

そうです–FaceIDを可能にするためにNeuralEngineがiPhoneXに追加されました。 ご存じない方のために説明すると、FaceIDはiPhoneの最も洗練された複雑な機能の1つです。

FaceIDは、自分撮りカメラの顔の2D画像を別の顔の2D画像と比較するだけではありません。 それはあなたの顔の3Dマップを見て、あなたの目の動きを追跡し、それをあなたの顔の以前の3Dスキャンと比較します。

FaceIDは、顔が動いていて、部分的に隠されていて、さまざまな角度にあるときに、2秒未満でこれを実行するだけではありません。 それはまたあなたの顔が日々微妙に変化する方法に適応します。 そのため、顔を再スキャンしなくても、あごひげを生やしたり、年をとったり、その他の微妙な方法で変更したりできます。

FaceIDとNeuralEngineは、iPhoneのロックを解除するたびに、顔から学習します。 Neural Engineがなければ、FaceIDは現在の半分の速度、安全性、信頼性を備えていません。

ニューラルエンジンは、iPhoneでのAR体験で重要な役割を果たします

最後に、ニューラルエンジンはiPhoneのARで重要な役割を果たします。 知らない人のために、拡張現実(AR)は、iPhoneカメラのファインダーを介して3Dモデルを環境に投影する機能です。 iPhoneのMeasureアプリを使用して、これを自分でテストできます。

この種の機能は、画像認識、空間認識、記憶などを組み合わせたものです。 これらはすべて、ニューラルエンジンがテーブルにもたらすパワーを必要とします。

幸いなことに、iOS 15の新機能の多くは、iPhone上のARをさらに強力にするように設定されています。 ARはモバイルデバイスの最も不可欠な機能の1つになる可能性があると思うので、これは今後も続くことを願っています。

今後のiOS15の機能は、iPhoneのよりスマートな未来を示しています

全体として、これらのiOS15の機能が私たちに垣間見せてくれる将来に非常に興奮しています。 iPhoneには、少し活用されていないと感じる側面がいくつかありますが、NeuralEngineほどではありません。 私はこの変化を楽しみにしています、そしてあなたもそうすることを願っています!

Appleに関するその他のニュース、洞察、ヒントについては、残りの記事をご覧ください。 AppleToolBoxブログ!