Skontaktowaliśmy się z firmą Sony, aby dowiedzieć się więcej na temat czujnika IMX378 używanego w nadchodzących telefonach Google Pixel i Pixel XL. Dowiedz się wszystkiego na ten temat!

Przegląd IMX378

Skontaktowaliśmy się z firmą Sony, aby dowiedzieć się nieco więcej na temat czujnika IMX378 używanego w nadchodzącym Google Piksel I Piksel XL telefony, a także przez Xiaomi Mi 5S. Niestety firmie Sony nie udało się jeszcze rozpowszechnić arkusza danych czujnika Exmor RS IMX378, ale udało się byli niezwykle pomocni i byli w stanie dostarczyć nam niepublikowanych wcześniej informacji na temat IMX378.

Po pierwsze, sama nazwa była błędna. Pomimo plotek głoszących, że będzie to część Exmor R linia czujników CMOS Backside Illuminated (BSI), takich jak IMX377 wcześniej, który był używany w Nexusa 5X I Nexusa 6P, nasz kontakt w Sony poinformował nas, że IMX378 będzie zamiast tego uważany za część Sony Exmor RS linia czujników Stacked BSI CMOS.

Chociaż wiele rzeczy pozostało takich samych od IMX377 do IMX378, w tym rozmiar piksela (1,55 μm) i rozmiar czujnika (7,81 mm), dodano kilka kluczowych funkcji. Mianowicie jest to teraz konstrukcja stosowa BSI CMOS, ma PDAF, dodaje technologię Sony SME-HDR i lepiej obsługuje wideo o dużej liczbie klatek na sekundę (w zwolnionym tempie).

Skumulowana pamięć CMOS BSI

Samo podświetlenie tyłu jest niezwykle przydatną funkcją, która od kilku lat stała się niemal standardem we flagowych smartfonach, począwszy od modelu HTC Evo 4G w 2010. Pozwala to kamerze uchwycić znacznie więcej światła (kosztem większego szumu) poprzez przesunięcie części konstrukcja, która tradycyjnie znajdowała się przed fotodiodą na przednich czujnikach podświetlanych, z tyłu To.

Co zaskakujące, w przeciwieństwie do większości technologii aparatów, oświetlenie tylne zaczęło pojawiać się w telefonach przed lustrzankami cyfrowymi, w dużej mierze dzięki trudnościom z tworzeniem większych czujników BSI. Pierwszą matrycą BSI APS-C był Samsung S5KVB2, który znalazł się w ich aparacie NX1 z 2014 roku i pierwszym pełnoklatkowym sensorem był Sony Exmor R IMX251, który od zeszłego roku znalazł się w Sony α7R II rok.

Technologia Stacked BSI CMOS idzie o krok dalej, przenosząc więcej obwodów z warstwy przedniej na podłoże nośne za fotodiodami. Pozwala to firmie Sony nie tylko znacznie zmniejszyć rozmiar czujnika obrazu (umożliwiając zastosowanie większych czujników na tej samej powierzchni), ale także umożliwia firmie Sony drukowanie pikseli i obwodów oddzielnie (nawet w różnych procesach produkcyjnych), zmniejszając ryzyko defektów, poprawiając wydajność i umożliwiając większą specjalizację pomiędzy fotodiodami a nośnikiem obwody.

PDAF

IMX378 dodaje autofokus z detekcją fazy, którego nie obsługiwały zeszłoroczne telefony Nexus i IMX377. Umożliwia to kamerze efektywne wykorzystanie różnic w natężeniu światła pomiędzy różnymi punktami czujnika w celu identyfikacji jeśli obiekt, na którym aparat próbuje ustawić ostrość, znajduje się przed lub za punktem ostrości, i wyreguluj czujnik odpowiednio. Stanowi to ogromną poprawę zarówno pod względem szybkości, jak i dokładności w porównaniu z tradycyjnym autofokusem opartym na kontraście, który widzieliśmy w wielu aparatach w przeszłości. W rezultacie zaobserwowaliśmy absolutną eksplozję telefonów korzystających z protokołu PDAF, który stał się ogromnym marketingowym hasłem, uznawanym za centralny element marketingu aparatów fotograficznych w całej branży.

IMX378 dodaje autofokus z detekcją fazy, którego nie obsługiwały zeszłoroczne telefony Nexus i IMX377. Umożliwia to kamerze efektywne wykorzystanie różnic w natężeniu światła pomiędzy różnymi punktami czujnika w celu identyfikacji jeśli obiekt, na którym aparat próbuje ustawić ostrość, znajduje się przed lub za punktem ostrości, i wyreguluj czujnik odpowiednio. Stanowi to ogromną poprawę zarówno pod względem szybkości, jak i dokładności w porównaniu z tradycyjnym autofokusem opartym na kontraście, który widzieliśmy w wielu aparatach w przeszłości. W rezultacie zaobserwowaliśmy absolutną eksplozję telefonów korzystających z protokołu PDAF, który stał się ogromnym marketingowym hasłem, uznawanym za centralny element marketingu aparatów fotograficznych w całej branży.

Chociaż nie jest tak szybki w ustawianiu ostrości jak podwójna fotodioda PDAF Samsunga Galaxy S7 ma (znany również jako „Podwójny piksel PDAF” I „Dwupikselowy autofokus”), co pozwala na wykorzystanie każdego pojedynczego piksela do detekcji fazy poprzez dodanie dwóch fotodiod na piksel, połączenie PDAF i laserowego autofokusa powinno nadal być skuteczną kombinacją.

Wysoka liczba klatek na sekundę

Ostatnio dużo mówi się o kamerach o dużej liczbie klatek na sekundę (zarówno do zastosowań konsumenckich, jak i w profesjonalnym kręceniu filmów). Możliwość nagrywania z większą liczbą klatek na sekundę może zostać wykorzystana do tworzenia niesamowicie płynnych filmów normalną prędkość (która może być fantastyczna w przypadku sportów i innych scenariuszy wymagających dużej prędkości) i stworzyć ją Naprawdę ciekawe filmy kiedy wszystko spowalniasz.

Niestety niezwykle trudno jest nagrywać filmy z większą liczbą klatek na sekundę, nawet przy użyciu aparatu może nagrywać z większą liczbą klatek na sekundę, procesor sygnału obrazu w telefonie może mieć trudności z utrzymaniem tego sygnału w górę. Właśnie dlatego podczas gdy IMX377 używany w Nexusie 5X i 6P mógł nagrywać wideo 720p przy 300 Hz i 1080p przy 120 Hz, widzieliśmy tylko 120 Hz 720p z Nexusa 5X i 240 Hz 720p z 6P. IMX377 był również w stanie odtwarzać wideo 4K w częstotliwości 60 Hz, mimo że urządzenia Nexus były ograniczone do 30 Hz.

Dzięki temu oba telefony Pixel mogą odtwarzać wideo w rozdzielczości 120 Hz 1080p i 240 Hz w rozdzielczości 720p. częściowo z ulepszeń związanych z IMX378, w którym zaobserwowano wzrost możliwości do 240 Hz przy 1080p.

Czujnik może także szybciej wykonywać zdjęcia seryjne w pełnej rozdzielczości, zwiększając częstotliwość do 60 Hz przy 10-bitowym wyjściu i 40 Hz przy 12-bitowym wyjściowej (odpowiednio z 40 Hz i 35 Hz), co powinno pomóc zredukować rozmycie spowodowane ruchem i drgania aparatu podczas używania HDR+.

MŚP-HDR

Tradycyjnie HDR dla wideo był kompromisem. Trzeba było albo zmniejszyć liczbę klatek na sekundę o połowę, albo rozdzielczość o połowę. W rezultacie wielu producentów OEM nawet się tym nie zawracało, a Samsung i Sony są jednymi z nielicznych, którzy to wdrażają. Nawet Samsunga Galaxy Note7 jest ograniczone do nagrywania w rozdzielczości 1080p 30 Hz, częściowo ze względu na wysokie koszty obliczeniowe wideo HDR.

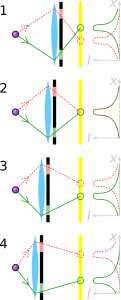

Pierwsza z dwóch głównych tradycyjnych metod wideo HDR, którą nazywa Red Digital Cinema Camera Company HDRx i który Sony nazywa Digital Overlap HDR (DOL-HDR), polega na wykonaniu dwóch kolejnych zdjęć, jednego ciemniejszego i jednego jaśniejszego, i połączeniu ich w jedną klatkę wideo. Pozwala to jednak zachować pełną rozdzielczość aparatu (i ustawić różne czasy otwarcia migawki dla dwóch oddzielnych klatek), często może to powodować problemy wynikające z odstępu czasowego między dwiema klatkami (szczególnie w przypadku szybko poruszających się klatek). obiekty). Ponadto procesor może mieć trudności z nadążaniem za tym, ponieważ w przypadku DOL-HDR dostawca usług internetowych telefonu zajmuje się łączeniem oddzielnych klatek.

Druga tradycyjna metoda, nazywana przez firmę Sony Binning Multiplexed Exposure HDR (BME-HDR), polega na ustawianiu innego ustawienia ekspozycji dla każda para dwóch linii pikseli w matrycy, aby jednocześnie utworzyć dwa obrazy o połowie rozdzielczości, które następnie są łączone w jedną klatkę HDR dla filmu. Chociaż ta metoda pozwala uniknąć problemów związanych z HDRx, a mianowicie zmniejszenia liczby klatek na sekundę, ma inne problemy, w szczególności zmniejszenie rozdzielczości i ograniczenia dotyczące sposobu zmiany ekspozycji między dwoma zestawami linie.

Przestrzennie multipleksowana ekspozycja (SME-HDR) to nowa metoda stosowana przez firmę Sony, która umożliwia rejestrowanie obrazu HDR w pełnej rozdzielczości i przy pełnej liczbie klatek na sekundę, na jaką pozwala matryca. Jest to odmiana Ekspozycja zmienna przestrzennie który wykorzystuje zastrzeżone algorytmy umożliwiające firmie Sony przechwytywanie informacji z ciemnych i jasnych pikseli, którymi są ułożone we wzór szachownicy i wywnioskować obraz w pełnej rozdzielczości zarówno dla ekspozycji ciemnej, jak i jasnej obrazy.

Niestety Sony nie było w stanie udzielić nam bardziej szczegółowych wyjaśnień na temat dokładnego wzoru i być może nigdy nie będzie w stanie go ujawnić – firmy zwykle grają w karty bardzo im bliskie, jeśli chodzi o najnowocześniejsze technologie, takie jak ta, którą widzimy w HDR, przy czym nawet Google ma swój własny, zastrzeżony algorytm dla zdjęć HDR, znany jako HDR+. Wciąż jednak istnieją publicznie dostępne informacje, które możemy wykorzystać, aby ustalić, w jaki sposób można to osiągnąć. Kilka artykułów zostało opublikowanych przez Shree K. Nayara z Uniwersytetu Columbia (z których jeden współpracował z Tomoo Mitsunagą z Sony), które zawierają różne sposoby wykorzystania ekspozycji zróżnicowanej przestrzennie i różne układy, które mogą to osiągnąć. Poniżej znajduje się przykład układu z czterema poziomami ekspozycji na czujniku obrazu RGBG. Ten układ twierdzi, że jest w stanie uzyskać pojedyncze przechwytywanie obrazów HDR w pełnej rozdzielczości przy zaledwie około 20% utrata rozdzielczości przestrzennej w zależności od scenariusza (to samo osiągnięcie, o którym twierdzi Sony MŚP-HDR).

Firma Sony zastosowała już technologię SME-HDR w kilku przetwornikach obrazu, w tym w modelu IMX214, który ostatnio zyskał dużą popularność (wykorzystywany w Asusa Zenfone3 Laser, Moto Z, oraz Wydajność Xperii X), ale jest nowym dodatkiem do IMX378 w porównaniu do IMX377, który był używany w zeszłym roku. Umożliwia czujnikowi kamery wysyłanie sygnału wideo zarówno w pełnej rozdzielczości 10 bitów, jak i wideo 4K przy 60 Hz z aktywną funkcją SME-HDR. Chociaż wąskie gardło w innym miejscu procesu spowoduje niższy limit, jest to fantastyczna poprawa w stosunku do możliwości IMX377 i jest oznaką dobrych rzeczy w przyszłości.

Jednym z największych ulepszeń IMX378 w porównaniu z IMX377 jest to, że jest on w stanie obsłużyć większą część przetwarzania obrazu na chipie, redukując obciążenie pracą dostawcy usług internetowych (chociaż dostawca usług internetowych nadal może zażądać danych obrazu RAW, w zależności od tego, w jaki sposób producent OEM zdecyduje się wykorzystać czujnik). Może obsłużyć wiele drobnych rzeczy, takich jak lokalna korekta defektów i tworzenie kopii lustrzanych, ale co ważniejsze, radzi sobie również z BME-HDR lub SME-HDR bez konieczności angażowania dostawcy usług internetowych. Może to potencjalnie stanowić zasadniczą różnicę w przyszłości, uwalniając pewne obciążenie dostawcy usług internetowych w przypadku przyszłych telefonów.

Jeszcze raz chcielibyśmy podziękować firmie Sony za wszelką pomoc przy tworzeniu tego artykułu. Naprawdę doceniamy wysiłki, jakie Sony włożyło w zapewnienie dokładności i głębi tego filmu funkcję, zwłaszcza pozwalającą nam odkryć wcześniej niepublikowane informacje na temat IMX378.

Biorąc to pod uwagę, naprawdę szkoda, że dostęp do niektórych informacji, nawet podstawowych informacji o produkcie, jest tak trudny. Kiedy firmy próbują umieszczać informacje na swoich stronach internetowych, często mogą one być raczej niedostępne i niekompletne po części dlatego, że często jest ona traktowana jako drugorzędna troska pracowników firmy, którzy są bardziej skupieni na swoich głównych praca. Jedna oddana osoba zajmująca się public relations może zdziałać ogromne zmiany w zakresie przekazywania tego typu informacji dostępne dla ogółu społeczeństwa i widzimy, że niektórzy ludzie próbują to robić za darmo czas. Nawet na Sony Exmor Sam artykuł w Wikipedii, w którym w ciągu kilku miesięcy jedna osoba w wolnym czasie położyła większość fundamentów, aby przenieść go z niemal bezużytecznego Artykuł o długości 1715 bajtów to było w większości takie samo od lat, w artykule o wielkości około 50 000 bajtów, który widzimy tam dzisiaj z 185 różnymi redaktorami. Artykuł będący prawdopodobnie najlepszym repozytorium informacji na temat linii sensorów Sony Exmor dostępnych w sieci, a bardzo podobny schemat widzimy w innych artykułach. Pojedynczy oddany autor może znacząco zmienić łatwość, z jaką klienci mogą porównywać różne produkty produktów oraz stopień wyedukowania zainteresowanych konsumentów na ten temat, co może mieć daleko idące skutki efekty. Ale to temat na inny raz.

Jak zawsze zastanawiamy się, jak te zmiany sprzętowe wpłyną na same urządzenia. Całkiem jasne, że nie otrzymamy wideo HDR w rozdzielczości 4K 60 Hz (i być może w ogóle nie otrzymamy wideo HDR, ponieważ Google jeszcze o tym nie wspomniał), ale szybsza pełna rozdzielczość fotografowanie prawdopodobnie znacznie pomoże w HDR+, a my zobaczymy, że ulepszenia nowszego czujnika zostaną wprowadzone do telefonu na inne podobne, drobne, ale istotne sposoby również.

Podczas gdy DXOMark wymienia Pixel jako działające nieco lepiej niż Samsungi Galaxy S7 i HTC 10, wiele czynników, które zapewniły telefonom Pixel tak małą przewagę, to główne oprogramowanie ulepszenia, takie jak HDR+ (który daje absolutnie fantastyczne rezultaty, czemu DXOMark poświęcił całą sekcję swojej recenzji) i specjalny EIS Google system (który może współpracować z OIS), który próbkuje żyroskop 200 razy na sekundę, aby zapewnić jedną z najlepszych elektronicznej stabilizacji obrazu, jaką kiedykolwiek widzieliśmy widziany. Tak, telefony Pixel mają świetny aparat, ale czy mogłyby być jeszcze lepsze po dodaniu OIS i Dual Pixel PDAF? Absolutnie.

Nie zrozumcie mnie źle, jak mówiłem, telefony Pixel mają absolutnie oszałamiający aparat, ale nie można mnie winić za to, że chcę więcej, zwłaszcza kiedy droga do tych ulepszeń jest tak jasna (i kiedy ceny telefonów są wyceniane na poziomie pełnych cen flagowców, gdzie można spodziewać się tego, co najlepsze to, co najlepsze). Zawsze będzie część mnie, która będzie chciała więcej, lepszej żywotności baterii, szybszych procesorów, lepszej żywotności baterii, jaśniejszych i żywsze ekrany, głośniejsze głośniki, lepsze aparaty, więcej pamięci, lepsza żywotność baterii i, co najważniejsze, lepsza żywotność baterii (Ponownie). Biorąc to pod uwagę, telefony Pixel mają wiele małych, fantastycznych funkcji, które można połączyć, tworząc naprawdę obiecujące urządzenie, co z radością widzę.