Entramos em contato com a Sony para tentar saber um pouco mais sobre o sensor IMX378 usado pelos próximos telefones Google Pixel e Pixel XL. Aprenda tudo sobre isso!

Visão geral do IMX378

Entramos em contato com a Sony para tentar saber um pouco mais sobre o sensor IMX378 que será usado pelo próximo Google Pixel e PixelXL telefones, bem como pelo Xiaomi Mi 5S. Infelizmente, a Sony ainda não conseguiu distribuir a ficha técnica do sensor Exmor RS IMX378, mas eles foram extremamente úteis e foram capazes de nos fornecer algumas informações inéditas sobre o IMX378.

Em primeiro lugar, o próprio nome estava errado. Apesar dos rumores de que faria parte do Exmor R linha de sensores CMOS Backside Illuminated (BSI), como o IMX377 anterior, que foi usado no Nexus 5X e Nexus 6P, nosso contato na Sony nos informou que o IMX378 será considerado parte do produto da Sony Exmor RS linha de sensores Stacked BSI CMOS.

Embora muitas coisas tenham permanecido as mesmas do IMX377 ao IMX378, incluindo o tamanho do pixel (1,55 μm) e o tamanho do sensor (7,81 mm), alguns recursos principais foram adicionados. Ou seja, agora é um design BSI CMOS empilhado, possui PDAF, adiciona a tecnologia SME-HDR da Sony e possui melhor suporte para vídeo com alta taxa de quadros (câmera lenta).

CMOS BSI empilhados

A iluminação traseira por si só é um recurso extremamente útil que se tornou quase padrão nos principais smartphones nos últimos anos, começando com o HTC Evo 4G em 2010. Ele permite que a câmera capture substancialmente mais luz (ao custo de mais ruído), movendo alguns dos a estrutura que tradicionalmente ficava na frente do fotodiodo nos sensores iluminados frontais, atrás isto.

Surpreendentemente, ao contrário da maioria das tecnologias de câmera, a iluminação traseira começou a aparecer originalmente em telefones antes das DSLRs, em grande parte devido às dificuldades com a criação de sensores BSI maiores. O primeiro sensor BSI APS-C foi o Samsung S5KVB2 que foi encontrado em sua câmera NX1 de 2014, e o primeiro sensor full-frame foi o Sony Exmor R IMX251 que foi encontrado no Sony α7R II do último ano.

A tecnologia Stacked BSI CMOS vai um passo além, movendo mais circuitos da camada frontal para o substrato de suporte atrás dos fotodiodos. Isto não só permite à Sony reduzir substancialmente o tamanho do sensor de imagem (permitindo sensores maiores na mesma área), mas também permite à Sony imprimir os pixels e circuitos separadamente (mesmo em diferentes processos de fabricação), reduzindo o risco de defeitos, melhorando os rendimentos e permitindo uma maior especialização entre os fotodiodos e o suporte circuitos.

PDAF

O IMX378 adiciona foco automático com detecção de fase, que os telefones Nexus do ano passado e o IMX377 não suportavam. Ele permite que a câmera use efetivamente as diferenças na intensidade da luz entre diferentes pontos do sensor para identificar se o objeto que a câmera está tentando focar estiver na frente ou atrás do ponto de foco e ajuste o sensor de acordo. Esta é uma grande melhoria em termos de velocidade e precisão em relação ao foco automático tradicional baseado em contraste que vimos em muitas câmeras no passado. Como resultado, vimos uma explosão absoluta de telefones usando PDAF, e isso se tornou uma grande palavra de marketing que é considerada uma peça central do marketing de câmeras em toda a indústria.

O IMX378 adiciona foco automático com detecção de fase, que os telefones Nexus do ano passado e o IMX377 não suportavam. Ele permite que a câmera use efetivamente as diferenças na intensidade da luz entre diferentes pontos do sensor para identificar se o objeto que a câmera está tentando focar estiver na frente ou atrás do ponto de foco e ajuste o sensor de acordo. Esta é uma grande melhoria em termos de velocidade e precisão em relação ao foco automático tradicional baseado em contraste que vimos em muitas câmeras no passado. Como resultado, vimos uma explosão absoluta de telefones usando PDAF, e isso se tornou uma grande palavra de marketing que é considerada uma peça central do marketing de câmeras em toda a indústria.

Embora não seja tão rápido de focar quanto o Fotodiodo Duplo PDAF que o Samsung Galaxy S7 tem (também conhecido como “PDAF de pixel duplo” e “Foco automático Duo Pixel”), que permite que cada pixel seja usado para detecção de fase, incluindo dois fotodiodos por pixel, a fusão de PDAF e foco automático a laser ainda deve ser uma combinação potente.

Alta taxa de quadros

Ultimamente tem-se falado muito sobre câmeras com alta taxa de quadros (tanto para aplicações de consumo quanto para produção cinematográfica profissional). Ser capaz de gravar em taxas de quadros mais altas pode ser usado para criar vídeos incrivelmente suaves em velocidade regular (que pode ser fantástica para esportes e outros cenários de alta velocidade) e para criar alguns realmente vídeos interessantes quando você desacelera tudo.

Infelizmente, é extremamente difícil gravar vídeos com taxas de quadros mais altas, e mesmo quando sua câmera sensor pode gravar em taxas de quadros mais altas, pode ser difícil para o processador de sinal de imagem do telefone manter acima. É por isso que, embora o IMX377 usado no Nexus 5X e 6P pudesse gravar vídeo 720p a 300 Hz e vídeo 1080p a 120 Hz, vimos apenas 120 Hz 720p no Nexus 5X e 240 Hz 720p no 6P. O IMX377 também era capaz de vídeo 4k de 60 Hz, apesar dos dispositivos Nexus serem limitados a 30 Hz.

Os telefones Pixel são capazes de trazer vídeo de até 120 Hz 1080p e vídeo de 240 Hz 720p graças em parte das melhorias relacionadas ao IMX378, que apresenta um aumento nas capacidades de até 240 Hz em 1080p.

O sensor também é capaz de tirar fotos contínuas de resolução total com mais rapidez, aumentando até 60 Hz na saída de 10 bits e 40 Hz na saída de 12 bits. saída (acima de 40 Hz e 35 Hz, respectivamente), o que deve ajudar a reduzir a quantidade de desfoque de movimento e trepidação da câmera ao usar HDR+.

SME-HDR

Tradicionalmente, o HDR para vídeo tem sido uma compensação. Você teve que cortar a taxa de quadros pela metade ou a resolução pela metade. Como resultado, muitos OEMs nem se preocuparam com isso, sendo a Samsung e a Sony entre os poucos que o implementam. Mesmo o Samsung Galaxy Nota 7 está limitado à gravação 1080p 30 Hz devido, em parte, ao alto custo computacional do vídeo HDR.

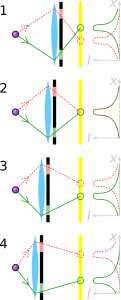

O primeiro dos dois principais métodos tradicionais de vídeo HDR, que a Red Digital Cinema Camera Company chama HDRx e que a Sony chama de Digital Overlap HDR (DOL-HDR), funciona capturando duas imagens consecutivas, uma exposta mais escura e outra mais clara, e mesclando-as para criar um único quadro de vídeo. Embora isso permita manter a resolução total da câmera (e definir diferentes velocidades do obturador para os dois quadros), muitas vezes pode resultar em problemas devido ao intervalo de tempo entre os dois quadros (especialmente com movimentos rápidos). objetos). Além disso, pode ser muito difícil para o processador acompanhar, pois com o DOL-HDR, o ISP do telefone cuida da fusão dos quadros separados.

O outro método tradicional, que a Sony chama de Binning Multiplexed Exposure HDR (BME-HDR), define uma configuração de exposição diferente para cada par de duas linhas de pixels no sensor para criar duas imagens de meia resolução ao mesmo tempo, que são então mescladas em um quadro HDR para o vídeo. Embora este método evite os problemas associados ao HDRx, nomeadamente uma redução na taxa de quadros, ele tem outros problemas, especificamente a redução na resolução e os limites de como a exposição pode ser alterada entre os dois conjuntos de linhas.

A exposição espacialmente multiplexada (SME-HDR) é um novo método que a Sony está usando para permitir a gravação de HDR na resolução total e na taxa de quadros máxima que o sensor é capaz. É uma variante de Exposição espacialmente variável que usa algoritmos proprietários para permitir que a Sony capture as informações dos pixels claros e escuros, que são organizados em um padrão de estilo tabuleiro de xadrez e inferir a imagem de resolução total para a exposição escura e clara imagens.

Infelizmente, a Sony não foi capaz de nos dar explicações mais detalhadas sobre o padrão exato, e talvez nunca consiga divulgá-lo – as empresas tendem a jogar suas cartas muito próximos quando se trata de tecnologia de ponta, como a que vemos em HDR, até mesmo o Google tem seu próprio algoritmo proprietário para fotos HDR conhecido como HDR+. No entanto, ainda existem algumas informações disponíveis publicamente que podemos usar para descobrir como isso pode ser realizado. Alguns artigos foram publicados por Shree K. Nayar da Universidade de Columbia (um dos quais foi em colaboração com Tomoo Mitsunaga da Sony) que contém diferentes maneiras de usar a Exposição Espacialmente Variável e diferentes layouts que podem alcançá-lo. Abaixo está um exemplo de layout com quatro níveis de exposição em um sensor de imagem RGBG. Este layout afirma ser capaz de obter imagens HDR de resolução total de captura única com apenas cerca de 20% perda na resolução espacial, dependendo do cenário (o mesmo feito que a Sony reivindica para PME-HDR).

A Sony já usou SME-HDR em alguns sensores de imagem, inclusive no IMX214, que tem visto muita popularidade ultimamente (sendo usado no Asus Zenfone 3 Laser, o Moto Z, e a Desempenho do Xperia X), mas é uma nova adição ao IMX378 em comparação com o IMX377 usado no ano passado. Ele permite que o sensor da câmera produza resolução total de 10 bits e vídeo 4k a 60 Hz com SME-HDR ativo. Embora um gargalo em outras partes do processo resulte em um limite inferior, esta é uma melhoria fantástica em relação ao que o IMX377 era capaz e é um sinal de que coisas boas estão por vir no futuro.

Uma das grandes melhorias do IMX378 em relação ao IMX377 é que ele é capaz de lidar com mais processamento de imagem no chip, reduzindo a carga de trabalho do ISP (embora o ISP ainda seja capaz de solicitar os dados da imagem RAW, dependendo de como o OEM decidir usar o sensor). Ele pode lidar com muitas pequenas coisas, como correção de defeitos e espelhamento local, mas, mais importante, também pode lidar com BME-HDR ou SME-HDR sem precisar envolver o ISP. Isso poderia ser uma grande diferença no futuro, liberando algumas despesas gerais para o ISP em telefones futuros.

Gostaríamos de agradecer mais uma vez à Sony por toda a ajuda na criação deste artigo. Nós realmente apreciamos o esforço que a Sony fez para ajudar a garantir a precisão e a profundidade deste recurso, especialmente por nos permitir descobrir algumas informações inéditas sobre o IMX378.

Dito isto, é realmente uma pena que seja tão difícil aceder a algumas destas informações, mesmo às informações básicas do produto. Quando as empresas tentam colocar informações nos seus websites, muitas vezes estas podem ser bastante inacessíveis e incompletas, em grande parte parte porque muitas vezes é tratada como uma preocupação secundária dos colaboradores da empresa, que estão mais focados em seus principais trabalhar. Uma pessoa dedicada a lidar com relações públicas pode fazer uma enorme diferença em termos de tornar este tipo de informação disponível e acessível ao público em geral, e estamos vendo algumas pessoas tentando fazer exatamente isso em seu acesso gratuito. tempo. Mesmo no Sony Exmor O próprio artigo da Wikipedia, onde ao longo de alguns meses uma única pessoa em seu tempo livre lançou a maior parte das bases para retirá-lo de um ambiente quase inútil Artigo de 1.715 bytes isso tem sido praticamente o mesmo há anos, no artigo de aproximadamente 50.000 bytes que vemos lá hoje com 185 editores distintos. Um artigo que é sem dúvida o melhor repositório de informações sobre a linha de sensores Sony Exmor disponível online, e podemos ver um padrão muito semelhante em outros artigos. Um único redator dedicado pode fazer uma diferença substancial na facilidade com que os clientes podem comparar diferentes produtos e na forma como os consumidores interessados são informados sobre o assunto, o que pode ter consequências de longo alcance. efeitos. Mas isso é assunto para outra hora.

Como sempre, ficamos nos perguntando como essas mudanças de hardware afetarão os próprios dispositivos. Claramente não obteremos vídeo HDR de 4k 60 Hz (e podemos não obter vídeo HDR, já que o Google ainda não mencionou isso), mas a resolução total mais rápida fotografar provavelmente ajudará substancialmente com HDR +, e veremos as melhorias do sensor mais recente chegando ao telefone de outras maneiras semelhantes, pequenas, mas substanciais também.

Enquanto o DXOMark lista o Pixel telefones com desempenho um pouco melhor do que o Samsung Galaxy S7 e HTC 10, muitas das coisas que deram aos telefones Pixel essa pequena vantagem foram softwares importantes melhorias como HDR+ (que produz resultados absolutamente fantásticos e ao qual o DXOMark dedicou uma seção inteira de sua análise) e EIS especial do Google sistema (que pode funcionar em conjunto com o OIS) que faz amostras do giroscópio 200 vezes por segundo para fornecer uma das melhores estabilizações eletrônicas de imagem que já tivemos visto. Sim, os telefones Pixel têm uma ótima câmera, mas poderiam ter sido ainda melhores com OIS e Dual Pixel PDAF adicionados? Absolutamente.

Não me interpretem mal, como eu disse, os telefones Pixel têm uma câmera absolutamente deslumbrante, mas você não pode me culpar por querer mais, especialmente quando o caminho para essas melhorias é tão claro (e quando os telefones custam o preço principal completo, onde você espera o melhor do melhor). Sempre haverá uma parte de mim que quer mais, que quer melhor duração da bateria, processadores mais rápidos, melhor duração da bateria, mais brilho e telas mais vívidas, alto-falantes mais altos, melhores câmeras, mais armazenamento, melhor duração da bateria e, o mais importante, melhor duração da bateria (de novo). Dito isto, os telefones Pixel têm muitos pequenos recursos fantásticos que poderiam ser combinados para criar um dispositivo verdadeiramente promissor, que estou animado em ver.