Tijdens het kijken de WWDC21-keynote een paar weken geleden begon ik een terugkerend thema op te merken. En dat thema is dat verschillende van de aankomende iOS 15-functies lijken te profiteren van de Neural Engine van de iPhone.

De Neural Engine zit al in de iPhone sinds de release van de iPhone X in 2017. Ik denk echter niet dat de meesten van ons de effecten van deze processor hebben gevoeld in de vier jaar sinds de eerste release.

WWDC21 bleef me het gevoel geven dat iOS 15 de eerste futuristische iOS-update in lange tijd is. En hoewel er geen officiële bevestiging van Apple hierover is, denk ik dat dat komt omdat Apple eindelijk volledig gebruik maakt van de Neural Engine.

In dit bericht zal ik kort bespreken wat de Neural Engine is, en daarna duik ik in alle nieuwe iOS 15-functies die deze processor volledig lijken te gebruiken. Tegen het einde zal ik de belangrijkste manieren bespreken waarop iOS momenteel de Neural Engine gebruikt, zodat je het kunt vergelijken met de aankomende iOS 15-release.

Oké, laten we er in gaan!

Inhoud

- Wat is de Neural Engine op de iPhone?

-

Hoe iOS 15-functies beginnen te profiteren van de neurale motor

- Je iPhone kan tekst in je foto's lezen

- Met iOS 15-functies kan uw iPhone inhoud in uw foto's herkennen en identificeren

- Herinneringen in foto's zullen verfijnder en "echt" aanvoelen

- Meldingen, widgets en Niet storen worden slimmer

- Nieuwe iOS 15-functies maken het gemakkelijker om een routebeschrijving te krijgen met je camera

- Siri zal meer verwerken op je apparaat

-

Wat kan de Neural Engine doen zonder de aankomende iOS 15-functies?

- De Neural Engine helpt je om betere foto's te maken

- Machine learning maakt FaceID snel, veilig en adaptief

- De Neural Engine speelt een sleutelrol in AR-ervaringen op iPhone

-

De komende iOS 15-functies wijzen op een slimmere toekomst voor iPhone

- Gerelateerde berichten:

Wat is de Neural Engine op de iPhone?

De Neural Engine is een processor op iPhone X en later die machine learning-bewerkingen afhandelt. Het is het vermogen van deze processor om machine learning aan te drijven dat het zo belangrijk maakt, dus het begrijpen van machine learning is belangrijk om deze processor te begrijpen.

Machine learning verwijst naar software die onafhankelijk van een programmeur beslissingen neemt over welke code moet worden uitgevoerd.

Meestal moet software werken met zeer specifieke en gecontroleerde gegevens. Dat is de reden waarom Siri je bedoeling met de ene zin begrijpt, maar het niet begrijpt met een andere - zelfs als de bedoeling in elke zin identiek is. Siri heeft de gegevens nodig om in een specifieke structuur te komen, anders mislukt het.

Machine learning is een manier om dat te veranderen. Hiermee kan software minder gestructureerde gegevens opnemen en toch verwerken. Als je ooit verbaasd bent dat Siri een vreemd geformuleerd verzoek begreep, komt dat waarschijnlijk omdat Siri's machine learning-mogelijkheden zijn verbeterd.

De Neural Engine is, zoals de naam al aangeeft, de engine op je telefoon die dit mogelijk maakt.

Ik realiseer me dat deze concepten een beetje moeilijk te begrijpen kunnen zijn, en ik weet dat ik er misschien niet zo goed in ben om ze uit te leggen. Ik probeer het kort en eenvoudig te houden voor dit bericht, maar als je een diepere duik wilt, moet je eens kijken deze post!

Hoe iOS 15-functies beginnen te profiteren van de neurale motor

Het probleem met de Neural Engine van de iPhone is niet dat hij niet krachtig is, maar dat zijn kracht niet volledig wordt benut op de iPhone. De afgelopen vier jaar is het in beperkte gevallen aan het werk gezet, zoals augmented reality. Het is handig, maar het heeft de iPhone nog niet gerevolutioneerd.

Ik denk dat verschillende iOS 15-functies wijzen op een meer revolutionaire toekomst voor de Neural Engine. Ik denk niet dat een van de nieuwe functies die ik hieronder ga bespreken, mogelijk zou zijn zonder deze processor. Laten we dus eens kijken hoe deze functies de Neural Engine optimaal gebruiken.

Je iPhone kan tekst in je foto's lezen

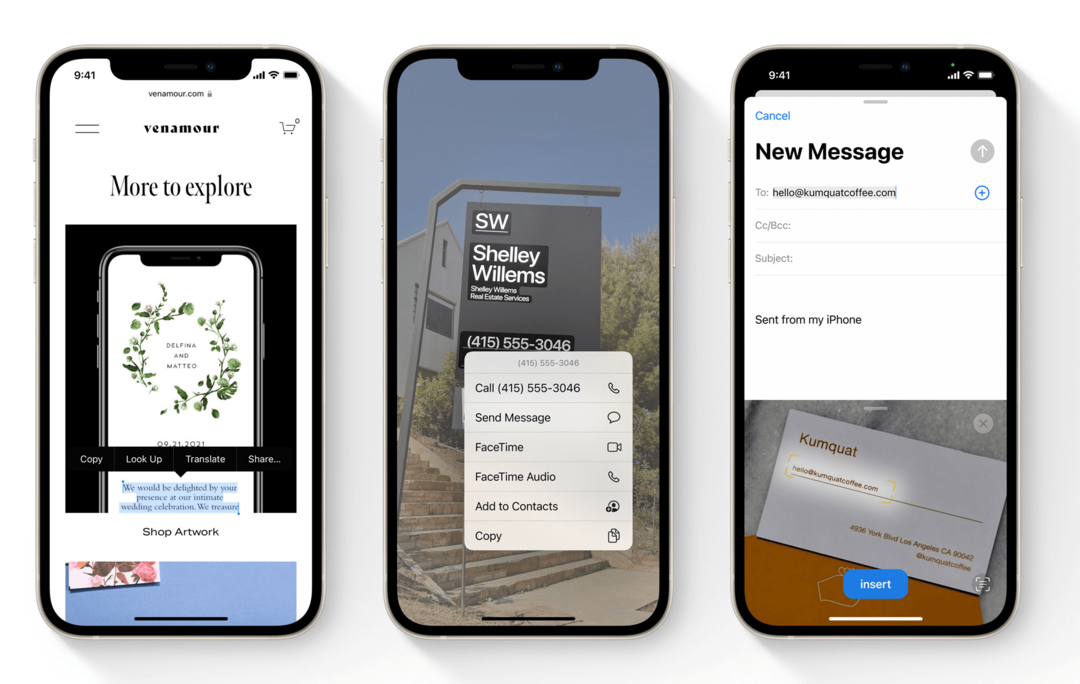

De eerste van de iOS 15-functies die schreeuwde "Machine Learning!" voor mij was Live Text. Live-tekst is een functie in iOS 15 waarmee uw iPhone tekst in uw Foto's-app kan lezen.

Dat betekent dat je een foto kunt maken van alles met gedrukte tekst erop, die foto in de Foto's-app kunt openen en met die tekst kunt communiceren. U kunt op telefoonnummers in foto's tikken, tekst uit afbeeldingen van documenten kopiëren en plakken en de zoekbalk in Foto's gebruiken om naar tekst in foto's te zoeken.

Met deze functie kan uw iPhone ook handschrift in uw foto's lezen. Het werkt ook met de Camera-app, zodat u in realtime kunt communiceren met tekst in de zoeker van uw iPhone-camera.

Zonder machine learning zou een functie als deze bijna onmogelijk zijn. Daarom gebruiken die online beveiligingstests vervormde tekst om te bewijzen dat je geen robot bent. Omdat het voor een programma een uitdaging is om tekst te kunnen lezen.

Niet alleen is een smartphonefunctie die tekst kan lezen, ongeacht lettertype, stijl, kleur of hoek, in realtime buitengewoon nuttig, het is ook een uitstekend gebruik van mobiele machine learning.

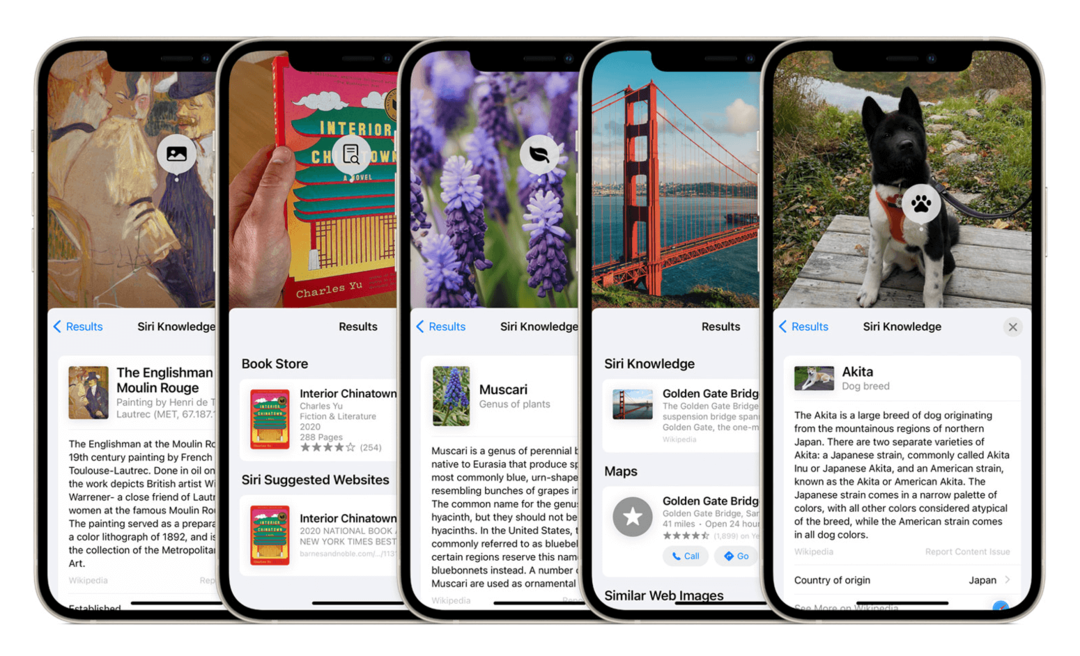

Met iOS 15-functies kan uw iPhone inhoud in uw foto's herkennen en identificeren

Een andere van de nieuwe iOS 15-functies die de Neural Engine gebruikt, is objectherkenning in Foto's. Deze functie werkt op dezelfde manier als Live-tekst, behalve dat het objecten herkent in plaats van tekst. Het voorbeeld dat Apple gebruikte, is dat je je iPhone-camera op een hond kunt richten, en je iPhone zal niet alleen herkennen dat het een hond is, maar ook welk hondenras het is.

De iPhone is al een tijdje in staat om gezichten uit je foto's te halen, wat een vorm van objectherkenning is, zij het beperkt. Door deze uitbreiding van die mogelijkheid kan uw iPhone snel kijken naar de ongestructureerde gegevens van een foto en identiteitsobjecten erin.

Dit is indrukwekkender (en moeilijker) dan Live Text, omdat de patronen waar de Neural Engine naar moet zoeken veel minder consistent zullen zijn. Je iPhone zal duizenden (zo niet honderdduizenden) beslissingen moeten nemen om dergelijke beslissingen te kunnen nemen.

Om een hondenras te identificeren, moet hij eerst zien dat een hond een ander object is dan de achtergrond, dan moet hij grenzen trekken rond die hond en dan kies verschillende kenmerken van die hond totdat hij kan bepalen dat het een hond is, en trek er dan nog meer kenmerken uit om te bepalen welk soort hond het is is.

Dat soort computergebruik is alleen mogelijk met een machine learning-processor.

Herinneringen in foto's zullen verfijnder en "echt" aanvoelen

Een andere functie in de Foto's-app die een Neural Engine-retouchering gaat krijgen, is Memories.

Deze functie maakt foto's van een bepaalde tijd (meestal een specifieke dag) en combineert ze in een korte video die u kunt bekijken. Het idee is dat Memories automatisch videocollages maakt van uw vakanties, feesten, jubilea en meer.

Herinneringen zijn een van de andere iOS 15-functies die een aanzienlijke verbetering van de kwaliteit krijgen. Het zal automatisch muziek uit je Apple Music-bibliotheek opnemen in je Herinneringen.

De muziek die Foto's kiest, past niet alleen in het juiste tempo bij de video, maar moet ook passen bij de inhoud van de video. Afbeeldingen van een feest moeten bijvoorbeeld gepaard gaan met energieke muziek, terwijl meer doordachte foto's langzamere muziek moeten bevatten.

Hoewel ik deze functie niet vaak gebruik, is de informatica erachter buitengewoon fascinerend. Het combineert object- en landschapsherkenning, groepeert foto's op basis van inhoud, locatie en tijdsperiode, scheidt gemiddelde foto's van dag tot dag van foto's die verband houden met een speciaal leven evenementen, legt een verband tussen de sfeer van die foto's en de sfeer van een nummer dat je leuk vindt, koppelt ze in een diavoorstelling en keert die presentatie op het ritme van de muziek.

Memories heeft altijd de Neural Engine gebruikt. En de volgende versie van iOS zal de intelligentie van deze functie aanzienlijk vergroten.

Meldingen, widgets en Niet storen worden slimmer

Een groep iOS 15-functies die meer voordeel halen uit de Neural Engine zijn meldingen, widgets en Niet storen.

Widgets begonnen machine learning te gebruiken in iOS 14, maar ik dacht dat het handig zou zijn om ze hier toe te voegen. Met Smart Stacks kun je widgets op elkaar plaatsen. Je iPhone bladert er dan de hele dag door door en laat je zien wat volgens hem op elk moment de meest relevante widget is.

Dit soort beslissingen worden genomen door uw gedrag op verschillende tijdstippen van de dag en na het gebruik van bepaalde apps te analyseren. De Neural Engine neemt deze gegevens, interpreteert deze en geeft vervolgens uw widgets weer op basis van deze gegevens.

Nieuwe iOS 15-functies zullen op dezelfde manier werken.

Meldingen worden nu gegroepeerd in een meldingsoverzicht, zodat je niet de hele dag minder belangrijke meldingen op je vergrendelscherm ziet staan. U kunt de functie Meldingsoverzicht aanpassen of de Neural Engine dit voor u laten afhandelen.

Niet storen krijgt een nieuwe component, Focus, die bepaalde meldingen verbergt op basis van hoe ze zijn gecategoriseerd. Je kunt Focus handmatig beheren of het zichzelf intelligent laten beheren.

Alle drie deze functies zullen extreem vergelijkbare machine learning-statistieken gebruiken om uw gedrag te voorspellen en aan te passen.

Nieuwe iOS 15-functies maken het gemakkelijker om een routebeschrijving te krijgen met je camera

Dit is een van de iOS 15-functies waar ik nog niet zoveel opwinding over heb gehoord als ik had verwacht. Ik vind het nog steeds erg interessant, vooral in een machine learning-context.

In Kaarten in iOS 15 kun je je camera richten terwijl je loopt. Hiermee kunt u AR-richtingen zien die op uw omgeving worden geprojecteerd. Stel dat u naar de film probeert te gaan en niet zeker weet welke weg u moet nemen. Je kunt met je iPhone rondkijken en aanwijzingen zien die zijn gemarkeerd in de straten en gebouwen om je heen.

Augmented Reality op iPhone werd mogelijk gemaakt door de toevoeging van de Neural Engine, dus deze functie dankt zijn oorsprong aan machine learning. Maar deze functie combineert AR ook met beeldherkenning en locatiedetectie om een ongelooflijke realtime ervaring te bieden.

Hoewel het bij de lancering slechts in een paar steden beschikbaar zal zijn, wijst deze functie op een toekomst waarin machine learning op de iPhone je niet alleen op de achtergrond helpt. Het zal je kunnen helpen om dingen direct te bereiken die buiten je comfortzone of vermogen liggen.

Siri zal meer verwerken op je apparaat

De laatste van de iOS 15-functies die meer voordeel halen uit de Neural Engine, is Siri. Siri heeft altijd machine learning gebruikt. Maar dat leren heeft het potentieel van de Neural Engine nog niet maximaal benut.

Dat komt omdat Siri verwerking buiten het apparaat heeft gebruikt. Dat betekent dat je iPhone naar je verzoek luistert, het naar een Apple-server stuurt die het verzoek verwerkt en het vervolgens terugstuurt naar Siri op je iPhone om op dat verzoek te reageren.

De reden dat dit werd gedaan, was om de kracht van Siri te vergroten tot meer dan de iPhone kon ondersteunen. In iOS 15 gaat dit echter veranderen. Siri zal nu het grootste deel van de verwerking op je iPhone doen. Dat zou Siri sneller, slimmer en betrouwbaarder moeten maken.

Ik denk dat deze update waarschijnlijk de minste hulp van de Neural Engine nodig heeft. Vandaar de plaatsing aan het einde van de lijst. Het is echter vermeldenswaard, omdat het erop wijst dat Siri slimmer wordt. Een meer capabele assistent die de hardware op de iPhone gebruikt, geen verre server.

Wat kan de Neural Engine doen zonder de aankomende iOS 15-functies?

En dat is het! Voor zover ik weet, zijn dat alle nieuwe manieren waarop iOS 15-functies de brute kracht van de Neural Engine gaan gebruiken.

Ik wilde aan het einde van dit bericht een korte sectie opnemen waarin enkele dingen worden benadrukt die de Neural Engine al op je iPhone doet. Op die manier kunt u vergelijken waar het nu is met waar het over een paar maanden zal zijn.

Hopelijk helpt dit je de aanstaande wijzigingen in iOS in een nieuw licht te waarderen en beter te begrijpen hoe functies zoals deze naar je iPhone komen.

De Neural Engine helpt je om betere foto's te maken

Ik zou zeggen dat het grootste gebruik van de Neural Engine op de iPhone sinds 2017 in fotografie is geweest. Elk jaar laat Apple zien hoe de nieuwste iPhone meer fotografische berekeningen kan uitvoeren dan de vorige generatie. Apple zegt dingen als: "De beeldprocessor maakt X miljoen berekeningen/beslissingen per foto".

Dit verwijst naar het aantal berekeningen dat de Neural Engine maakt wanneer u een foto maakt. Het kijkt naar de kleuren, belichting, contrasterende elementen, onderwerp, achtergrond en tal van andere factoren. En het bepaalt in een oogwenk hoe u al deze elementen het beste kunt sorteren, aanpassen, absorberen en balanceren.

Het is dit machine-leerproces dat dingen als portretmodus en diepe fusie mogelijk heeft gemaakt. De portretmodus kan je isoleren van je achtergrond en Deep Fusion heeft nachtfotografie op de iPhone aanzienlijk beter gemaakt dan voorheen.

De Neural Engine is van cruciaal belang voor de camera van uw iPhone vanwege hardwarebeperkingen. Vanwege de grootte van de iPhone zijn de camera en de lenzen beperkt in capaciteit. Het is het computergebruik en machine learning dat plaatsvindt wanneer je een foto maakt, waardoor je iPhone-fotografie op één lijn komt met foto's van een professionele DSLR.

Machine learning maakt FaceID snel, veilig en adaptief

Natuurlijk kunnen we niet over de Neural Engine praten zonder te vermelden waarom deze is gemaakt.

Dat klopt - de Neural Engine is toegevoegd aan de iPhone X om FaceID mogelijk te maken. Voor het geval je het nog niet wist, FaceID is een van de meest geavanceerde en complexe functies van je iPhone.

FaceID vergelijkt niet alleen het 2D-beeld van je gezicht in de selfiecamera met een ander 2D-beeld van je gezicht. Het kijkt naar een 3D-kaart van uw gezicht, volgt uw oogbewegingen en vergelijkt deze met een eerdere 3D-scan van uw gezicht.

FaceID doet dit niet alleen in minder dan twee seconden terwijl uw gezicht in beweging is, gedeeltelijk verduisterd en onder verschillende hoeken. Het past zich ook aan de manier waarop uw gezicht van dag tot dag subtiel verandert. Daarom kun je een baard laten groeien, ouder worden en op andere subtiele manieren veranderen zonder dat je je gezicht opnieuw hoeft te scannen.

FaceID en de Neural Engine bestuderen en leren van je gezicht elke keer dat je je iPhone ontgrendelt. Zonder de Neural Engine zou FaceID niet half zo snel, veilig of betrouwbaar zijn als het nu is.

De Neural Engine speelt een sleutelrol in AR-ervaringen op iPhone

Ten slotte speelt de Neural Engine een sleutelrol in AR op iPhone. Voor degenen die het niet weten, Augmented Reality (AR) is een functie die 3D-modellen op uw omgeving projecteert via de zoeker van uw iPhone-camera. Je kunt dit zelf testen met de Meet app op je iPhone.

Dit soort functies combineert zaken als beeldherkenning, ruimtelijk inzicht en geheugen. Dit alles vereist de kracht die de Neural Engine naar de tafel brengt.

Gelukkig zijn veel van de nieuwe iOS 15-functies ingesteld om AR op iPhone nog krachtiger te maken. Het is een trend waarvan ik hoop dat deze zich voortzet, omdat ik denk dat AR het potentieel heeft om een van de meest integrale functies van mobiele apparaten te worden.

De komende iOS 15-functies wijzen op een slimmere toekomst voor iPhone

Over het algemeen ben ik erg enthousiast over de toekomst waar deze iOS 15-functies ons een glimp van geven. Er zijn verschillende facetten van de iPhone die een beetje onderbenut aanvoelen, maar minder dan de Neural Engine is geweest. Ik kijk uit naar deze verandering, en ik hoop dat jij dat ook doet!

Voor meer nieuws, inzichten en tips over alles wat met Apple te maken heeft, bekijk de rest van de AppleToolBox-blog!