Mens du ser på WWDC21 keynote for noen uker siden begynte jeg å legge merke til et tilbakevendende tema. Og det temaet er at flere av de kommende iOS 15-funksjonene ser ut til å utnytte iPhones nevrale motor.

Neural Engine har vært i iPhone siden lanseringen av iPhone X i 2017. Jeg tror imidlertid ikke de fleste av oss har følt effekten av denne prosessoren i det hele tatt i løpet av de fire årene siden den første utgivelsen.

WWDC21 ga meg stadig følelsen av at iOS 15 er den første futuristiske iOS-oppdateringen på lenge. Og selv om det ikke er en offisiell bekreftelse fra Apple på dette, tror jeg det er fordi Apple endelig drar full nytte av Neural Engine.

I dette innlegget vil jeg kort dekke hva Neural Engine er, så vil jeg dykke ned i alle de nye iOS 15-funksjonene som ser ut til å bruke denne prosessoren til sitt fulle potensial. Mot slutten vil jeg dekke de viktigste måtene iOS for øyeblikket bruker Neural Engine, slik at du kan sammenligne den med den kommende iOS 15-utgivelsen.

Ok, la oss komme inn i det!

Innhold

- Hva er den nevrale motoren på iPhone?

-

Hvordan iOS 15-funksjoner begynner å dra nytte av den nevrale motoren

- iPhone kan lese tekst i bildene dine

- iOS 15-funksjoner lar iPhone gjenkjenne og identifisere innhold i bildene dine

- Minner i Bilder kommer til å være mer sofistikerte og "ekte" følelse

- Varsler, widgeter og Ikke forstyrr blir smartere

- Nye iOS 15-funksjoner vil gjøre det enklere å få veibeskrivelse med kameraet ditt

- Siri vil gjøre mer behandling på enheten din

-

Hva kan Neural Engine gjøre uten de kommende iOS 15-funksjonene?

- Neural Engine hjelper deg å ta bedre bilder

- Maskinlæring gjør FaceID raskt, sikkert og tilpasningsdyktig

- Neural Engine spiller en nøkkelrolle i AR-opplevelser på iPhone

-

De kommende iOS 15-funksjonene peker mot en smartere fremtid for iPhone

- Relaterte innlegg:

Hva er den nevrale motoren på iPhone?

Neural Engine er en prosessor på iPhone X og nyere som håndterer maskinlæringsoperasjoner. Det er denne prosessorens evne til å drive maskinlæring som gjør det så viktig, så det er viktig å forstå maskinlæring for å forstå denne prosessoren.

Maskinlæring refererer til programvare som tar beslutninger om hvilken kode som skal kjøres uavhengig av en programmerer.

Vanligvis må programvare fungere med svært spesifikke og kontrollerte data. Det er derfor Siri vil forstå intensjonen din med én setning, men ikke forstå den med en annen – selv om intensjonen i hver setning er identisk. Siri trenger at dataene kommer i en bestemt struktur, ellers mislykkes de.

Maskinlæring er en måte å endre det på. Det lar programvare ta inn mindre strukturerte data og fortsatt behandle dem. Hvis du noen gang blir overrasket over at Siri forsto en merkelig formulert forespørsel, er det sannsynligvis fordi Siris maskinlæringsevner har blitt bedre.

Neural Engine er, som navnet tilsier, motoren på telefonen din som gjør dette mulig.

Jeg innser at disse konseptene kan være litt vanskelige å forstå, og jeg vet at jeg kanskje ikke gjør den beste jobben med å forklare dem. Jeg prøver å holde ting kort og enkelt for dette innlegget, men hvis du vil ha et dypere dykk, bør du sjekke ut denne posten!

Hvordan iOS 15-funksjoner begynner å dra nytte av den nevrale motoren

Problemet med iPhones nevrale motor er ikke at den ikke er kraftig, men at kraften ikke utnyttes fullt ut på iPhone. De siste fire årene har det blitt satt i gang i begrensede tilfeller, som utvidet virkelighet. Det er nyttig, men det har ikke revolusjonert iPhone ennå.

Jeg tror flere iOS 15-funksjoner peker mot en mer revolusjonerende fremtid for Neural Engine. Jeg tror ikke noen av de nye funksjonene jeg er i ferd med å bryte ned nedenfor ville vært mulig uten denne prosessoren. Så la oss se hvordan disse funksjonene bruker Neural Engine til det fulle.

iPhone kan lese tekst i bildene dine

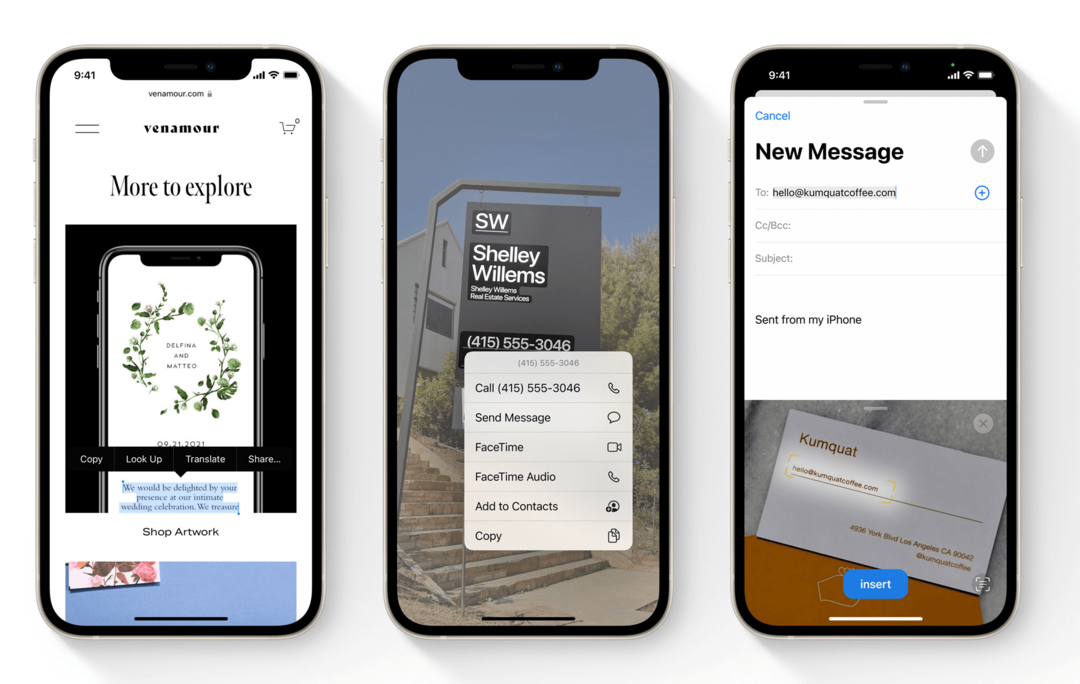

Den første av iOS 15-funksjonene som ropte "Machine Learning!" for meg var Live Text. Live Text er en funksjon i iOS 15 som gjør at iPhone kan lese tekst i Photos-appen.

Det betyr at du kan ta et bilde av hva som helst med trykt tekst på, åpne det bildet i Bilder-appen, og du vil kunne samhandle med den teksten. Du kan trykke på telefonnumre i bilder, kopiere og lime inn tekst fra bilder av dokumenter og bruke søkefeltet i Bilder for å søke etter tekst i bilder.

Denne funksjonen lar også din iPhone lese håndskrift i bildene dine. Den fungerer også med Kamera-appen, slik at du kan samhandle med tekst i iPhone-kameraets søker i sanntid.

Uten maskinlæring ville en funksjon som dette vært nesten umulig. Det er derfor de elektroniske sikkerhetstestene bruker forvrengt tekst for å bevise at du ikke er en robot. Fordi det er utfordrende for et program å kunne lese tekst.

Ikke bare er en smarttelefonfunksjon som kan lese tekst uavhengig av font, stil, farge eller vinkel, i sanntid ekstremt nyttig, den er også en utmerket bruk av mobil maskinlæring.

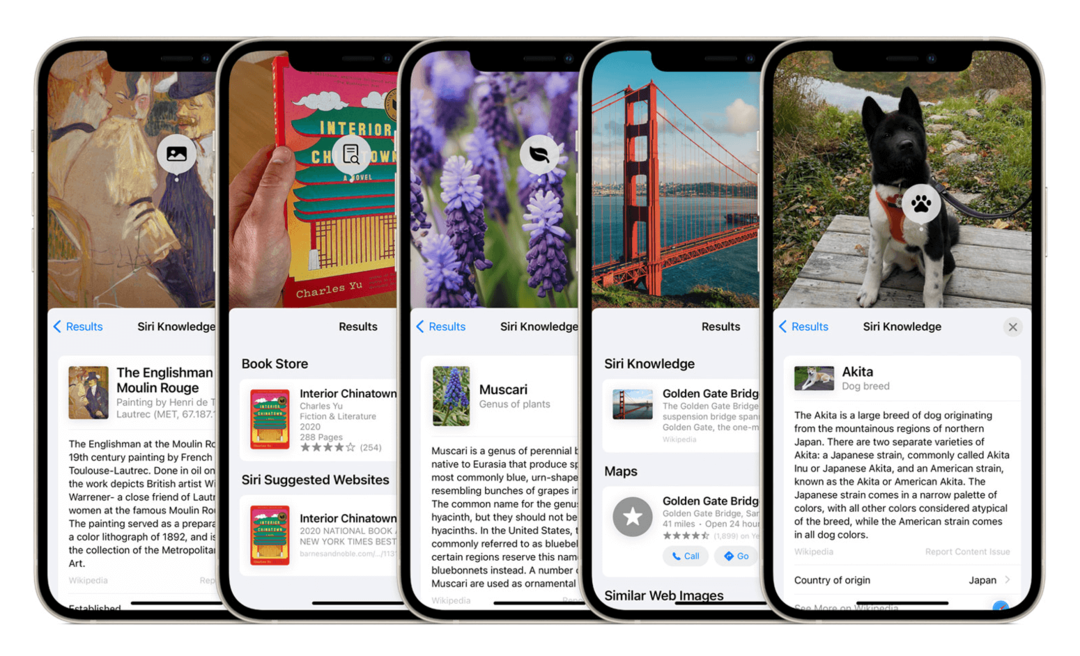

iOS 15-funksjoner lar iPhone gjenkjenne og identifisere innhold i bildene dine

En annen av de nye iOS 15-funksjonene som bruker Neural Engine er objektgjenkjenning i Bilder. Denne funksjonen fungerer på samme måte som Live Text, bortsett fra at den gjenkjenner objekter i stedet for tekst. Eksemplet Apple brukte er at du kan rette iPhone-kameraet ditt mot en hund, og iPhone vil ikke bare gjenkjenne at det er en hund, men også hvilken hunderase det er.

iPhone har vært i stand til å trekke ut ansikter fra bildene dine en stund, noe som er en form for gjenkjenning av objekter, om enn begrenset. Denne utvidelsen av denne muligheten vil tillate din iPhone å raskt se på de ustrukturerte dataene til et bilde og identitetsobjekter i den.

Dette er mer imponerende (og vanskelig) enn Live Text, da mønstrene Neural Engine må se etter kommer til å være langt mindre konsistente. iPhonen din må ta tusenvis (om ikke hundretusenvis) av avgjørelser for å kunne ta slike beslutninger.

For å identifisere en hunderase, må den først se at en hund er et forskjellig objekt fra bakgrunnen, deretter må den trekke grenser rundt den hunden, deretter velg ut distinkte egenskaper til den hunden til den kan fastslå at det er en hund, og trekk ut enda flere egenskaper for å finne ut hvilken type hund den er.

Den typen databehandling er bare mulig med en maskinlæringsprosessor.

Minner i Bilder kommer til å være mer sofistikerte og "ekte" følelse

En annen funksjon i Photos-appen som kommer til å få en Neural Engine-touchup er Memories.

Denne funksjonen tar bilder fra et bestemt tidspunkt (vanligvis en bestemt dag) og kombinerer dem i en kort video som du kan se. Ideen er at Memories automatisk vil lage videokollasjer av ferier, fester, jubileer og mer.

Minner er en annen av iOS 15-funksjonene som får en betydelig stigning i kvaliteten. Den vil automatisk inkludere musikk fra Apple Music-biblioteket i minnene dine.

Musikken som Photos velger vil ikke bare ha riktig tempo med videoen, men den bør også matche innholdet i videoen. For eksempel bør bilder fra en fest være sammenkoblet med energisk musikk, mens mer gjennomtenkte bilder bør ha tregere musikk vedlagt.

Selv om jeg ikke bruker denne funksjonen ofte, er datavitenskapen bak den ekstremt fascinerende. Den kombinerer gjenkjenning av gjenstander og landskap, grupperer bilder basert på innhold, plassering og tidsperiode, skiller gjennomsnittlige dag-for-dag-bilder fra bilder knyttet til spesielle liv hendelser, trekker en sammenheng mellom stemningen til disse bildene til stemningen til en sang du liker, parer dem i en lysbildefremvisning og ganger den presentasjonen i takt med musikk.

Memories har alltid brukt Neural Engine. Og den neste versjonen av iOS er satt til å øke intelligensen til denne funksjonen betydelig.

Varsler, widgeter og Ikke forstyrr blir smartere

En gruppering av iOS 15-funksjoner som drar større nytte av Neural Engine er varsler, widgets og Ikke forstyrr.

Widgets begynte å bruke maskinlæring i iOS 14, men jeg tenkte det ville være nyttig å legge dem til her. Smart Stacks lar deg legge widgets oppå hverandre. iPhone vil deretter bla gjennom dem i løpet av dagen, og vise deg hva den mener er den mest relevante widgeten til enhver tid.

Slike avgjørelser tas ved å analysere atferden din til forskjellige tider på dagen og etter bruk av bestemte apper. Neural Engine tar disse dataene, tolker dem og viser deretter widgetene dine i henhold til disse dataene.

Nye iOS 15-funksjoner er satt til å fungere veldig likt.

Varsler vil nå bli gruppert i et varslingssammendrag, slik at du ikke ser mindre viktige varsler som fortrenger låseskjermen din hele dagen. Du kan tilpasse funksjonen for varslingssammendrag, eller la Neural Engine håndtere det for deg.

Ikke forstyrr får en ny komponent, Focus, som vil skjule visse varsler basert på hvordan de er kategorisert. Du kan administrere Focus manuelt, eller la den styre seg selv intelligent.

Alle disse tre funksjonene kommer til å bruke ekstremt like maskinlæringsmålinger for å forutsi og tilpasse seg oppførselen din.

Nye iOS 15-funksjoner vil gjøre det enklere å få veibeskrivelse med kameraet ditt

Dette er en av iOS 15-funksjonene som jeg ikke har hørt så mye spenning om som jeg forventet. Jeg synes fortsatt det er veldig interessant, spesielt i en maskinlæringssammenheng.

I Maps i iOS 15 kan du peke kameraet rundt mens du går. Det vil tillate deg å se AR-retninger projisert på miljøet ditt. Si at du prøver å komme deg til kino og ikke er sikker på hvilken vei du skal ta. Du kan peke din iPhone rundt og se veibeskrivelser uthevet på gatene og bygningene rundt deg.

Augmented Reality på iPhone ble gjort mulig ved inkluderingen av Neural Engine, så denne funksjonen skylder sin opprinnelse til maskinlæring. Men denne funksjonen kombinerer også AR med bildegjenkjenning og stedsdeteksjon for å gi en utrolig sanntidsopplevelse.

Selv om den bare kommer til å være tilgjengelig i noen få byer ved lansering, peker denne funksjonen på en fremtid der maskinlæring på iPhone ikke bare hjelper deg i bakgrunnen. Det vil kunne hjelpe deg å oppnå ting umiddelbart som er utenfor din komfortsone eller evne.

Siri vil gjøre mer behandling på enheten din

Den siste av iOS 15-funksjonene som drar større fordel av Neural Engine er Siri. Siri har alltid brukt maskinlæring. Men den læringen har ikke maksimert potensialet til Neural Engine ennå.

Det er fordi Siri har brukt prosessering utenfor enheten. Det betyr at iPhone lytter til forespørselen din, sender den til en Apple-server som behandler forespørselen, og sender den deretter tilbake til Siri på iPhone for å reagere på forespørselen.

Grunnen til at dette ble gjort var å øke kraften til Siri utover det iPhone kunne støtte. I iOS 15 er dette imidlertid satt til å endre seg. Siri vil nå gjøre mesteparten av behandlingen på din iPhone. Det burde gjøre Siri raskere, smartere og mer pålitelig.

Jeg tror denne oppdateringen sannsynligvis vil kreve minst hjelp fra Neural Engine. Derav plasseringen på slutten av listen. Det er imidlertid verdt å merke seg, siden det peker på at Siri blir smartere. En mer dyktig assistent som bruker maskinvaren på iPhone, ikke en fjern server.

Hva kan Neural Engine gjøre uten de kommende iOS 15-funksjonene?

Og det er det! Så vidt jeg kan fortelle, er det alle de nye måtene iOS 15-funksjoner kommer til å begynne å bruke den nevrale motorens råkraft på.

Jeg ønsket å inkludere et kort avsnitt på slutten av dette innlegget som fremhever noen av tingene som Neural Engine allerede gjør på iPhone. På den måten kan du sammenligne hvor den er i dag med hvor den kommer til å være om noen måneder.

Forhåpentligvis vil dette hjelpe deg å sette pris på de kommende endringene til iOS i et nytt lys og bedre forstå hvordan funksjoner som dette kommer til din iPhone.

Neural Engine hjelper deg å ta bedre bilder

Jeg vil si at den største bruken av Neural Engine på iPhone siden 2017 har vært innen fotografering. Hvert år viser Apple hvordan den nyeste iPhone kommer til å kunne utføre flere fotografiske beregninger enn forrige generasjon. Apple sier ting som: "Bildeprosessoren gjør X millioner beregninger/beslutninger per bilde".

Dette refererer til antall beregninger Neural Engine gjør når du tar et bilde. Den ser på farger, lyssetting, kontrastelementer, motiv, bakgrunn og en rekke andre faktorer. Og det avgjør hvordan man best graderer, justerer, absorberer og balanserer alle disse elementene på et øyeblikk.

Det er denne maskinlæringsprosessen som har gjort ting som Portrettmodus og Deep Fusion mulig. Portrettmodus kan isolere deg fra bakgrunnen din, og Deep Fusion har gjort nattfotografering på iPhone vesentlig bedre enn før.

Neural Engine er kritisk for iPhone-kameraet på grunn av maskinvarebegrensninger. På grunn av iPhone-størrelsen er kameraet og dets linser begrenset i kapasitet. Det er databehandlingen og maskinlæringen som skjer når du tar et bilde som gjør iPhone-fotograferingen på nivå med bilder fra en profesjonell DSLR.

Maskinlæring gjør FaceID raskt, sikkert og tilpasningsdyktig

Selvfølgelig kan vi ikke snakke om nevralmotoren uten å nevne hvorfor den ble opprettet.

Det stemmer – Neural Engine ble lagt til iPhone X for å gjøre FaceID mulig. I tilfelle du ikke visste det, er FaceID en av de mest sofistikerte og komplekse funksjonene til din iPhone.

FaceID sammenligner ikke bare 2D-bildet av ansiktet ditt i selfie-kameraet med et annet 2D-bilde av ansiktet ditt. Den ser på et 3D-kart av ansiktet ditt, sporer øyebevegelsene dine og sammenligner det med en tidligere 3D-skanning av ansiktet ditt.

FaceID gjør ikke bare dette på mindre enn to sekunder mens ansiktet ditt er i bevegelse, delvis skjult og i forskjellige vinkler. Den tilpasser seg også måten ansiktet ditt subtilt endrer seg fra dag til dag. Det er derfor du kan vokse skjegg, bli eldre og forandre deg på andre subtile måter uten å måtte skanne ansiktet ditt på nytt.

FaceID og Neural Engine studerer og lærer av ansiktet ditt hver gang du låser opp iPhone. Uten nevralmotoren ville ikke FaceID vært halvparten så rask, sikker eller pålitelig som den er i dag.

Neural Engine spiller en nøkkelrolle i AR-opplevelser på iPhone

Endelig spiller Neural Engine en nøkkelrolle i AR på iPhone. For de som ikke vet, er Augmented Reality (AR) en funksjon som projiserer 3D-modeller på miljøet ditt gjennom iPhone-kameraets søker. Du kan teste dette ut selv ved å bruke Mål-appen på din iPhone.

Denne typen funksjoner kombinerer ting som bildegjenkjenning, romlig bevissthet og minne. Alt dette krever kraften som Neural Engine bringer til bordet.

Heldigvis er mange av de nye iOS 15-funksjonene satt til å gjøre AR på iPhone enda kraftigere. Det er en trend jeg håper fortsetter, siden jeg tror AR har potensialet til å være en av de mest integrerte funksjonene til mobile enheter.

De kommende iOS 15-funksjonene peker mot en smartere fremtid for iPhone

I det hele tatt er jeg veldig spent på fremtiden disse iOS 15-funksjonene gir oss et glimt av. Det er flere aspekter ved iPhone som føles litt underutnyttet, men få så mye som Neural Engine har vært. Jeg ser frem til at dette endrer seg, og håper du gjør det også!

For flere nyheter, innsikt og tips om alt som har med Apple å gjøre, sjekk ut resten av AppleToolBox-bloggen!