Während dem Anschauen die WWDC21-Keynote Vor ein paar Wochen bemerkte ich ein wiederkehrendes Thema. Und dieses Thema ist, dass einige der kommenden iOS 15-Funktionen die Neural Engine des iPhones zu nutzen scheinen.

Die Neural Engine ist seit der Veröffentlichung des iPhone X im Jahr 2017 im iPhone enthalten. Ich glaube jedoch, dass die meisten von uns die Auswirkungen dieses Prozessors in den vier Jahren seit seiner ersten Veröffentlichung überhaupt nicht gespürt haben.

WWDC21 hat mir immer wieder das Gefühl gegeben, dass iOS 15 das erste futuristische iOS-Update seit langer Zeit ist. Und obwohl es keine offizielle Bestätigung von Apple dazu gibt, glaube ich, dass Apple die Neural Engine endlich voll ausnutzt.

In diesem Beitrag werde ich kurz behandeln, was die Neural Engine ist, und dann in alle neuen iOS 15-Funktionen eintauchen, die diesen Prozessor anscheinend voll ausschöpfen. Gegen Ende werde ich die wichtigsten Möglichkeiten behandeln, in denen iOS derzeit die Neural Engine verwendet, damit Sie sie mit der kommenden iOS 15-Version vergleichen können.

Okay, lass uns einsteigen!

Inhalt

- Was ist die Neural Engine auf dem iPhone?

-

Wie die Funktionen von iOS 15 beginnen, die neuronale Engine zu nutzen

- Dein iPhone kann Text in deinen Fotos lesen

- Mit den iOS 15-Funktionen kann Ihr iPhone Inhalte in Ihren Fotos erkennen und identifizieren

- Erinnerungen in Fotos werden anspruchsvoller und fühlen sich „echt“ an

- Benachrichtigungen, Widgets und „Bitte nicht stören“ werden immer intelligenter

- Neue iOS 15-Funktionen machen es einfacher, Wegbeschreibungen mit Ihrer Kamera zu erhalten

- Siri wird mehr Verarbeitung auf deinem Gerät durchführen

-

Was kann die Neural Engine ohne die kommenden iOS 15-Funktionen tun?

- Die Neural Engine hilft Ihnen, bessere Bilder zu machen

- Machine Learning macht FaceID schnell, sicher und anpassungsfähig

- Die Neural Engine spielt eine Schlüsselrolle bei AR-Erlebnissen auf dem iPhone

-

Die kommenden iOS 15-Funktionen weisen auf eine intelligentere Zukunft für das iPhone hin

- Zusammenhängende Posts:

Was ist die Neural Engine auf dem iPhone?

Die Neural Engine ist ein Prozessor auf dem iPhone X und höher, der maschinelle Lernvorgänge durchführt. Es ist die Fähigkeit dieses Prozessors, maschinelles Lernen zu unterstützen, die ihn so wichtig macht. Daher ist es wichtig, maschinelles Lernen zu verstehen, um diesen Prozessor zu verstehen.

Machine Learning bezieht sich auf Software, die unabhängig von einem Programmierer Entscheidungen darüber trifft, welcher Code ausgeführt werden soll.

Normalerweise muss Software mit sehr spezifischen und kontrollierten Daten arbeiten. Aus diesem Grund wird Siri Ihre Absicht mit einem Satz verstehen, aber nicht mit einem anderen – selbst wenn die Absicht in jedem Satz identisch ist. Siri benötigt die Daten in einer bestimmten Struktur, oder es schlägt fehl.

Maschinelles Lernen ist eine Möglichkeit, dies zu ändern. Es ermöglicht Software, weniger strukturierte Daten aufzunehmen und dennoch zu verarbeiten. Wenn Sie jemals überrascht sind, dass Siri eine seltsam formulierte Anfrage verstanden hat, liegt dies wahrscheinlich daran, dass sich Siris maschinelle Lernfähigkeiten verbessert haben.

Die Neural Engine ist, wie der Name schon sagt, die Engine Ihres Telefons, die dies ermöglicht.

Mir ist klar, dass diese Konzepte etwas schwer zu verstehen sein können, und ich weiß, dass ich sie möglicherweise nicht optimal erklären kann. Ich versuche, die Dinge für diesen Beitrag kurz und einfach zu halten, aber wenn Sie tiefer eintauchen möchten, sollten Sie es sich ansehen dieser Beitrag!

Wie die Funktionen von iOS 15 beginnen, die neuronale Engine zu nutzen

Das Problem mit der Neural Engine des iPhones ist nicht, dass sie nicht leistungsstark ist, sondern dass ihre Leistung auf dem iPhone nicht vollständig genutzt wird. In den letzten vier Jahren wurde es in begrenzten Fällen wie Augmented Reality eingesetzt. Es ist hilfreich, aber es hat das iPhone noch nicht revolutioniert.

Ich denke, mehrere iOS 15-Funktionen weisen auf eine revolutionärere Zukunft für die Neural Engine hin. Ich glaube, dass keine der neuen Funktionen, die ich im Folgenden aufschlüsseln werde, ohne diesen Prozessor möglich wäre. Sehen wir uns also an, wie diese Funktionen die Neural Engine optimal nutzen.

Dein iPhone kann Text in deinen Fotos lesen

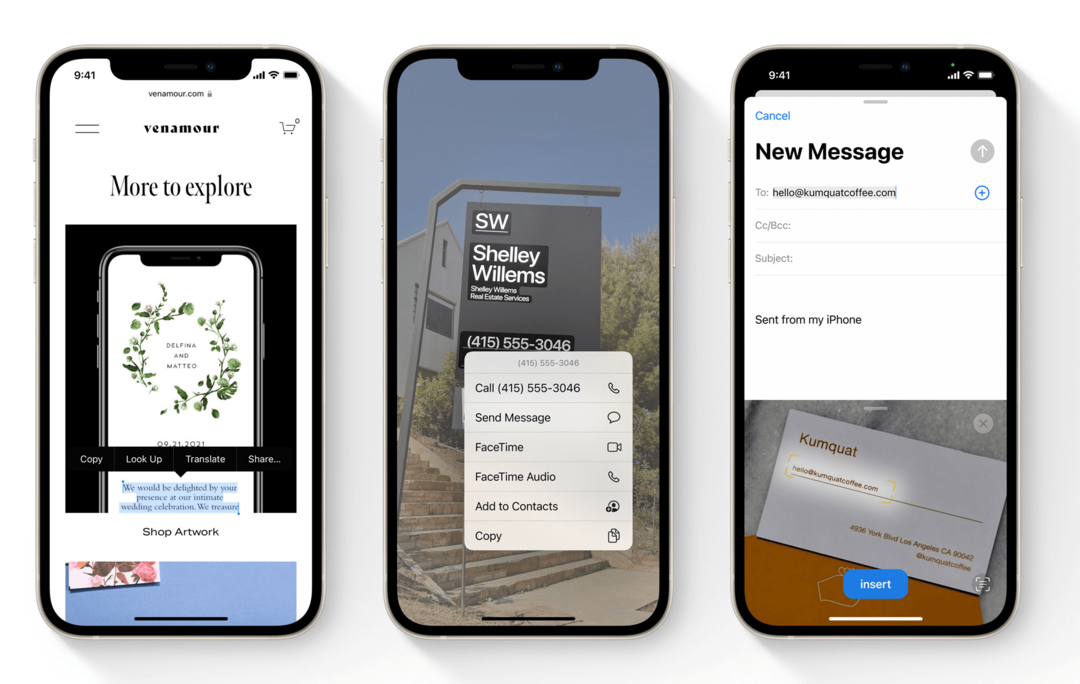

Die erste der iOS 15-Funktionen, die "Maschinelles Lernen!" für mich war Live-Text. Live Text ist eine Funktion in iOS 15, mit der Ihr iPhone Text in Ihrer Fotos-App lesen kann.

Das bedeutet, dass Sie ein Foto von allem mit gedrucktem Text machen können, dieses Foto in der Fotos-App öffnen und mit diesem Text interagieren können. Sie können auf Telefonnummern in Fotos tippen, Text aus Bildern von Dokumenten kopieren und einfügen und die Suchleiste in Fotos verwenden, um nach Text in Fotos zu suchen.

Diese Funktion ermöglicht es Ihrem iPhone auch, Handschriften in Ihren Fotos zu lesen. Es funktioniert auch mit der Kamera-App, sodass Sie in Echtzeit mit Text im Sucher Ihrer iPhone-Kamera interagieren können.

Ohne maschinelles Lernen wäre eine solche Funktion fast unmöglich. Aus diesem Grund verwenden diese Online-Sicherheitstests verzerrten Text, um zu beweisen, dass Sie kein Roboter sind. Weil es für ein Programm eine Herausforderung ist, Text lesen zu können.

Eine Smartphone-Funktion, die Text unabhängig von Schriftart, Stil, Farbe oder Winkel in Echtzeit lesen kann, ist nicht nur äußerst nützlich, sondern auch eine hervorragende Möglichkeit für mobiles maschinelles Lernen.

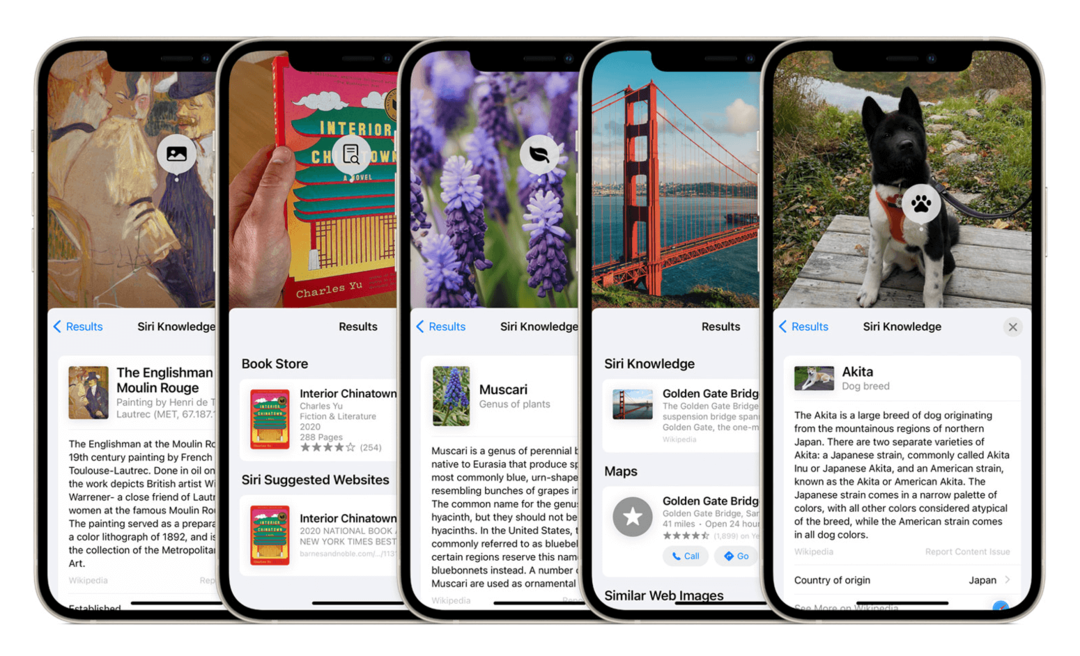

Mit den iOS 15-Funktionen kann Ihr iPhone Inhalte in Ihren Fotos erkennen und identifizieren

Eine weitere der neuen iOS 15-Funktionen, die die Neural Engine verwenden, ist die Objekterkennung in Fotos. Diese Funktion funktioniert ähnlich wie Live Text, außer dass sie Objekte anstelle von Text erkennt. Das von Apple verwendete Beispiel ist, dass Sie Ihre iPhone-Kamera auf einen Hund richten können, und Ihr iPhone erkennt nicht nur, dass es sich um einen Hund handelt, sondern auch um welche Hunderasse es sich handelt.

Das iPhone kann seit einiger Zeit Gesichter aus Ihren Fotos herausziehen, was eine Form der Objekterkennung ist, wenn auch eingeschränkt. Diese Erweiterung dieser Funktion ermöglicht es Ihrem iPhone, die unstrukturierten Daten eines Fotos und darin enthaltene Identitätsobjekte schnell anzuzeigen.

Dies ist beeindruckender (und schwieriger) als Live Text, da die Muster, nach denen die Neural Engine suchen muss, weit weniger konsistent sind. Ihr iPhone muss Tausende (wenn nicht Hunderttausende) von Entscheidungen treffen, um solche Entscheidungen treffen zu können.

Um eine Hunderasse zu identifizieren, muss er zuerst sehen, dass ein Hund ein vom Hintergrund getrenntes Objekt ist, dann muss er Grenzen um diesen Hund ziehen Wählen Sie verschiedene Merkmale dieses Hundes aus, bis er feststellen kann, dass es sich um einen Hund handelt, und ziehen Sie dann noch mehr Merkmale heraus, um festzustellen, um welche Art von Hund es sich handelt ist.

Diese Art des Rechnens ist nur mit einem Machine-Learning-Prozessor möglich.

Erinnerungen in Fotos werden anspruchsvoller und fühlen sich „echt“ an

Eine weitere Funktion in der Fotos-App, die eine Neural Engine-Nachbesserung erhalten wird, ist Memories.

Diese Funktion nimmt Fotos von einer bestimmten Zeit (normalerweise einem bestimmten Tag) auf und kombiniert sie in einem kurzen Video, damit Sie es anzeigen können. Die Idee ist, dass Memories automatisch Videocollagen Ihrer Ferien, Partys, Jubiläen und mehr erstellt.

Erinnerungen sind eine weitere der iOS 15-Funktionen, die eine deutliche Verbesserung der Qualität erfahren. Es fügt automatisch Musik aus Ihrer Apple Music-Bibliothek in Ihre Erinnerungen ein.

Die von Photos ausgewählte Musik wird nicht nur dem Video angemessen angepasst, sondern sollte auch zum Inhalt des Videos passen. Zum Beispiel sollten Bilder von einer Party mit energiegeladener Musik kombiniert werden, während nachdenklichere Fotos langsamere Musik haben sollten.

Obwohl ich diese Funktion nicht oft nutze, ist die Informatik dahinter äußerst faszinierend. Es kombiniert Objekt- und Landschaftserkennung, gruppiert Fotos nach Inhalt, Ort und Zeitraum, trennt durchschnittliche Alltagsfotos von Fotos, die mit besonderem Leben verbunden sind Ereignisse, stellt eine Verbindung zwischen der Stimmung dieser Fotos und der Stimmung eines Liedes her, das Sie mögen, kombiniert sie in einer Diashow-Präsentation und taktet diese Präsentation im Takt der Musik.

Memories verwendet seit jeher die Neural Engine. Und die nächste Version von iOS soll die Intelligenz dieser Funktion erheblich steigern.

Benachrichtigungen, Widgets und „Bitte nicht stören“ werden immer intelligenter

Eine Gruppe von iOS 15-Funktionen, die die Neural Engine stärker nutzen, sind Benachrichtigungen, Widgets und Nicht stören.

Widgets verwenden seit iOS 14 maschinelles Lernen, aber ich dachte, es wäre hilfreich, sie hier hinzuzufügen. Mit Smart Stacks können Sie Widgets übereinander legen. Ihr iPhone durchblättert sie dann im Laufe des Tages und zeigt Ihnen, welches Widget es zu einem bestimmten Zeitpunkt für das relevanteste hält.

Solche Entscheidungen werden getroffen, indem Sie Ihr Verhalten zu verschiedenen Tageszeiten und nach der Verwendung bestimmter Apps analysieren. Die Neural Engine nimmt diese Daten, interpretiert sie und zeigt dann Ihre Widgets entsprechend diesen Daten an.

Die neuen Funktionen von iOS 15 sollen sehr ähnlich funktionieren.

Benachrichtigungen werden jetzt in einer Benachrichtigungszusammenfassung gruppiert, sodass Sie nicht den ganzen Tag über weniger wichtige Benachrichtigungen sehen, die Ihren Sperrbildschirm überfüllen. Sie können die Funktion „Benachrichtigungszusammenfassung“ anpassen oder die Neural Engine für Sie erledigen lassen.

Bitte nicht stören erhält eine neue Komponente, Focus, die bestimmte Benachrichtigungen basierend auf ihrer Kategorisierung ausblendet. Sie können Focus manuell verwalten oder ihn intelligent verwalten lassen.

Alle drei dieser Funktionen werden sehr ähnliche Machine-Learning-Metriken verwenden, um Ihr Verhalten vorherzusagen und sich an dieses anzupassen.

Neue iOS 15-Funktionen machen es einfacher, Wegbeschreibungen mit Ihrer Kamera zu erhalten

Dies ist eine der Funktionen von iOS 15, über die ich nicht so viel Aufregung gehört habe, wie ich erwartet hatte. Ich finde es immer noch sehr interessant, insbesondere im Kontext des maschinellen Lernens.

In Maps in iOS 15 können Sie Ihre Kamera beim Gehen herumführen. Auf diese Weise können Sie AR-Richtungen sehen, die auf Ihre Umgebung projiziert werden. Angenommen, Sie möchten ins Kino und sind sich nicht sicher, welchen Weg Sie nehmen sollen. Sie können Ihr iPhone herumführen und die Wegbeschreibungen auf den Straßen und Gebäuden um Sie herum hervorgehoben sehen.

Augmented Reality auf dem iPhone wurde durch die Integration der Neural Engine ermöglicht, daher verdankt diese Funktion ihren Ursprung dem maschinellen Lernen. Aber diese Funktion kombiniert AR mit Bilderkennung und Standorterkennung, um ein unglaubliches Echtzeiterlebnis zu bieten.

Obwohl es zum Start nur in wenigen Städten verfügbar sein wird, weist diese Funktion auf eine Zukunft hin, in der maschinelles Lernen auf dem iPhone nicht nur im Hintergrund hilft. Es wird Ihnen helfen, Dinge sofort zu erreichen, die außerhalb Ihrer Komfortzone oder Ihrer Fähigkeiten liegen.

Siri wird mehr Verarbeitung auf deinem Gerät durchführen

Die letzte der iOS 15-Funktionen, die die Neural Engine stärker nutzt, ist Siri. Siri hat schon immer maschinelles Lernen verwendet. Aber dieses Lernen hat das Potenzial der Neural Engine noch nicht ausgeschöpft.

Das liegt daran, dass Siri die Verarbeitung außerhalb des Geräts verwendet hat. Das heißt, Ihr iPhone hört auf Ihre Anfrage, sendet sie an einen Apple-Server, der die Anfrage verarbeitet, und sendet sie dann zurück an Siri auf Ihrem iPhone, um diese Anfrage zu bearbeiten.

Der Grund dafür war, die Leistung von Siri über das hinaus zu erhöhen, was das iPhone unterstützen konnte. In iOS 15 soll sich dies jedoch ändern. Siri erledigt nun den Großteil der Verarbeitung auf Ihrem iPhone. Das sollte Siri schneller, intelligenter und zuverlässiger machen.

Ich denke, dieses Update wird wahrscheinlich die geringste Unterstützung von der Neural Engine erfordern. Daher seine Platzierung am Ende der Liste. Es ist jedoch erwähnenswert, da dies darauf hindeutet, dass Siri schlauer wird. Ein leistungsfähigerer Assistent, der die Hardware des iPhones verwendet, kein weit entfernter Server.

Was kann die Neural Engine ohne die kommenden iOS 15-Funktionen tun?

Und das ist es! Soweit ich das beurteilen kann, sind dies alle neuen Möglichkeiten, mit denen iOS 15-Funktionen die rohe Leistung der Neural Engine nutzen werden.

Ich wollte am Ende dieses Beitrags einen kurzen Abschnitt einfügen, in dem einige der Dinge hervorgehoben werden, die die Neural Engine bereits auf Ihrem iPhone tut. Auf diese Weise können Sie vergleichen, wo es heute ist und wo es in ein paar Monaten sein wird.

Hoffentlich hilft Ihnen dies dabei, die bevorstehenden Änderungen an iOS in einem neuen Licht zu sehen und besser zu verstehen, wie Funktionen wie diese auf Ihr iPhone kommen.

Die Neural Engine hilft Ihnen, bessere Bilder zu machen

Ich würde sagen, dass die größte Verwendung der Neural Engine auf dem iPhone seit 2017 in der Fotografie liegt. Apple zeigt jedes Jahr, wie das neueste iPhone mehr fotografische Berechnungen durchführen kann als die vorherige Generation. Apple sagt Dinge wie: „Der Bildprozessor führt X Millionen Berechnungen/Entscheidungen pro Foto durch“.

Dies bezieht sich auf die Anzahl der Berechnungen, die die Neural Engine bei jeder Aufnahme durchführt. Es betrachtet Farben, Beleuchtung, kontrastierende Elemente, Motiv, Hintergrund und eine Vielzahl anderer Faktoren. Und es bestimmt, wie all diese Elemente im Handumdrehen am besten bewertet, angepasst, absorbiert und ausgeglichen werden.

Es ist dieser maschinelle Lernprozess, der Dinge wie den Portrait-Modus und Deep Fusion möglich gemacht hat. Der Porträtmodus kann Sie von Ihrem Hintergrund isolieren, und Deep Fusion hat die Nachtfotografie auf dem iPhone wesentlich besser gemacht als zuvor.

Die Neural Engine ist aufgrund von Hardwarebeschränkungen für die Kamera Ihres iPhones von entscheidender Bedeutung. Aufgrund der Größe des iPhones sind die Funktionen der Kamera und ihrer Objektive eingeschränkt. Es ist das Computing und das maschinelle Lernen, das beim Aufnehmen eines Fotos stattfindet und Ihre iPhone-Fotografie mit Fotos einer professionellen DSLR vergleichbar macht.

Machine Learning macht FaceID schnell, sicher und anpassungsfähig

Natürlich können wir nicht über die Neural Engine sprechen, ohne zu erwähnen, warum sie erstellt wurde.

Das ist richtig – die Neural Engine wurde dem iPhone X hinzugefügt, um FaceID zu ermöglichen. Falls Sie es nicht wussten, FaceID ist eine der anspruchsvollsten und komplexesten Funktionen Ihres iPhones.

FaceID vergleicht nicht nur das 2D-Bild deines Gesichts in der Selfie-Kamera mit einem anderen 2D-Bild deines Gesichts. Es betrachtet eine 3D-Karte Ihres Gesichts, verfolgt Ihre Augenbewegungen und vergleicht sie mit einem vorherigen 3D-Scan Ihres Gesichts.

FaceID erledigt dies nicht nur in weniger als zwei Sekunden, während Ihr Gesicht in Bewegung, teilweise verdeckt und in unterschiedlichen Winkeln ist. Es passt sich auch der Art und Weise an, wie sich Ihr Gesicht von Tag zu Tag subtil verändert. Aus diesem Grund können Sie sich einen Bart wachsen lassen, älter werden und sich auf andere subtile Weise verändern, ohne Ihr Gesicht erneut scannen zu müssen.

FaceID und die Neural Engine studieren und lernen von Ihrem Gesicht jedes Mal, wenn Sie Ihr iPhone entsperren. Ohne die Neural Engine wäre FaceID nicht halb so schnell, sicher oder zuverlässig wie heute.

Die Neural Engine spielt eine Schlüsselrolle bei AR-Erlebnissen auf dem iPhone

Schließlich spielt die Neural Engine eine Schlüsselrolle bei AR auf dem iPhone. Für diejenigen, die es nicht wissen, ist Augmented Reality (AR) eine Funktion, die 3D-Modelle über den Sucher Ihrer iPhone-Kamera auf Ihre Umgebung projiziert. Sie können dies selbst testen, indem Sie die Measure-App auf Ihrem iPhone verwenden.

Diese Art von Funktion kombiniert Dinge wie Bilderkennung, räumliche Wahrnehmung und Gedächtnis. All dies erfordert die Leistung, die die Neural Engine auf den Tisch bringt.

Glücklicherweise sollen viele der neuen iOS 15-Funktionen AR auf dem iPhone noch leistungsfähiger machen. Es ist ein Trend, von dem ich hoffe, dass er sich fortsetzt, da ich denke, dass AR das Potenzial hat, eines der wichtigsten Merkmale von Mobilgeräten zu werden.

Die kommenden iOS 15-Funktionen weisen auf eine intelligentere Zukunft für das iPhone hin

Im Großen und Ganzen freue ich mich sehr auf die Zukunft, auf die uns diese iOS 15-Funktionen einen Einblick geben. Es gibt mehrere Facetten des iPhones, die sich etwas ungenutzt anfühlen, aber nur wenige so sehr wie die Neural Engine. Ich freue mich auf diese Veränderung und hoffe, Sie auch!

Weitere Neuigkeiten, Einblicke und Tipps rund um Apple finden Sie im Rest von der AppleToolBox-Blog!